VO

Size: a a a

2020 June 18

угу, 432 бакса за штуку. найти ксеноны подешевле, новые и не совсем позорные -- та еще задача. а что бы дохера памяти напихать надо как раз что-то такое.

VO

один хер дисков и памяти туда засунуто приемрно на сумму примерно в 10 раз больше

2020 June 19

k

угу, 432 бакса за штуку. найти ксеноны подешевле, новые и не совсем позорные -- та еще задача. а что бы дохера памяти напихать надо как раз что-то такое.

Это ж старые CPU, 2017 года. 4210 надо брать, я такие и взял в этом году.

PA

всем привет, парни, подскажите в какую сторону копать.

есть кластер с cephfs на ~230M объектов, клиентов подключено аж два: рсинк, который туда льет файлы и вебсервер, который их раздает. 12 осд кешируются бкешем плюс отдельный db на ssd. иопсов не сильно много, в пределах 2-3к, характер нагрузки постоянный, она там есть уже несколько суток.

периодически всю эту конструкцию рвет в клочья - slow ops на osd и mds, краши осд, заморозка работы с клиентами и т.д. потом все восстанавливается и часами работает нормально.

чую бесовщину, но что крутить в первую очередь - пока не могу понять. само железо точно живое, к нему вопросов нет. из того, что гарантированно вызывает такое поведение пока нашел только ручной вызов osd compact, куда еще надо посмотреть?

есть кластер с cephfs на ~230M объектов, клиентов подключено аж два: рсинк, который туда льет файлы и вебсервер, который их раздает. 12 осд кешируются бкешем плюс отдельный db на ssd. иопсов не сильно много, в пределах 2-3к, характер нагрузки постоянный, она там есть уже несколько суток.

периодически всю эту конструкцию рвет в клочья - slow ops на osd и mds, краши осд, заморозка работы с клиентами и т.д. потом все восстанавливается и часами работает нормально.

чую бесовщину, но что крутить в первую очередь - пока не могу понять. само железо точно живое, к нему вопросов нет. из того, что гарантированно вызывает такое поведение пока нашел только ручной вызов osd compact, куда еще надо посмотреть?

IF

всем привет, парни, подскажите в какую сторону копать.

есть кластер с cephfs на ~230M объектов, клиентов подключено аж два: рсинк, который туда льет файлы и вебсервер, который их раздает. 12 осд кешируются бкешем плюс отдельный db на ssd. иопсов не сильно много, в пределах 2-3к, характер нагрузки постоянный, она там есть уже несколько суток.

периодически всю эту конструкцию рвет в клочья - slow ops на osd и mds, краши осд, заморозка работы с клиентами и т.д. потом все восстанавливается и часами работает нормально.

чую бесовщину, но что крутить в первую очередь - пока не могу понять. само железо точно живое, к нему вопросов нет. из того, что гарантированно вызывает такое поведение пока нашел только ручной вызов osd compact, куда еще надо посмотреть?

есть кластер с cephfs на ~230M объектов, клиентов подключено аж два: рсинк, который туда льет файлы и вебсервер, который их раздает. 12 осд кешируются бкешем плюс отдельный db на ssd. иопсов не сильно много, в пределах 2-3к, характер нагрузки постоянный, она там есть уже несколько суток.

периодически всю эту конструкцию рвет в клочья - slow ops на osd и mds, краши осд, заморозка работы с клиентами и т.д. потом все восстанавливается и часами работает нормально.

чую бесовщину, но что крутить в первую очередь - пока не могу понять. само железо точно живое, к нему вопросов нет. из того, что гарантированно вызывает такое поведение пока нашел только ручной вызов osd compact, куда еще надо посмотреть?

deep-scrub такое вызывает

AK

всем привет, парни, подскажите в какую сторону копать.

есть кластер с cephfs на ~230M объектов, клиентов подключено аж два: рсинк, который туда льет файлы и вебсервер, который их раздает. 12 осд кешируются бкешем плюс отдельный db на ssd. иопсов не сильно много, в пределах 2-3к, характер нагрузки постоянный, она там есть уже несколько суток.

периодически всю эту конструкцию рвет в клочья - slow ops на osd и mds, краши осд, заморозка работы с клиентами и т.д. потом все восстанавливается и часами работает нормально.

чую бесовщину, но что крутить в первую очередь - пока не могу понять. само железо точно живое, к нему вопросов нет. из того, что гарантированно вызывает такое поведение пока нашел только ручной вызов osd compact, куда еще надо посмотреть?

есть кластер с cephfs на ~230M объектов, клиентов подключено аж два: рсинк, который туда льет файлы и вебсервер, который их раздает. 12 осд кешируются бкешем плюс отдельный db на ssd. иопсов не сильно много, в пределах 2-3к, характер нагрузки постоянный, она там есть уже несколько суток.

периодически всю эту конструкцию рвет в клочья - slow ops на osd и mds, краши осд, заморозка работы с клиентами и т.д. потом все восстанавливается и часами работает нормально.

чую бесовщину, но что крутить в первую очередь - пока не могу понять. само железо точно живое, к нему вопросов нет. из того, что гарантированно вызывает такое поведение пока нашел только ручной вызов osd compact, куда еще надо посмотреть?

метадату вынести на лол-флэш пул.

PA

deep-scrub такое вызывает

это да, их насобиралось немного пока кластер перебирали, но вроде они постоянно идут?

IF

конечно. Артемий вам подкинул решение

PA

конечно. Артемий вам подкинул решение

ага, спасибо, этого еще не пробовали, будем крутить

Am

ага, спасибо, этого еще не пробовали, будем крутить

это первое что надо делать с cephfs при наличии хоть каких то ссд )))

PA

это первое что надо делать с cephfs при наличии хоть каких то ссд )))

да мы уже куда только эти ссд не пробовали пихать, экспериментируем же на ходу :)

PA

пока было 150М объектов, все жило красиво, сейчас такой нежданчик вылез, учимся :)

RS

пока было 150М объектов, все жило красиво, сейчас такой нежданчик вылез, учимся :)

На с3 переползать

PA

а как правильно будет собрать такой пул, если краш считает что у нас и так оллфлеш из-за бкеша?

1. создать новый класс в краше

2. добавить новые девайсы, сменить класс на новый

3. собрать из этого класса пул, отсинкать метадату

4. стопнуть мдс, переименовать пул метадаты

правильно?

1. создать новый класс в краше

2. добавить новые девайсы, сменить класс на новый

3. собрать из этого класса пул, отсинкать метадату

4. стопнуть мдс, переименовать пул метадаты

правильно?

PA

На с3 переползать

в нашем случае не вариант

RS

в нашем случае не вариант

Очень даже вариант. Тут раз 50 точно обсуждали что для таких задач с3 самое то

PA

Очень даже вариант. Тут раз 50 точно обсуждали что для таких задач с3 самое то

там не только цеффс будет, просто есть живой клиент с большим количеством данных, который может сгенерить реальную нагрузку - на нем и тестируем

Am

а как правильно будет собрать такой пул, если краш считает что у нас и так оллфлеш из-за бкеша?

1. создать новый класс в краше

2. добавить новые девайсы, сменить класс на новый

3. собрать из этого класса пул, отсинкать метадату

4. стопнуть мдс, переименовать пул метадаты

правильно?

1. создать новый класс в краше

2. добавить новые девайсы, сменить класс на новый

3. собрать из этого класса пул, отсинкать метадату

4. стопнуть мдс, переименовать пул метадаты

правильно?

нарезать разделы

задеплоить осд

сделать класс

назначить клас осд

сделать правило

протестировать правило

сменить правило на метапуле

как-то так

задеплоить осд

сделать класс

назначить клас осд

сделать правило

протестировать правило

сменить правило на метапуле

как-то так

PA

нарезать разделы

задеплоить осд

сделать класс

назначить клас осд

сделать правило

протестировать правило

сменить правило на метапуле

как-то так

задеплоить осд

сделать класс

назначить клас осд

сделать правило

протестировать правило

сменить правило на метапуле

как-то так

спасибо! будем пробовать :)

KA

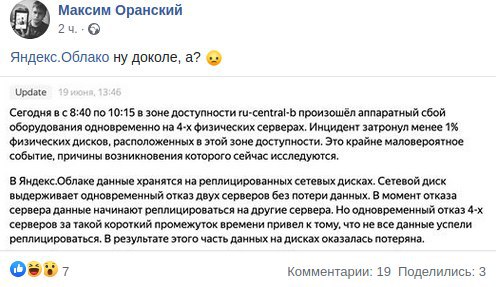

Было уже?