Привет, подскажите пожалуйста с чем может быть связано. Пытаюсь сделать ALTER TABLE ... DELETE на таблице 5 млрд записей, получаю в ответ

Received exception from server (version 20.3.5):

Code: 999. DB::Exception: Received from localhost:9000. DB::Exception: Connection loss.

0 rows in set. Elapsed: 0.967 sec.

И в логе вот такая ошибка

zkutil::EphemeralNodeHolder::~EphemeralNodeHolder(): Code: 999, e.displayText() = Coordination::Exception: Session expired (Session expired), Stack trace (when copying this m

essage, always include the lines below):

0. Poco::Exception::Exception(std::__1::basic_string<char, std::__1::char_traits<char>, std::__1::allocator<char> > const&, int) @ 0x1050f0d0 in /usr/bin/clickhouse

1. DB::Exception::Exception(std::__1::basic_string<char, std::__1::char_traits<char>, std::__1::allocator<char> > const&, int) @ 0x8f3272d in /usr/bin/clickhouse

2. Coordination::Exception::Exception(std::__1::basic_string<char, std::__1::char_traits<char>, std::__1::allocator<char> > const&, int, int) @ 0xdee56b8 in /usr/bin/clickhouse

3. Coordination::Exception::Exception(std::__1::basic_string<char, std::__1::char_traits<char>, std::__1::allocator<char> > const&, int) @ 0xdee5ce2 in /usr/bin/clickhouse

4. ? @ 0xdf19fe1 in /usr/bin/clickhouse

5. Coordination::ZooKeeper::remove(std::__1::basic_string<char, std::__1::char_traits<char>, std::__1::allocator<char> > const&, int, std::__1::function<void (Coordination::RemoveResponse const&)>) @ 0xdf14662 in /usr/bin/clickhouse

6. zkutil::ZooKeeper::tryRemove(std::__1::basic_string<char, std::__1::char_traits<char>, std::__1::allocator<char> > const&, int) @ 0xdeedffe in /usr/bin/clickhouse

7. std::__1::__shared_ptr_emplace<zkutil::EphemeralNodeHolder, std::__1::allocator<zkutil::EphemeralNodeHolder> >::__on_zero_shared() @ 0x911476e in /usr/bin/clickhouse

8. std::__1::__shared_ptr_emplace<zkutil::LeaderElection, std::__1::allocator<zkutil::LeaderElection> >::__on_zero_shared() @ 0xd7971aa in /usr/bin/clickhouse

9. std::__1::shared_ptr<zkutil::LeaderElection>::~shared_ptr() @ 0xd79a1f2 in /usr/bin/clickhouse

10. DB::StorageReplicatedMergeTree::exitLeaderElection() @ 0xd730387 in /usr/bin/clickhouse

11. DB::ReplicatedMergeTreeRestartingThread::partialShutdown() @ 0xdad9508 in /usr/bin/clickhouse

12. DB::ReplicatedMergeTreeRestartingThread::run() @ 0xdadee43 in /usr/bin/clickhouse

13. DB::BackgroundSchedulePoolTaskInfo::execute() @ 0xcfe5815 in /usr/bin/clickhouse

14. DB::BackgroundSchedulePool::threadFunction() @ 0xcfe5e32 in /usr/bin/clickhouse

а в ZOOKEEPER логе такой Exception:

java.io.IOException: Len error 1336468

at org.apache.zookeeper.server.NIOServerCnxn.readLength(

NIOServerCnxn.java:541)

at org.apache.zookeeper.server.NIOServerCnxn.doIO(

NIOServerCnxn.java:332)

at org.apache.zookeeper.server.NIOServerCnxnFactory$IOWorkRequest.doWork(

NIOServerCnxnFactory.java:522)

at org.apache.zookeeper.server.WorkerService$

ScheduledWorkRequest.run(

WorkerService.java:154)

at java.base/java.util.concurrent.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:1128)

at java.base/java.util.concurrent.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:628)

at java.base/java.lang.Thread.run(Thread.java:834)

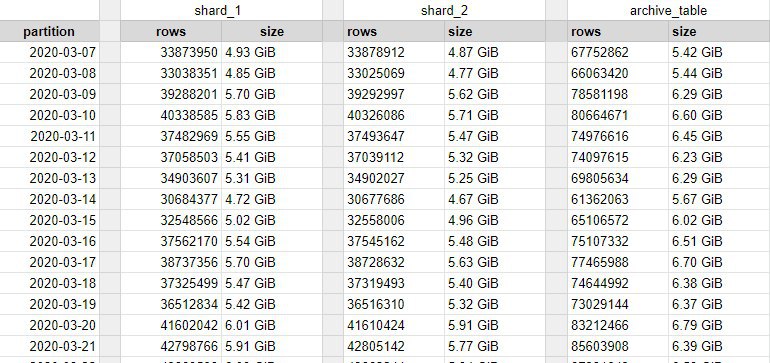

И такое происходит только с одной таблицей, другие две прошли без проблем, и по объему они не на много меньше.