S

Size: a a a

2021 March 04

Подскажите единицу измерения max_server_memory_usage ? Байты?

да

AS

хм, вы clickhouse-backup restore делаете при работающем clickhouse-server ?

Да, так

OG

Подскажите, пожалуйста, что сломано, если в логе много таких сообщений:

Table system.errors doesn't exist. (version 20.10.2.20 (official build))?DC

Подскажите, пожалуйста, что сломано, если в логе много таких сообщений:

Table system.errors doesn't exist. (version 20.10.2.20 (official build))?она вообще была в 20.10 ?

ее добавили вроде в 20.11

а кто ее читает? внешний мониторинтг?

ее добавили вроде в 20.11

а кто ее читает? внешний мониторинтг?

DC

6 шардов

INSERT INTO дистрибьютед1

SELECT FROM дистрибьютед2

JOIN дистрибьютед3

JOIN дистрибьютед4

INSERT INTO дистрибьютед1

SELECT FROM дистрибьютед2

JOIN дистрибьютед3

JOIN дистрибьютед4

и что все время ошибка на этом запросе или иногда?

EP

подскажите плз, есть таблица ts, data, в нее нужно залить данные из DataFrame, в котором тоже ts, data, но только те для которых нет ts, как это проще всего сделать

D

Dmutruu

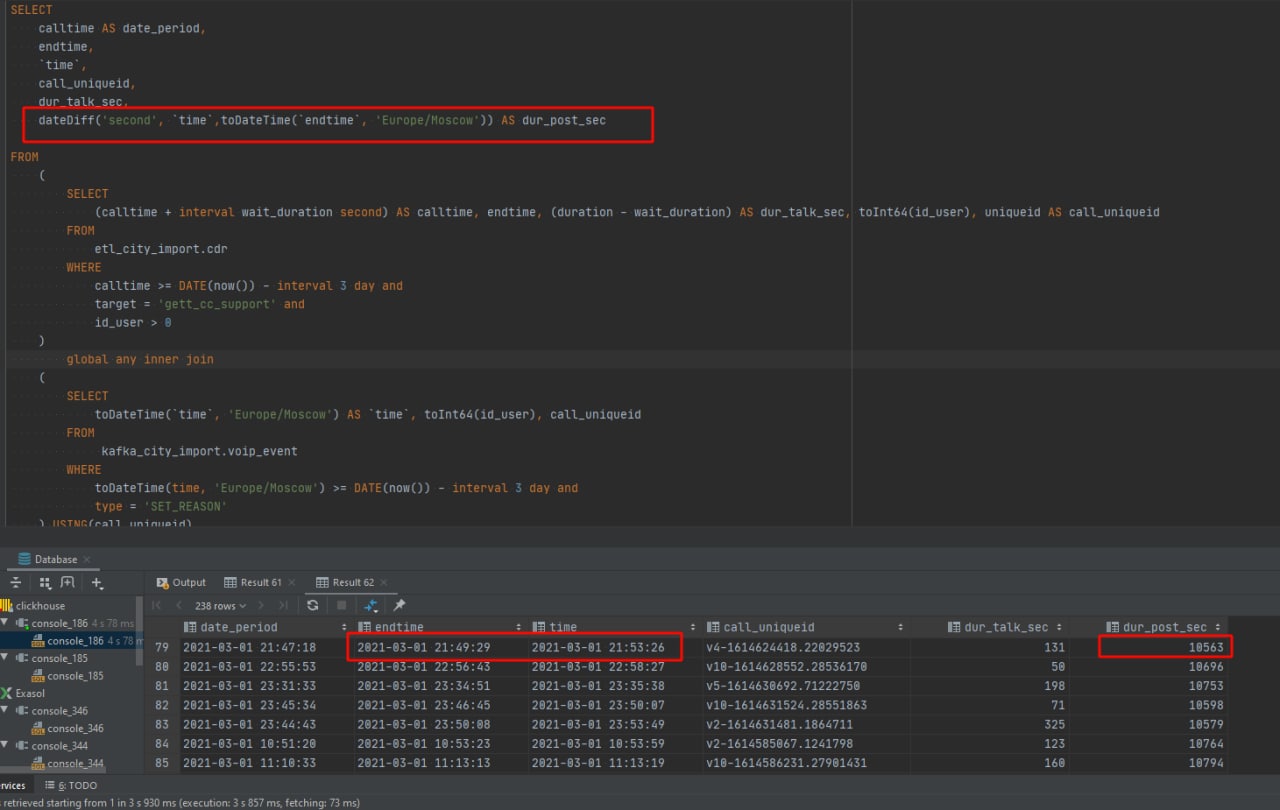

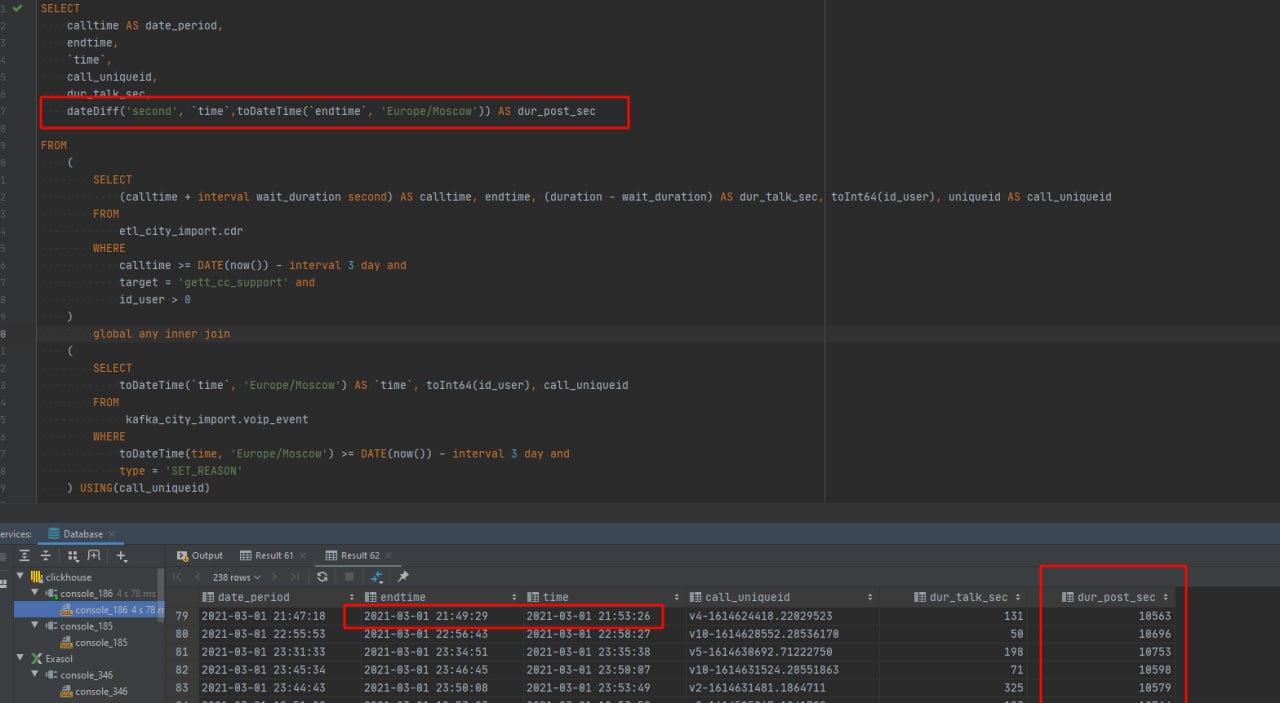

все равно также, нужна разница в секундах, а тут не понятно, что возвращается

P

Всем привет.

Такая ситуация, кликхаус очень и очень медленно инсертит данные, сейчас он добавляет в таблицу данные, которые туда инсертили еще вчера.

Кластер кликхауса, ReplicatedReplacingMergeTree таблицы, 2 шарда, по 2 ноды в каждой, инсертим записи через роутер. show processlist пустой.

Подскажите плиз, почему такое может быть, и что с этим можно сделать?

Такая ситуация, кликхаус очень и очень медленно инсертит данные, сейчас он добавляет в таблицу данные, которые туда инсертили еще вчера.

Кластер кликхауса, ReplicatedReplacingMergeTree таблицы, 2 шарда, по 2 ноды в каждой, инсертим записи через роутер. show processlist пустой.

Подскажите плиз, почему такое может быть, и что с этим можно сделать?

S

Да, так

не правильно

у вас background merge на текущем сервере запущеном сервере который мержит парты между собой

и потом вы делаете непонятно откуда взявшиеся restore которые тупо качают файлы в папку /var/lib/clickhouse/data

и потом делают ATTACH

естетсвенно у вас данные задваиваются

у вас часть данных старых в новых партах

и задваивается из тех что не смержены из старых партов

у вас background merge на текущем сервере запущеном сервере который мержит парты между собой

и потом вы делаете непонятно откуда взявшиеся restore которые тупо качают файлы в папку /var/lib/clickhouse/data

и потом делают ATTACH

естетсвенно у вас данные задваиваются

у вас часть данных старых в новых партах

и задваивается из тех что не смержены из старых партов

S

Всем привет.

Такая ситуация, кликхаус очень и очень медленно инсертит данные, сейчас он добавляет в таблицу данные, которые туда инсертили еще вчера.

Кластер кликхауса, ReplicatedReplacingMergeTree таблицы, 2 шарда, по 2 ноды в каждой, инсертим записи через роутер. show processlist пустой.

Подскажите плиз, почему такое может быть, и что с этим можно сделать?

Такая ситуация, кликхаус очень и очень медленно инсертит данные, сейчас он добавляет в таблицу данные, которые туда инсертили еще вчера.

Кластер кликхауса, ReplicatedReplacingMergeTree таблицы, 2 шарда, по 2 ноды в каждой, инсертим записи через роутер. show processlist пустой.

Подскажите плиз, почему такое может быть, и что с этим можно сделать?

что такое "роутер"? chproxy ?

как данные вставляете? в каком формате? какой размер батча во вставке? сколько одновременных вставок?

как данные вставляете? в каком формате? какой размер батча во вставке? сколько одновременных вставок?

YV

Всем привет.

Такая ситуация, кликхаус очень и очень медленно инсертит данные, сейчас он добавляет в таблицу данные, которые туда инсертили еще вчера.

Кластер кликхауса, ReplicatedReplacingMergeTree таблицы, 2 шарда, по 2 ноды в каждой, инсертим записи через роутер. show processlist пустой.

Подскажите плиз, почему такое может быть, и что с этим можно сделать?

Такая ситуация, кликхаус очень и очень медленно инсертит данные, сейчас он добавляет в таблицу данные, которые туда инсертили еще вчера.

Кластер кликхауса, ReplicatedReplacingMergeTree таблицы, 2 шарда, по 2 ноды в каждой, инсертим записи через роутер. show processlist пустой.

Подскажите плиз, почему такое может быть, и что с этим можно сделать?

Логи смотрели? У нас было подобное, когда фигачили в ReplicatedMergeTree клики в реалтайме - создавалось овердохера партов, которые потом медленно и печально в фоне мержились. В итоге добились как раз искомого отставания в сутки :)

Переделали логику на вставку через Buffer-таблицу - стало збс.

Переделали логику на вставку через Buffer-таблицу - стало збс.

AS

не правильно

у вас background merge на текущем сервере запущеном сервере который мержит парты между собой

и потом вы делаете непонятно откуда взявшиеся restore которые тупо качают файлы в папку /var/lib/clickhouse/data

и потом делают ATTACH

естетсвенно у вас данные задваиваются

у вас часть данных старых в новых партах

и задваивается из тех что не смержены из старых партов

у вас background merge на текущем сервере запущеном сервере который мержит парты между собой

и потом вы делаете непонятно откуда взявшиеся restore которые тупо качают файлы в папку /var/lib/clickhouse/data

и потом делают ATTACH

естетсвенно у вас данные задваиваются

у вас часть данных старых в новых партах

и задваивается из тех что не смержены из старых партов

спасибо

как в таком случае правильно накатывать данные?

может просто делать перед каждым рестором drop database?

только что это затестили - процесс практически моментальный (на 5тб данных)

как в таком случае правильно накатывать данные?

может просто делать перед каждым рестором drop database?

только что это затестили - процесс практически моментальный (на 5тб данных)

AS

спасибо

как в таком случае правильно накатывать данные?

может просто делать перед каждым рестором drop database?

только что это затестили - процесс практически моментальный (на 5тб данных)

как в таком случае правильно накатывать данные?

может просто делать перед каждым рестором drop database?

только что это затестили - процесс практически моментальный (на 5тб данных)

сервер не в продакшене, а больше как тестовый с копией данных из прода, поэтому краткий простой на время пока БД будет отсутвовать не критичен

S

спасибо

как в таком случае правильно накатывать данные?

может просто делать перед каждым рестором drop database?

только что это затестили - процесс практически моментальный (на 5тб данных)

как в таком случае правильно накатывать данные?

может просто делать перед каждым рестором drop database?

только что это затестили - процесс практически моментальный (на 5тб данных)

да, restore лучше делать в пустую базу

S

спасибо

как в таком случае правильно накатывать данные?

может просто делать перед каждым рестором drop database?

только что это затестили - процесс практически моментальный (на 5тб данных)

как в таком случае правильно накатывать данные?

может просто делать перед каждым рестором drop database?

только что это затестили - процесс практически моментальный (на 5тб данных)

еще тут можно спросить что нибудь

https://t.me/clickhousebackup

https://t.me/clickhousebackup

D

Всем привет, пытаюсь вычесть одну колонку из другой для получения значений в секундах, но получается ерунда какая то с аномальными значениями

D

AS

да, restore лучше делать в пустую базу

спасибо

так и будем делать

так и будем делать

D

тип данных у столбцов

P

что такое "роутер"? chproxy ?

как данные вставляете? в каком формате? какой размер батча во вставке? сколько одновременных вставок?

как данные вставляете? в каком формате? какой размер батча во вставке? сколько одновременных вставок?

на роуте distributed таблица, инсертим данные через нее.

данные вставляем сначала в редис, оттуда воркер их выгребает, делает их них один большой инсерт, и шлет его в кх. количество записей в инсерте — до 10к, но, зачастую их гораздо меньше(до 100).

одновременных вставок до 5 в секунду.

проблема в том что до этого было все ок, никто ничего не менял, т.е. по такой схеме оно работало давно и нормально

данные вставляем сначала в редис, оттуда воркер их выгребает, делает их них один большой инсерт, и шлет его в кх. количество записей в инсерте — до 10к, но, зачастую их гораздо меньше(до 100).

одновременных вставок до 5 в секунду.

проблема в том что до этого было все ок, никто ничего не менял, т.е. по такой схеме оно работало давно и нормально