SK

Size: a a a

2020 July 15

Но ведь в целом Спарк не про это, а про работу с разными источниками данных. Какая у вас задача что нужен именно метастор типа хайва?

Thrift?😅(почти hive) у него есть метастор

GT

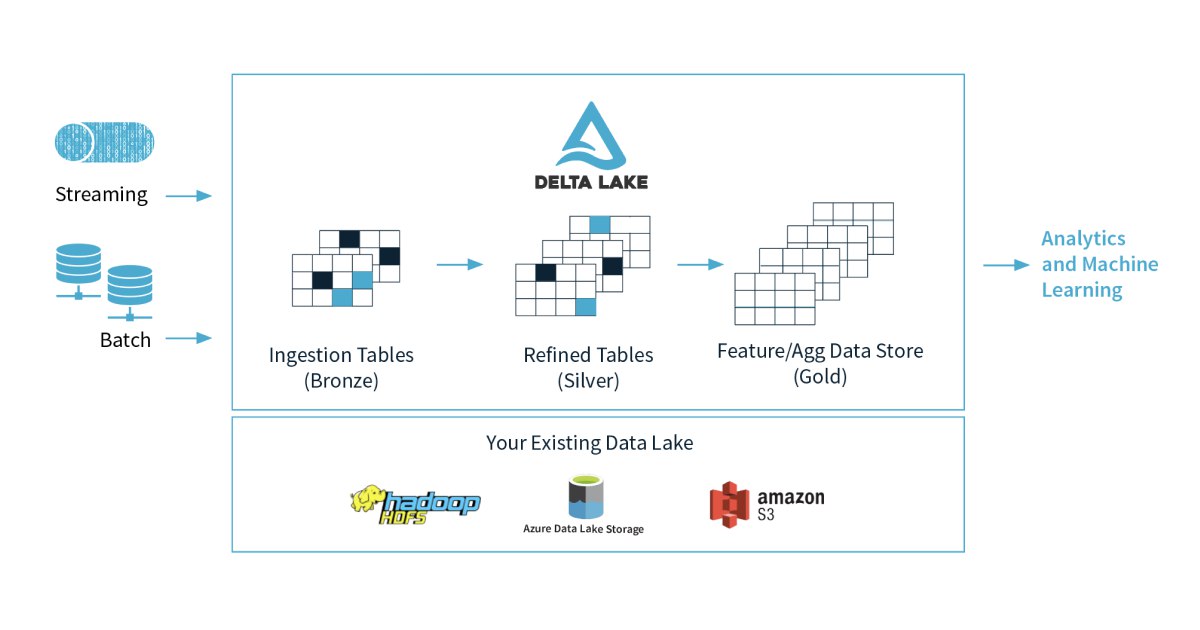

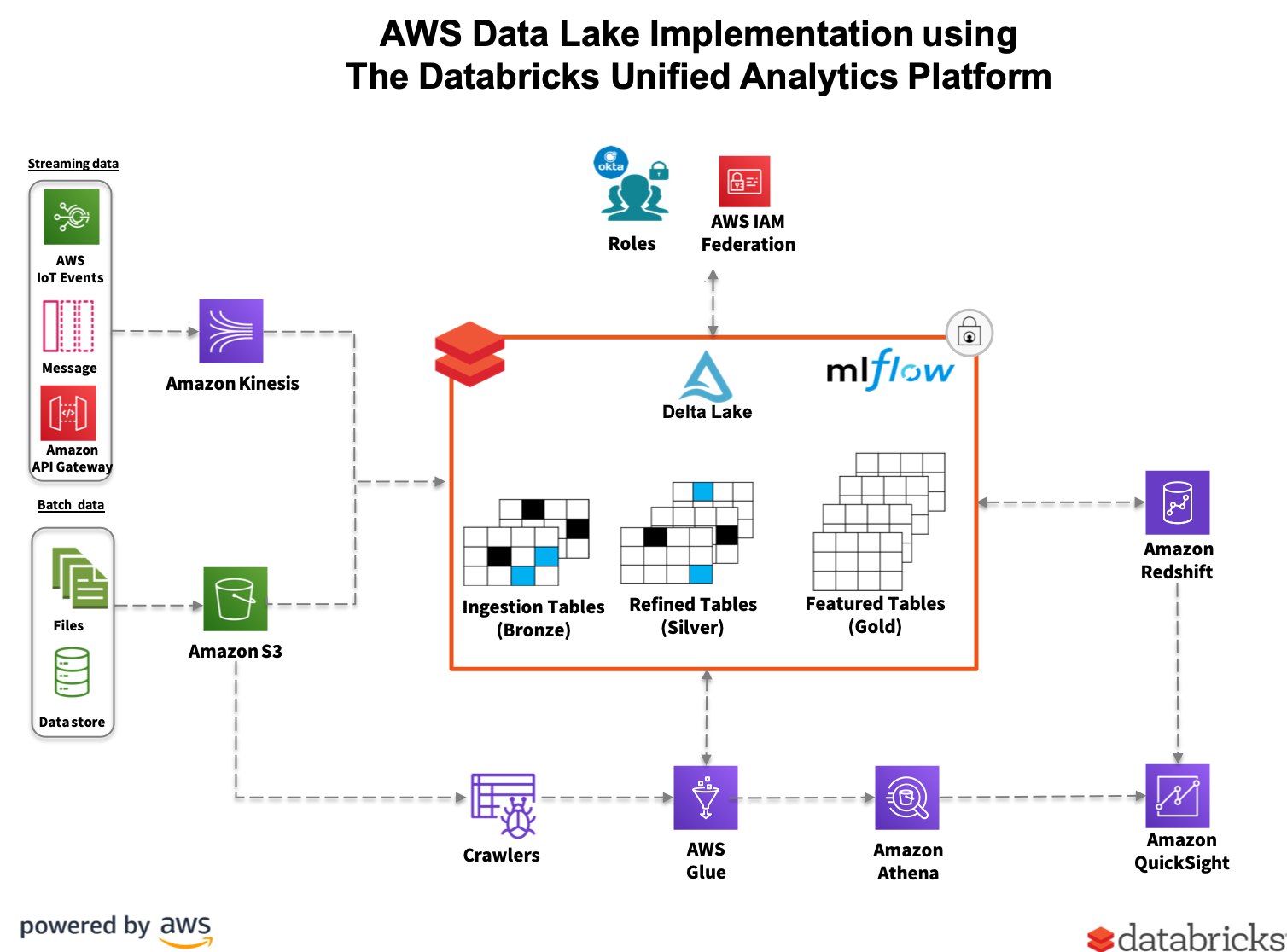

Мы используем дельту, да только это же работа с файлами напрямую, так я и без дельты могу .save сделать. Сейчас у нас вся мета в глю, работаем как с таблицами хайва. Не то, чтобы это прям необходимость, но саентологи вроде заинтересованы, да и хочется более плавного перехода. Пока действительно вижу, что будем писать файлы и повесим внешние таблицы сверху, если нужно.

R

Мы используем дельту, да только это же работа с файлами напрямую, так я и без дельты могу .save сделать. Сейчас у нас вся мета в глю, работаем как с таблицами хайва. Не то, чтобы это прям необходимость, но саентологи вроде заинтересованы, да и хочется более плавного перехода. Пока действительно вижу, что будем писать файлы и повесим внешние таблицы сверху, если нужно.

внутри Databricks можно увязать delta таблички на Glue, возможно и снаружи тоже можно через манифесты:

https://databricks.com/blog/2019/09/03/transform-your-aws-data-lake-using-databricks-delta-and-aws-glue-data-catalog-service.html

https://databricks.com/blog/2019/09/03/transform-your-aws-data-lake-using-databricks-delta-and-aws-glue-data-catalog-service.html

ПФ

Так в том-то и дело что я не очень понимаю бизнес кейс

ПФ

Мне кажется что мы тут в XY problem - пытаемся решить конкретный вопрос, в то время как бизнес задача вообще может его не требовать

ПФ

Thrift?😅(почти hive) у него есть метастор

Это же rpc прост О_о Откуда там слой хранения?

SK

Это же rpc прост О_о Откуда там слой хранения?

ЕГ

Но ведь в целом Спарк не про это, а про работу с разными источниками данных. Какая у вас задача что нужен именно метастор типа хайва?

Зачем работать с разными источниками данных, чтобы сливать их хрен знает куда? Спарк - самый удобный способ интеграции данных в хранилище, но само хранилище тоже должно быть удобным, а удобнее sql metastore ещё пока ничего не придумали

ЕГ

Можно вроде прикрутить вместо дерби другие базы, чтоб на них спарк метастор крутился

ПФ

SK

А, ну так thrift jdbc :)

Вопрос то был про метостор, в нем можно регать таблицы, и получать доступ через sparkSql

GT

внутри Databricks можно увязать delta таблички на Glue, возможно и снаружи тоже можно через манифесты:

https://databricks.com/blog/2019/09/03/transform-your-aws-data-lake-using-databricks-delta-and-aws-glue-data-catalog-service.html

https://databricks.com/blog/2019/09/03/transform-your-aws-data-lake-using-databricks-delta-and-aws-glue-data-catalog-service.html

Спасибо, посмотрю, выглядит пока тоже велосипедом с кроулерами 🤔

GT

Евгений Глотов

Можно вроде прикрутить вместо дерби другие базы, чтоб на них спарк метастор крутился

Вот вроде так выглядит, но что-то в интернетах одни статейки про конфигурацию хайва попадаются

ЕГ

Вот вроде так выглядит, но что-то в интернетах одни статейки про конфигурацию хайва попадаются

В инете всем либо паркетов в s3 хватает, либо хдфс+хайв

AK

Кто нибудь знает почему ‘’’df_driver.withColumn('requestTime',date_format(to_timestamp(df_driver.requestTime, "yyyy-MM-dd'T'HH:mm:ss.SSSSSS"), "yyyy-MM-dd'T'HH:mm:ss.SSSSSS"))’’’ даёт null в pyspark? Дата выглядит так 2020-07-01T13:00:03.629491 .null значения возникают,когда начинаю указывать миллисекунды

AS

Кто нибудь знает почему ‘’’df_driver.withColumn('requestTime',date_format(to_timestamp(df_driver.requestTime, "yyyy-MM-dd'T'HH:mm:ss.SSSSSS"), "yyyy-MM-dd'T'HH:mm:ss.SSSSSS"))’’’ даёт null в pyspark? Дата выглядит так 2020-07-01T13:00:03.629491 .null значения возникают,когда начинаю указывать миллисекунды

это уже микросекунды

AK

это уже микросекунды

А как их правильно прописать?

AS

А как их правильно прописать?

честно не знаю, мы делали через udf, не факт что это оптимально

K

🙂

проверьте, локальные пути солдержат обнолвленный jar или нет?

K

потому что складывается печатление, что вы старые джарки грузите