ЕГ

Size: a a a

2020 July 21

Внутри одной бд.

Вот это уже достаточно странно🤔

ЕГ

Можно делать msck repair table на новой после переименования

ЕГ

Должно помочь

BG

Пробовал, не помогало :)

ЕГ

Тогда наверно лучше всего будет переименовывать через спарк, если внутри одной схемы

ЕГ

Если перенос в другую - то создать новую таблицу, перенести туда данные и msck repair table

BG

Попробую. Спасибо!

С

А потом окажется что хадуп то третий

С

2020 July 22

A🦕

добрый день

хочу записать спарком датафрейм чтобы было 300 партиций

а он сохраняет 37

как фиксить?

хочу записать спарком датафрейм чтобы было 300 партиций

(

spark

.table('db.table1')

.repartition(300)

.write

.saveAsTable('db.table2', mode='overwrite')

)

spark.table('db.table2').rdd.getNumPartitions() # 37

а он сохраняет 37

как фиксить?

A

добрый день

хочу записать спарком датафрейм чтобы было 300 партиций

а он сохраняет 37

как фиксить?

хочу записать спарком датафрейм чтобы было 300 партиций

(

spark

.table('db.table1')

.repartition(300)

.write

.saveAsTable('db.table2', mode='overwrite')

)

spark.table('db.table2').rdd.getNumPartitions() # 37

а он сохраняет 37

как фиксить?

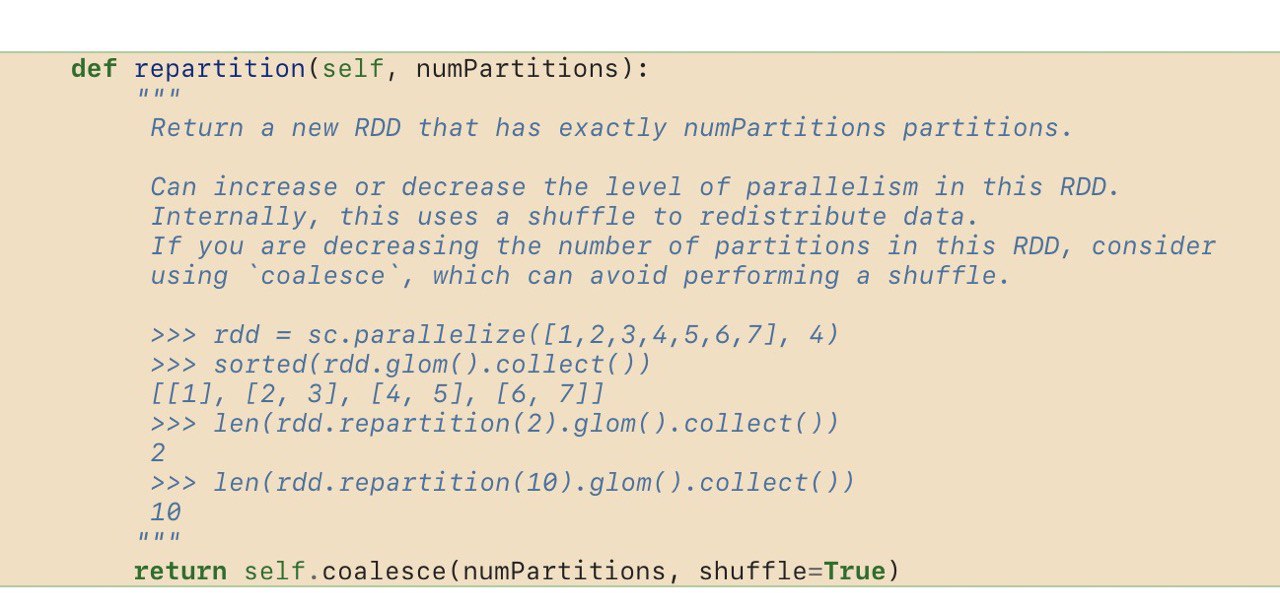

coalesce()

AK

Andrei

coalesce()

Coalesce только уменьшает жеж

PK

Andrei

coalesce()

coalesce может только уменьшить число партиций. repartition(300)

M

добрый день

хочу записать спарком датафрейм чтобы было 300 партиций

а он сохраняет 37

как фиксить?

хочу записать спарком датафрейм чтобы было 300 партиций

(

spark

.table('db.table1')

.repartition(300)

.write

.saveAsTable('db.table2', mode='overwrite')

)

spark.table('db.table2').rdd.getNumPartitions() # 37

а он сохраняет 37

как фиксить?

а файлов у вас 300 появляется? Спарк не дает гарантий что прочитается ровно столько же, сколько записалось

PK

добрый день

хочу записать спарком датафрейм чтобы было 300 партиций

а он сохраняет 37

как фиксить?

хочу записать спарком датафрейм чтобы было 300 партиций

(

spark

.table('db.table1')

.repartition(300)

.write

.saveAsTable('db.table2', mode='overwrite')

)

spark.table('db.table2').rdd.getNumPartitions() # 37

а он сохраняет 37

как фиксить?

Погоди, а файликов в hdfs сколько?

A🦕

coalesce может только уменьшить число партиций. repartition(300)

вот да, одно и то же же просто repartition shuffle добавляет

ИГ

добрый день

хочу записать спарком датафрейм чтобы было 300 партиций

а он сохраняет 37

как фиксить?

хочу записать спарком датафрейм чтобы было 300 партиций

(

spark

.table('db.table1')

.repartition(300)

.write

.saveAsTable('db.table2', mode='overwrite')

)

spark.table('db.table2').rdd.getNumPartitions() # 37

а он сохраняет 37

как фиксить?

Наивный вопрос: а строк в table1 больше, чем 37?

A🦕

а файлов у вас 300 появляется? Спарк не дает гарантий что прочитается ровно столько же, сколько записалось

проверил, 300 файлов)

тоесть делать repartition при каждом чтении?

ну .persist можно

тоесть делать repartition при каждом чтении?

ну .persist можно

A🦕

Игорь Гомановский

Наивный вопрос: а строк в table1 больше, чем 37?

да, строк 10ки милионов

M

проверил, 300 файлов)

тоесть делать repartition при каждом чтении?

ну .persist можно

тоесть делать repartition при каждом чтении?

ну .persist можно

скорее всего да, но тут зависит от того чего хотели добиться в итоге