N

Size: a a a

2020 July 22

У него есть функция , которая по ключу возвращает номер партиции. В этом его весь смысл и состоит.

PK

Nikolay

Он скорее не на датафэйм, а на шафл

Фактически верно, но не стал про это говорить, чтоб нить разговора не уходила

Sa

А прокатит решение через write.partitionBy или в нем есть какие-то проблемы по сравнению с repartition?

PK

А прокатит решение через write.partitionBy или в нем есть какие-то проблемы по сравнению с repartition?

Кажется мы про разные вещи говорим. Записывается все правильно, просто при считывании ожидается, что будет создан датафрейм из столько партиций, сколько файлов, а на деле не создается. Выход - repartition при чтении

Sa

Кажется мы про разные вещи говорим. Записывается все правильно, просто при считывании ожидается, что будет создан датафрейм из столько партиций, сколько файлов, а на деле не создается. Выход - repartition при чтении

Спасибо, теперь понял)

Sa

Интересно, а прокатит ли использование и repartition( partitionExprs) и partitionBy на сгенеренной колонке

АЖ

Интересно, а прокатит ли использование и repartition( partitionExprs) и partitionBy на сгенеренной колонке

Прокатит для чего?

Sa

Прокатит для чего?

Чтобы данные примерно были одинаково размазаны по партициям и при чтении этих данных сразу было нужное количество партиций ( внутри spark которые)

АЖ

он сначала сделает нужно количнство партиций через repartition, а потом каждую партицию разложит по partitionBy

Sa

Пример, почему такой вопрос возник: в примере выше при чтении 1 партиции (папки) мы получили 37 партиций (spark). при чтении 10 партиций (папок) например мы можем получить 10 партиций (spark). Не понятно всегда ли мы получим x партиций (spark) при чтении x партиций (папок)

А

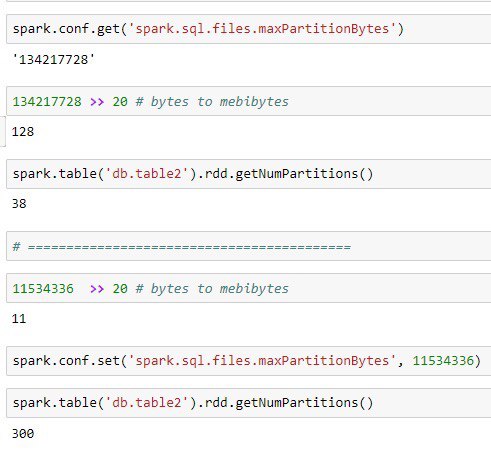

а что насчет?:

spark.sql.files.maxPartitionBytes 134217728 (128 MB) The maximum number of bytes to pack into a single partition when reading files. This configuration is effective only when using file-based sources such as Parquet, JSON and ORC.

Sa

а что насчет?:

spark.sql.files.maxPartitionBytes 134217728 (128 MB) The maximum number of bytes to pack into a single partition when reading files. This configuration is effective only when using file-based sources such as Parquet, JSON and ORC.

Спасибо) А если есть здоровый файл он идёт в одну партицию?

А

судя по описанию выше разобьется на части по 128 мб

A🦕

а что насчет?:

spark.sql.files.maxPartitionBytes 134217728 (128 MB) The maximum number of bytes to pack into a single partition when reading files. This configuration is effective only when using file-based sources such as Parquet, JSON and ORC.

спасибо, помогло!

GT

Евгений Глотов

Можно вроде прикрутить вместо дерби другие базы, чтоб на них спарк метастор крутился

Засунули метастор в рдс, наблюдаем за полетом 🤔

2020 July 23

DZ

Привет, подскажите какие джарники нужны для работы с Azure Data Lake gen2 (abfss://) ?

DZ

никак не могу найти

GP

Привет, подскажите какие джарники нужны для работы с Azure Data Lake gen2 (abfss://) ?

hadoop-azure

GP

оно org.apache.hadoop.fs.azurebfs.Abfss

GP