D

Size: a a a

2018 April 24

Ага, совсем не deep )

t2

А я вот с фасттекстом экспериментирую, крутая модель. Правда пришлось свои эмбеддинги для документов пилить - 4 часа изучал исходники генсима. Весьма трудоемко, учитывая все их deprecated классы.

TY

А я вот с фасттекстом экспериментирую, крутая модель. Правда пришлось свои эмбеддинги для документов пилить - 4 часа изучал исходники генсима. Весьма трудоемко, учитывая все их deprecated классы.

Свои эмбеддинги?

TY

Обучать пришлось в смысле?

TY

Зачем 4 часа изучать, можно было просто спросить)

t2

Зачем 4 часа изучать, можно было просто спросить)

Выбирал наиболее подходящий класс для создания помещения своих док-эмбеддингов)

TY

Так он же там один для фасттекста

t2

В фасттексте у меня ворд-левел, док левел я засунул в WordEmbeddingsKeyedVectors

t2

Там как раз есть методы add, most_similar, в общем все что надо

TY

У фасттекста тоже это есть

TY

Через .wv

t2

В фасттексте проблема в том что сложно добавить новую сущность, например документа, потому что все численные айдишники он генерирует по нграммам

t2

Я 15 минут пытался придумать какой-то уникальный хэш, который он бы не разбирал на нграммы и решил что проще взять другой класс

t2

В итоге у меня класс-композиция из gensim.models.fasttext и WordEmbeddingsKeyedVectors

t2

Пока обучаю-оптимизирую параметры. В проде останется только док-уровень.

AF

not so deep, actually, внутри даже нейронки нет

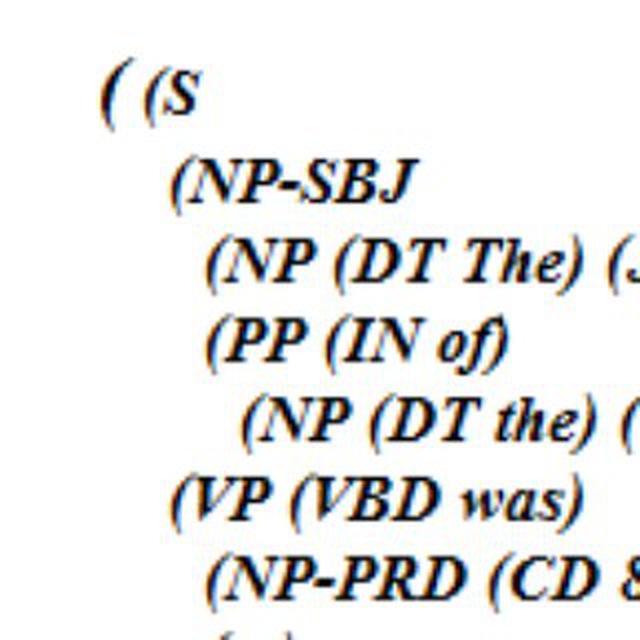

Господа, вы уверены, в том, что доктор наук Радим, автор библиотеки Gensim будет обманывать?! Не надо в след раз торопиться с выводами, особенно если они неверны. Предлагаю ознакомиться со след. материалом: Bases: gensim.models.base_any2vec.BaseWordEmbeddingsModel

Class for training, using and evaluating neural networks described in http://arxiv.org/pdf/1405.4053v2.pdf

Class for training, using and evaluating neural networks described in http://arxiv.org/pdf/1405.4053v2.pdf

AF

Кстати Tomas Mikolov его друг. Надеюсь вы знаете кто это)

t2

То что предложил Миколов и то что реализовал Радим, это разные вещи. Радим оптимизировал код Томаша, изначально написанный на С, кстати, с ошибками. Если у Томаша и была нейронка, то это простой Autoencoder, который нельзя назвать deep. Радим, в целях максимальной оптимизации убрал какие-либо нейросетевые архитектуры и свел задачу отпимизации к простому алгоритму, напрямую уменьшающую косинусную близость исходные векторов слов исходя из их совместной встречаемости. Об этом, кстати, рассказывал Лев Константиновский, бывший представитель gensim в России, в своих презентациях Gensim.

D

Господа, вы уверены, в том, что доктор наук Радим, автор библиотеки Gensim будет обманывать?! Не надо в след раз торопиться с выводами, особенно если они неверны. Предлагаю ознакомиться со след. материалом: Bases: gensim.models.base_any2vec.BaseWordEmbeddingsModel

Class for training, using and evaluating neural networks described in http://arxiv.org/pdf/1405.4053v2.pdf

Class for training, using and evaluating neural networks described in http://arxiv.org/pdf/1405.4053v2.pdf

Нейронка то есть, но никак не deep )