AL

Size: a a a

2021 January 29

https://www.gdeltproject.org/ 50k новостных сайтов на 100+ языках, обновление каждые 15 мин, выделение сущностей и событий, аналитика. Кроме текстовых новостей анализируются и видео-новости. Все это бесплатно.

Оо, круто) ...но всегда же есть задачи, не покрываемые типовым решением)

2021 January 30

SM

https://www.youtube.com/watch?v=GAWADIsBb0Y — запись семинара

ZZ

В соседнем чатике выкладывали такой пример с использованием rugpt3: https://colab.research.google.com/drive/1tKNLiKhKEYnsQ8hvwTZxbCeoQxvRVI7y?usp=sharing

А лучше сделать бинарно - {мой токен}/{не мой токен}, или лучше оставить все токены как есть (то есть будет около 1К разных токенов, мой встречается чаще всего)?

T

Какие есть подходы/решения по выделению статистистически значимых слов, их сочетаний из списка фраз?

Положим, есть несколько десятков тысяч запросов пользователей в вольной форме. Нужно выделить части, наиболее часто встречающиеся, чтобы понять, что вообще в этом наборе люди чаще всего хотят)

Положим, есть несколько десятков тысяч запросов пользователей в вольной форме. Нужно выделить части, наиболее часто встречающиеся, чтобы понять, что вообще в этом наборе люди чаще всего хотят)

DI

По блату поставлю на завтра :)

Обнял :) сейчас сделаем

DD

Какие есть подходы/решения по выделению статистистически значимых слов, их сочетаний из списка фраз?

Положим, есть несколько десятков тысяч запросов пользователей в вольной форме. Нужно выделить части, наиболее часто встречающиеся, чтобы понять, что вообще в этом наборе люди чаще всего хотят)

Положим, есть несколько десятков тысяч запросов пользователей в вольной форме. Нужно выделить части, наиболее часто встречающиеся, чтобы понять, что вообще в этом наборе люди чаще всего хотят)

Кажется, понятие "статистической значимости" тут не применимо. Статзначимостью называют ситуацию, когда есть нулевая гипотеза и её удается уверенно опровергнуть :)

А так вообще есть варианты в порядке усложнения:

- просто подсчитать частоту всех n-грамм и вывести топ самых частотных для каждого n;

- как-то разбить фразы на кусочки, кластеризовать, вывести центральные (самые близкие к соседям по кластеру) кусочки самых крупных кластеров;

- построить граф связанных друг с другом кусочков, посчитать на этом графе какую-то центральность, и вывести самые центральные кусочки.

В качестве кусочков можно использовать просто словные n-граммы, а можно - составляющие, полученные из синтаксического парсинга.

Ну или как вариант можно вообще не париться с алгоритмами, а просто случайно выбрать штук 50 запросов и прочитать все :)

А так вообще есть варианты в порядке усложнения:

- просто подсчитать частоту всех n-грамм и вывести топ самых частотных для каждого n;

- как-то разбить фразы на кусочки, кластеризовать, вывести центральные (самые близкие к соседям по кластеру) кусочки самых крупных кластеров;

- построить граф связанных друг с другом кусочков, посчитать на этом графе какую-то центральность, и вывести самые центральные кусочки.

В качестве кусочков можно использовать просто словные n-граммы, а можно - составляющие, полученные из синтаксического парсинга.

Ну или как вариант можно вообще не париться с алгоритмами, а просто случайно выбрать штук 50 запросов и прочитать все :)

BS

Нейросеть «Сбера» ruGPT-3 стала вдвое «умнее» | cnews

«Сбер» продолжает развивать русскоязычную нейросеть ruGPT-3, которая способна генерировать очень сложные осмысленные тексты всего лишь по одному запросу на «человеческом» языке. С момента презентации нейросети на AI Journey 2020 количество её параметров выросло почти вдвое — с 760 млн до 1,3 млрд. Это огромный шаг вперёд в обработке естественного языка методами искусственного интеллекта в России.

GPT-3 — крупнейшая языковая модель в мире, разработанная компанией OpenAI для решения любых задач на английском языке. На русском языке, более сложном с точки зрения структуры, до появления ruGPT-3 аналогичных качественных моделей не существовало.

Отечественная GPT-3 постоянно обучается на суперкомпьютере Сбера «Кристофари» на гигантском массиве данных, так что её возможности растут с каждым днём

RuGPT-3 может не только создавать тексты любого профиля (новости, романы, стихи, пародии, техническую документацию и так далее), но также исправлять грамматические ошибки, вести диалоги и писать программный код. По сути, это прообраз общего, или сильного, искусственного интеллекта (Artificial General Intelligence, AGI), способного решать разноплановые задачи в различных сферах деятельности.

«Сбер» продолжает развивать русскоязычную нейросеть ruGPT-3, которая способна генерировать очень сложные осмысленные тексты всего лишь по одному запросу на «человеческом» языке. С момента презентации нейросети на AI Journey 2020 количество её параметров выросло почти вдвое — с 760 млн до 1,3 млрд. Это огромный шаг вперёд в обработке естественного языка методами искусственного интеллекта в России.

GPT-3 — крупнейшая языковая модель в мире, разработанная компанией OpenAI для решения любых задач на английском языке. На русском языке, более сложном с точки зрения структуры, до появления ruGPT-3 аналогичных качественных моделей не существовало.

Отечественная GPT-3 постоянно обучается на суперкомпьютере Сбера «Кристофари» на гигантском массиве данных, так что её возможности растут с каждым днём

RuGPT-3 может не только создавать тексты любого профиля (новости, романы, стихи, пародии, техническую документацию и так далее), но также исправлять грамматические ошибки, вести диалоги и писать программный код. По сути, это прообраз общего, или сильного, искусственного интеллекта (Artificial General Intelligence, AGI), способного решать разноплановые задачи в различных сферах деятельности.

AS

Нейросеть «Сбера» ruGPT-3 стала вдвое «умнее» | cnews

«Сбер» продолжает развивать русскоязычную нейросеть ruGPT-3, которая способна генерировать очень сложные осмысленные тексты всего лишь по одному запросу на «человеческом» языке. С момента презентации нейросети на AI Journey 2020 количество её параметров выросло почти вдвое — с 760 млн до 1,3 млрд. Это огромный шаг вперёд в обработке естественного языка методами искусственного интеллекта в России.

GPT-3 — крупнейшая языковая модель в мире, разработанная компанией OpenAI для решения любых задач на английском языке. На русском языке, более сложном с точки зрения структуры, до появления ruGPT-3 аналогичных качественных моделей не существовало.

Отечественная GPT-3 постоянно обучается на суперкомпьютере Сбера «Кристофари» на гигантском массиве данных, так что её возможности растут с каждым днём

RuGPT-3 может не только создавать тексты любого профиля (новости, романы, стихи, пародии, техническую документацию и так далее), но также исправлять грамматические ошибки, вести диалоги и писать программный код. По сути, это прообраз общего, или сильного, искусственного интеллекта (Artificial General Intelligence, AGI), способного решать разноплановые задачи в различных сферах деятельности.

«Сбер» продолжает развивать русскоязычную нейросеть ruGPT-3, которая способна генерировать очень сложные осмысленные тексты всего лишь по одному запросу на «человеческом» языке. С момента презентации нейросети на AI Journey 2020 количество её параметров выросло почти вдвое — с 760 млн до 1,3 млрд. Это огромный шаг вперёд в обработке естественного языка методами искусственного интеллекта в России.

GPT-3 — крупнейшая языковая модель в мире, разработанная компанией OpenAI для решения любых задач на английском языке. На русском языке, более сложном с точки зрения структуры, до появления ruGPT-3 аналогичных качественных моделей не существовало.

Отечественная GPT-3 постоянно обучается на суперкомпьютере Сбера «Кристофари» на гигантском массиве данных, так что её возможности растут с каждым днём

RuGPT-3 может не только создавать тексты любого профиля (новости, романы, стихи, пародии, техническую документацию и так далее), но также исправлять грамматические ошибки, вести диалоги и писать программный код. По сути, это прообраз общего, или сильного, искусственного интеллекта (Artificial General Intelligence, AGI), способного решать разноплановые задачи в различных сферах деятельности.

максимум генератор спама

BS

По моему опыту с небольшим дообучением и комбинацией с другими нейронками работает хорошо

BS

Единственное что потеря контекста очень существенная, простые костыли не очень помогают (пробовал ключевые слова при генерации)

AS

комбинации с другими нейронками это как?

BS

Для валидации генераций например

BS

Кто-то дообучал gpt с кастомными функциями ошибки? Или какими-то другими способами боролись с потерей контекста?

ni

Кто-то дообучал gpt с кастомными функциями ошибки? Или какими-то другими способами боролись с потерей контекста?

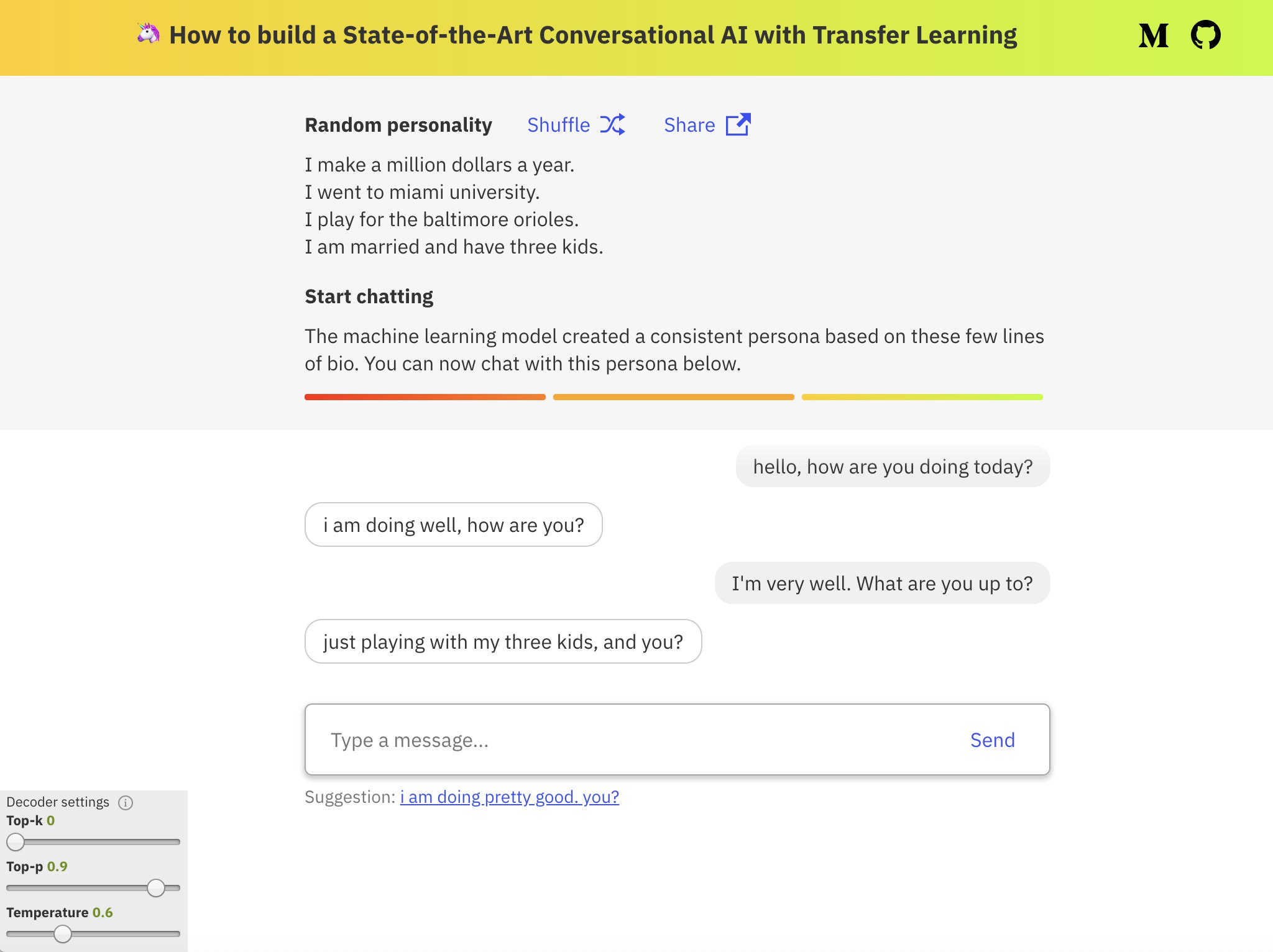

https://github.com/huggingface/transfer-learning-conv-ai

Обучал вот так, правда small модель, получилось очень плохо, но на вопросно-ответной задаче с файнтюном работает отлично.

Обучал вот так, правда small модель, получилось очень плохо, но на вопросно-ответной задаче с файнтюном работает отлично.

BS

n i

https://github.com/huggingface/transfer-learning-conv-ai

Обучал вот так, правда small модель, получилось очень плохо, но на вопросно-ответной задаче с файнтюном работает отлично.

Обучал вот так, правда small модель, получилось очень плохо, но на вопросно-ответной задаче с файнтюном работает отлично.

Спасибо! Смотрю сейчас код

А в двух словах, что помогло сохранить контекст?

А в двух словах, что помогло сохранить контекст?

BS

loss = (lm_loss * args.lm_coef + mc_loss * args.mc_coef) / args.gradient_accumulation_stepsэта кастомная ошибка? или ещё что-то

T

Кажется, понятие "статистической значимости" тут не применимо. Статзначимостью называют ситуацию, когда есть нулевая гипотеза и её удается уверенно опровергнуть :)

А так вообще есть варианты в порядке усложнения:

- просто подсчитать частоту всех n-грамм и вывести топ самых частотных для каждого n;

- как-то разбить фразы на кусочки, кластеризовать, вывести центральные (самые близкие к соседям по кластеру) кусочки самых крупных кластеров;

- построить граф связанных друг с другом кусочков, посчитать на этом графе какую-то центральность, и вывести самые центральные кусочки.

В качестве кусочков можно использовать просто словные n-граммы, а можно - составляющие, полученные из синтаксического парсинга.

Ну или как вариант можно вообще не париться с алгоритмами, а просто случайно выбрать штук 50 запросов и прочитать все :)

А так вообще есть варианты в порядке усложнения:

- просто подсчитать частоту всех n-грамм и вывести топ самых частотных для каждого n;

- как-то разбить фразы на кусочки, кластеризовать, вывести центральные (самые близкие к соседям по кластеру) кусочки самых крупных кластеров;

- построить граф связанных друг с другом кусочков, посчитать на этом графе какую-то центральность, и вывести самые центральные кусочки.

В качестве кусочков можно использовать просто словные n-граммы, а можно - составляющие, полученные из синтаксического парсинга.

Ну или как вариант можно вообще не париться с алгоритмами, а просто случайно выбрать штук 50 запросов и прочитать все :)

Спасибо большое за развернутый ответ! 👍

Что-нибудь из этого явно должно подойти.

Что-нибудь из этого явно должно подойти.

AM

Всем привет!

А можете подсказать группы в телеграме подобные этой (такие же активные и полезные), но по теме компьютерного зрения?

А можете подсказать группы в телеграме подобные этой (такие же активные и полезные), но по теме компьютерного зрения?

AE

Коллеги, всем добрый вечер! А что сейчас чаще всего спрашивают на собесах по нлп? Так сказать какой джентельменакий минимум?