SМ

Size: a a a

2021 February 11

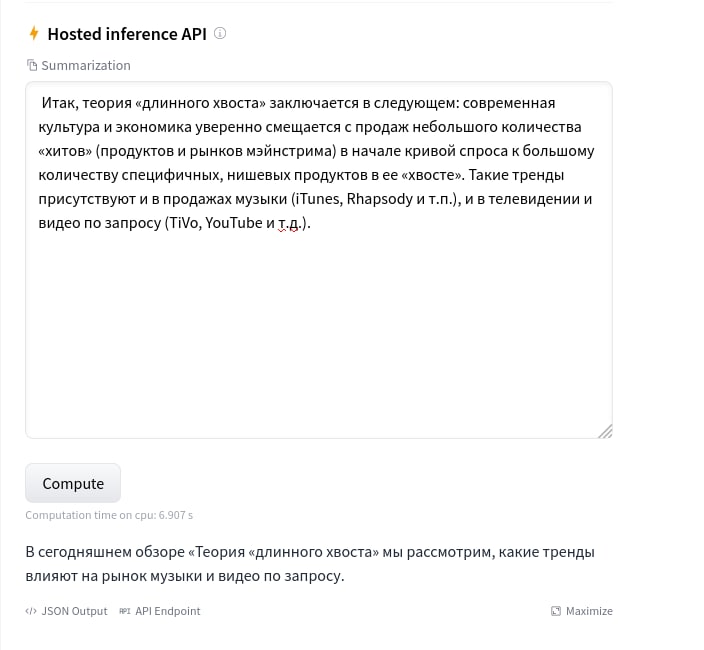

И всё это с качеством "чуть лучше чем первые три предложения"

Пока кто-то не сделает наконец-то руПегасус

SМ

И там будет уже что-то повеселее

A

Пока кто-то не сделает наконец-то руПегасус

👍🏻точно, я сначала текст переводил, потом делал суммаризацию, потом обратно на русский делал перевод. Вполне неплохой был результат.

SМ

👍🏻точно, я сначала текст переводил, потом делал суммаризацию, потом обратно на русский делал перевод. Вполне неплохой был результат.

Это костыль) но рабочий)

SМ

Упираемся в качество переводчика

AG

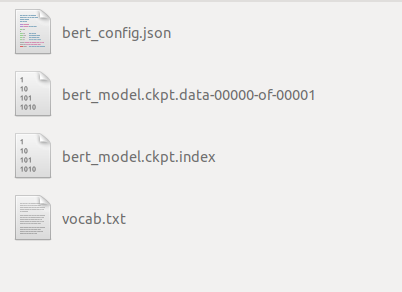

Из-за чего может быть ошибка "NotFoundError: Key cls/predictions/transform/dense/kernel not found in checkpoint" ? Я пытаюсь вызвать предтренированную модель SBERT: load_trained_model_from_checkpoint(config_path, checkpoint_path, training=True). Если же training=False, то все ОК. Модель выводится. Содержимое модели под tensorflow использую как есть:

SМ

Alex Gruzdev

Из-за чего может быть ошибка "NotFoundError: Key cls/predictions/transform/dense/kernel not found in checkpoint" ? Я пытаюсь вызвать предтренированную модель SBERT: load_trained_model_from_checkpoint(config_path, checkpoint_path, training=True). Если же training=False, то все ОК. Модель выводится. Содержимое модели под tensorflow использую как есть:

Нужно иметь тф модуль формат скорее всего

SK

Подскажите как в BERT запихнуть текст больше 512 токенов, интересует задача sentimental analysis. Есть датасет с размеченными новостями, но тексты больше 512 токенов.

d

Подскажите как в BERT запихнуть текст больше 512 токенов, интересует задача sentimental analysis. Есть датасет с размеченными новостями, но тексты больше 512 токенов.

Использовать перед ним другую модель для суммаризации?

БД

спасибо, погляжу, что там и как

Для abstract summarization неустранимая проблема галлюцинаций. Есть приложения, где это неважно.

Но если ошибки важны, то только экстрагирование.

Но если ошибки важны, то только экстрагирование.

d

Подскажите как в BERT запихнуть текст больше 512 токенов, интересует задача sentimental analysis. Есть датасет с размеченными новостями, но тексты больше 512 токенов.

А на сколько больше?

OM

Подскажите как в BERT запихнуть текст больше 512 токенов, интересует задача sentimental analysis. Есть датасет с размеченными новостями, но тексты больше 512 токенов.

Иногда берут перекрывающиеся 512-токенные окна, а потом усредняют результат

DD

Подскажите как в BERT запихнуть текст больше 512 токенов, интересует задача sentimental analysis. Есть датасет с размеченными новостями, но тексты больше 512 токенов.

Проще всего порезать текст на пересекающиеся кусочки и прогнать через Берт каждый в отдельности, а потом результат как-то агрегировать

SK

А на сколько больше?

от 700 до 1200 токенов

d

И всё это ради 0,01-0,02 метрики в сравнение с чуть более древними, но более шустрыми подходами

A

Борис Добров

Для abstract summarization неустранимая проблема галлюцинаций. Есть приложения, где это неважно.

Но если ошибки важны, то только экстрагирование.

Но если ошибки важны, то только экстрагирование.

Это да, иногда мемы прям проскакивают

БД

Подскажите как в BERT запихнуть текст больше 512 токенов, интересует задача sentimental analysis. Есть датасет с размеченными новостями, но тексты больше 512 токенов.

Нормальные новости имеют структуру "перевернутой пирамиды", все самое важное в lead.

Для "просто" аннотации хватит 512 токенов.

Сложнее для аннотации по запросу.

Для "просто" аннотации хватит 512 токенов.

Сложнее для аннотации по запросу.

A

Борис Добров

Нормальные новости имеют структуру "перевернутой пирамиды", все самое важное в lead.

Для "просто" аннотации хватит 512 токенов.

Сложнее для аннотации по запросу.

Для "просто" аннотации хватит 512 токенов.

Сложнее для аннотации по запросу.

У него вопрос про сантименты ))

AZ

Борис Добров

Для abstract summarization неустранимая проблема галлюцинаций. Есть приложения, где это неважно.

Но если ошибки важны, то только экстрагирование.

Но если ошибки важны, то только экстрагирование.

разумеется. тут вообще никаких сомнений нет