K

Size: a a a

2021 June 08

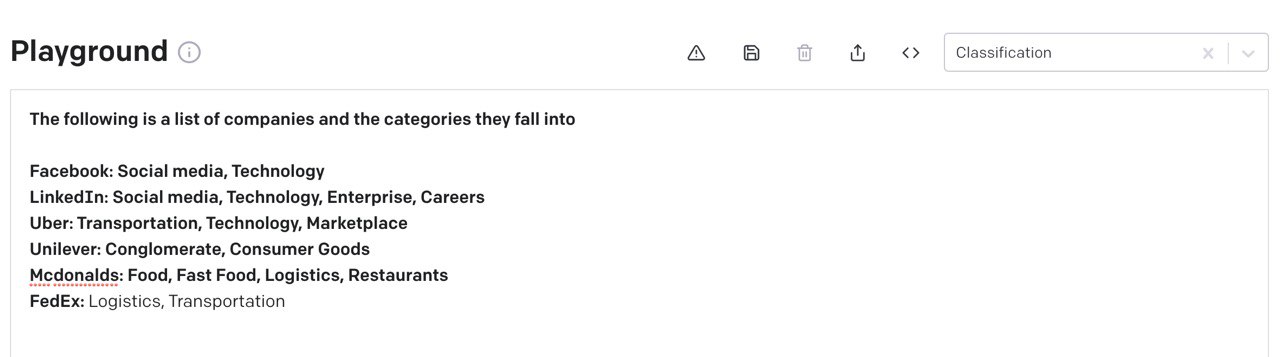

Я одна не понимаю, зачем генеративные модели для классификации использовать?

AP

Нет, квантизация тут ни причем, капсулы - это такая довольно новая архитектура нейронных сетей, которая позволяет "учесть" всякие внутренние симметрии. Было интересно попробовать, но я не считаю что обязательно их использовать. Точно ясно что GPT не содержит энкодера и это проблема для решения задач классификации обычным способом как с Бертом. Конечно, эмбеддинги GPT много полезного содержат, но использовать эти фичи не так просто

AZ

Помню, что когда-то в связке с квантизацией о них слышала, но на практике не применяла

K

Нашла вот тут https://stackoverflow.com/questions/63321892/how-can-i-use-gpt-3-for-my-text-classification интересно

AZ

Да, это офигенно работает

AP

Ну да, с таким размером модели неудивительно)

AZ

Ну и снова-таки, это работает у ОпенАИ, а вот интересно, как с подобной задачей ру-вариант справится)

K

https://stackoverflow.com/questions/60574112/can-we-use-gpt-2-sentence-embedding-for-classification-tasks вот тут говорят, что все равно берт лучше (потому что он заточен под такие задачи)

ТС

Кажется в хаггингфейс так и не завезли MLM трейнинг для GPT моделей, без этого грустно конечно с ними работать, Bert обычный лучше получается

AZ

Тут несколько о другом, все же)

K

Да, ну я просто смотрю разные варианты

K

Тут еще вопрос стоимости такого подхода, если доступ к модели платный

K

Для поиграться сойдет, а если использовать в проде или даже в ресерче...

OM

Точность few shot сильно зависит от размера модели и наименьшая из OpenAI GPT-3 тоже будет не очень. У ruGPT3 в облаке доступна 13B модель, которая могла бы справиться с few shot постановкой (кто-то с ней работал уже?)

AP

Скорее как более старая GPT-2 будет работать, примеров работы ruGPT-3 довольно много и впечатление однозначное ) Это совсем неплохо но и не супер )

AZ

Few shot не тестила с ру, а вот точность опенаи практически во всех моделях бьет берты

AZ

Ну это подтверждает мою гипотезу и впечатление

AZ

Спасибо)