NK

Size: a a a

2020 November 16

Stephan De Spiegeleire

Question to the group: does anybody know of any code that can generate all cases of Russian nouns? So basically the reverse of lemmatization: you give the code a noun in nominative singular; and the code returns all other grammatical cases of that noun

pymorphy

SD

Wow. Fast AND great! Thanks Nikolay...

TM

@yuri_baburov а не подскажете есть ли какие то методы оценки лексической , а не семантической близости в spaCy?

YB

@yuri_baburov а не подскажете есть ли какие то методы оценки лексической , а не семантической близости в spaCy?

А в чём разница? В векторных пространствах считается комбинированная морфо-синтаксически-семантическая близость

TM

А в чём разница? В векторных пространствах считается комбинированная морфо-синтаксически-семантическая близость

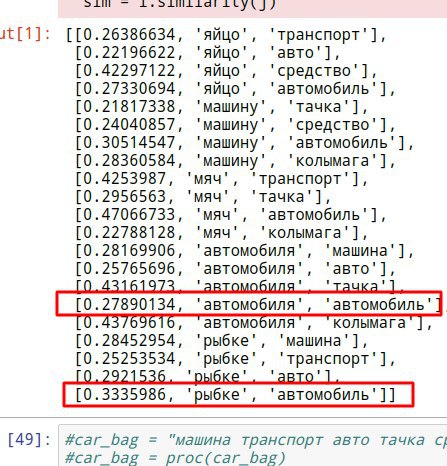

Хм, логично. Только врываюсь в мир NLP. мне не очень понятно поведение модели. почему то просклонированное ключевое слово получается максимальную близость с далекими лексически вариантами:

TM

а в Им. п. ожидаемый результат

TM

или нужно работать не с токенами а с лемматизированными объектами?

YB

Тебе попалось многозначное слово. Для однозначных слов вектора лемм должны совпадать с векторами падежных словоформ или быть не сильно далёкими, но всякое бывает :)

TM

Тебе попалось многозначное слово. Для однозначных слов вектора лемм должны совпадать с векторами падежных словоформ или быть не сильно далёкими, но всякое бывает :)

Спасибо за разъяснение

G

Hello , i wanted to ask if there is any one who used AraBERT (is used for Arabic language) before and could help me ,Thank you.

TM

Тебе попалось многозначное слово. Для однозначных слов вектора лемм должны совпадать с векторами падежных словоформ или быть не сильно далёкими, но всякое бывает :)

на самом деле я таки прочитал маячащий варнинг, и мб в этом тоже причина неожиданных результатов?

The model you're using has no word vectors loaded, so the result of the Doc.similarity method will be based on the tagger, parser and NER, which may not give useful similarity judgements. This may happen if you're using one of the small models, e.g. `en_core_web_sm`, which don't ship with word vectors and only use context-sensitive tensors.

YB

на самом деле я таки прочитал маячащий варнинг, и мб в этом тоже причина неожиданных результатов?

The model you're using has no word vectors loaded, so the result of the Doc.similarity method will be based on the tagger, parser and NER, which may not give useful similarity judgements. This may happen if you're using one of the small models, e.g. `en_core_web_sm`, which don't ship with word vectors and only use context-sensitive tensors.

странно. в этих моделях есть вектора. делаешь spacy.load('ru_...') ?

давай в личке разберёмся, если это баг какой-то, то не будем на всю группу его решением заниматься.

давай в личке разберёмся, если это баг какой-то, то не будем на всю группу его решением заниматься.

TM

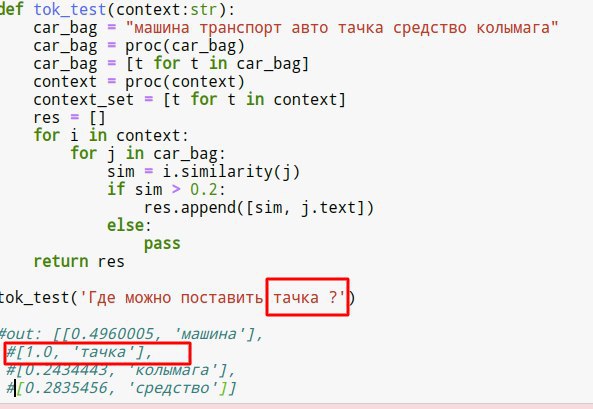

близость нормально отрабатывает на Doc, но на токенах показывает равнозначные значения для несвязанных семантически + лексически и для семантически и лексически связанных

TM

странно. в этих моделях есть вектора. делаешь spacy.load('ru_...') ?

давай в личке разберёмся, если это баг какой-то, то не будем на всю группу его решением заниматься.

давай в личке разберёмся, если это баг какой-то, то не будем на всю группу его решением заниматься.

да, как в гите все spacy.load('ru2')

TM

мб еще попробовать откатить spacy к 2,1? использую 2.3.2 тоже фигурирует в варнингах

TM

а так на токенах беда:

YB

!pip install "spacy>=2.3"

In [3]: nlp=spacy.load('releases/2.3beta/ru2_nerus_800ks_96')

In [4]: w = nlp('тачка тачку машина транспорт авто средство колымага')

In [8]: for t in w:

...: print(t, t.has_vector, t.is_oov, t.similarity(w[0]))

...:

...:

...:

тачка True False 1.0

тачку True False 1.0

машина True False 0.46673042

транспорт True False 0.2455553

авто True False 0.39078075

средство True False -0.004572388

колымага True False 0.5910443

In [3]: nlp=spacy.load('releases/2.3beta/ru2_nerus_800ks_96')

In [4]: w = nlp('тачка тачку машина транспорт авто средство колымага')

In [8]: for t in w:

...: print(t, t.has_vector, t.is_oov, t.similarity(w[0]))

...:

...:

...:

тачка True False 1.0

тачку True False 1.0

машина True False 0.46673042

транспорт True False 0.2455553

авто True False 0.39078075

средство True False -0.004572388

колымага True False 0.5910443

YB

что-то у тебя не так с загрузкой векторов. они есть только в модели версии 2.3 , а в релизе под 2.1 в ветке master , где load('ru2') , векторов нет!

я постараюсь в ноябре добить релиз 2.3 , но ближайшую неделю увы всё ещё не получается пока.

поэтому бывают недопонимания.

я постараюсь в ноябре добить релиз 2.3 , но ближайшую неделю увы всё ещё не получается пока.

поэтому бывают недопонимания.