KK

Size: a a a

2020 December 04

Подробный результат прогона текста в джейсоне можно посмотреть, там же и затестить можно

BS

deeppavlov очень грустно иногда косячит, приходится надстраивать хардкод на него

BS

Например "потратили 10 тыс. на строительство" не распознаёт как деньги

SA

Какая тарификация у вас?)

Коммерческие версии тарифицируются в зависимости от объема данных прогоняемых через систему. До конца года у нас работает специальная цена: минимальный тариф составляет 6000 руб/мес, либо 60 000 руб/год за обработку 6 млн символов/мес. Ну и есть бесплатный триал системы на месяц.

SA

А как ви привязали сущность к странице Википедии?

Саша, технология привязки к Википедии не входит в предлагаемую систему, а реализована в дополнение к ней. Это отдельный модуль, который у нас реализован для показа демки системы. Наверное это можно использовать и коммерчески, но это уже не ко мне вопрос. Если захотите рассказать про свой проект, возможно мы сможем Вам помочь. Присылайте свои координаты, и я Вас познакомлю с нужными людьми.

V

Всем привет.

Подскажите, пожалуйста, какие есть готовые решения исправления орфографии и неправильного написания слов для русского языка?

Подскажите, пожалуйста, какие есть готовые решения исправления орфографии и неправильного написания слов для русского языка?

Посмотрите на JamSpell, вроде бы ничего качественнее и оптимальнее по ресурсам тут не предлагали: https://github.com/bakwc/JamSpell

У него ещё есть Pro версия (40$ для небольшой компании), я её приобрёл потыкать — она работает намного качественнее, чем опенсорсная версия, но в несколько раз медленнее и потребляет много оперативы (в зависимости от модели от 1Гб до 4.5Гб).

Советую сразу обучить свою модель на большем объёме текста (подойдут статьи из википедии и прочих ресурсов), стандартная опенсорс модель мало слов знает. Это делается легко и не требует особых ресурсов для этого.

У него ещё есть Pro версия (40$ для небольшой компании), я её приобрёл потыкать — она работает намного качественнее, чем опенсорсная версия, но в несколько раз медленнее и потребляет много оперативы (в зависимости от модели от 1Гб до 4.5Гб).

Советую сразу обучить свою модель на большем объёме текста (подойдут статьи из википедии и прочих ресурсов), стандартная опенсорс модель мало слов знает. Это делается легко и не требует особых ресурсов для этого.

SA

gpu под виндой использует ваш сервер?

Николай, увидел еще Ваш вопрос. Для работы модуля Sapremo gpu не нужна. Он и так будет летать по сравнению с другими NER, так как основан на лингвистических правилах. А вот другой ML NER от Мегапьютера, работающий на deep learning алгоритмах, - этот как раз может работать на gpu под виндой. Ускорение на gpu по сравнению с i7 будет на один порядок в среднем. Но это все равно на порядок или даже больше медленнее, чем дает Sapremo на самом обычном i7 (причем как при обучении, так и при применении моделей - это вообще пока беда всех систем на deep learning). Этот ML NER от Мегапьютера доступен сейчас только в составе нашей основной системы PolyAnalyst. Возможно, в недалеком будущем мы его тоже станем предлагать в виде отдельного модуля.

НК

Коммерческие версии тарифицируются в зависимости от объема данных прогоняемых через систему. До конца года у нас работает специальная цена: минимальный тариф составляет 6000 руб/мес, либо 60 000 руб/год за обработку 6 млн символов/мес. Ну и есть бесплатный триал системы на месяц.

Почему бы не завернуть в виртуальную машину и платить за аренду машины, а не посимвольно? Клиент разворачивает на своем железе и сколько надо ему, столько и просчитывает?

Обработать 12 книжек за 6000 рублей в месяц? Золотодобыча какая-то 😂

Обработать 12 книжек за 6000 рублей в месяц? Золотодобыча какая-то 😂

НК

Николай, увидел еще Ваш вопрос. Для работы модуля Sapremo gpu не нужна. Он и так будет летать по сравнению с другими NER, так как основан на лингвистических правилах. А вот другой ML NER от Мегапьютера, работающий на deep learning алгоритмах, - этот как раз может работать на gpu под виндой. Ускорение на gpu по сравнению с i7 будет на один порядок в среднем. Но это все равно на порядок или даже больше медленнее, чем дает Sapremo на самом обычном i7 (причем как при обучении, так и при применении моделей - это вообще пока беда всех систем на deep learning). Этот ML NER от Мегапьютера доступен сейчас только в составе нашей основной системы PolyAnalyst. Возможно, в недалеком будущем мы его тоже станем предлагать в виде отдельного модуля.

Вангую будет существенный прогресс в скорости, если Sapremo на gpu переписать. Например, регулярные выражения от 5 раз быстрее на gpu. Учитывая паралеллизм и бурный рост числа процессоров gpu, в этом будет толк.

A

Вангую будет существенный прогресс в скорости, если Sapremo на gpu переписать. Например, регулярные выражения от 5 раз быстрее на gpu. Учитывая паралеллизм и бурный рост числа процессоров gpu, в этом будет толк.

регулярки сами по себе разве параллелятся?

AT

Добрый день, подскажите,пожалуйста как исправить такую ошибку?

репозиторий— https://github.com/tesseract-ocr/tesstrain

репозиторий— https://github.com/tesseract-ocr/tesstrain

AT

Переслано от Anastasia Tretyakova

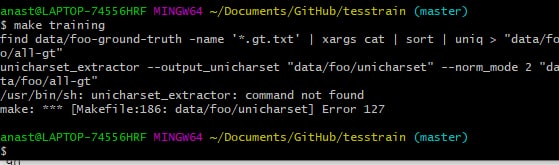

anast@LAPTOP-74556HRF MINGW64 ~/Documents/GitHub/tesstrain (master)

$ make training

find data/foo-ground-truth -name '*.gt.txt' | xargs cat | sort | uniq > "data/foo/all-gt"

unicharset_extractor --output_unicharset "data/foo/unicharset" --norm_mode 2 "data/foo/all-gt"

/usr/bin/sh: unicharset_extractor: command not found

make: *** [Makefile:186: data/foo/unicharset] Error 127

$ make training

find data/foo-ground-truth -name '*.gt.txt' | xargs cat | sort | uniq > "data/foo/all-gt"

unicharset_extractor --output_unicharset "data/foo/unicharset" --norm_mode 2 "data/foo/all-gt"

/usr/bin/sh: unicharset_extractor: command not found

make: *** [Makefile:186: data/foo/unicharset] Error 127

AT

запускаю из git bash

AT

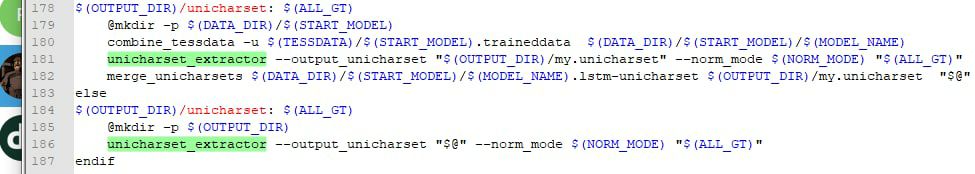

скрипт makefile

НК

регулярки сами по себе разве параллелятся?

A

там написано

The implementation parallelizes Regular Expression matching across lines in a file

по линиям это не как-то ен совсем регулярки сами по себеAP

Подскажите, пожалуйста, известны ли кому open-source решения поиска печатей в pdf документах? В каком направлении искать информацию? Google-ние пока результатов не дало. Спасибо.

MK

Anatoliy Polischuk

Подскажите, пожалуйста, известны ли кому open-source решения поиска печатей в pdf документах? В каком направлении искать информацию? Google-ние пока результатов не дало. Спасибо.

Сомневаюсь, что такое кто-то будет выкладывать в опен сорс.

AP

Сомневаюсь, что такое кто-то будет выкладывать в опен сорс.

Ясно. Так и предполагал. Спасибо :)

AK

Мне тут стало интересно провести инвентаризацию пабликов про NLP на русском. Дополняйте:

- https://t.me/natural_language_processing — этот чат, изначально чат пользователей проекта Natasha

- https://ods.ai/ #nlp

- https://t.me/dlinnlp2020spring https://t.me/dlinnlp https://t.me/dlinnlp_discuss — МФТИ

- https://t.me/nlp_seminar https://t.me/nlp_spb — Вышка

- https://t.me/NLP_weekly — ШАД

- https://t.me/nlp_ru

- https://t.me/towards_nlp

- https://t.me/Pullenti

- https://vk.com/mathlingvo

- https://www.facebook.com/dialogue21 — конференция Диалог

- https://t.me/liliyanews

- https://t.me/natural_language_processing — этот чат, изначально чат пользователей проекта Natasha

- https://ods.ai/ #nlp

- https://t.me/dlinnlp2020spring https://t.me/dlinnlp https://t.me/dlinnlp_discuss — МФТИ

- https://t.me/nlp_seminar https://t.me/nlp_spb — Вышка

- https://t.me/NLP_weekly — ШАД

- https://t.me/nlp_ru

- https://t.me/towards_nlp

- https://t.me/Pullenti

- https://vk.com/mathlingvo

- https://www.facebook.com/dialogue21 — конференция Диалог

- https://t.me/liliyanews