АК

Size: a a a

2020 October 27

Данные агрегированы, в результате их в дашборд отдаётся не много (не более тысячи строк). Само приложение рядом. Интересует именно быстродействие БД и возможность выполнять множество параллельных запросов с агрегацией без потери скорости.

JS

КХ параллелен, хватает все что есть на сервере

JS

фильтрация даже по raw-тексту - быстрая, но надо партиционирование сделать оптимальнее именно под выборку

АК

Постгря сильно проседает при нагрузочном тестирование бэкенда (100 параллельных запроса), но я её ещё особо не тюнил под это дело.

JS

а еще никто не отменял шардирование - и тогда параллельные запросы будут к разным физ. шардам

JS

ну и диски надо быстрые, если много массивных параллельных чтений

AS

к слову, я не могу сказать, что мне как-то очень часто нужны оконные функции

Мне вот тоже кажется, что они по большей части нужны для того, чтобы кандидатов на собеседованиях отсеивать =)

AS

Это на КХ? Я думал, оно как раз заточен на то, чтобы быстро фильтровать и агрегировать, что для дашбордов самое оно.

Да. У нас там событий адовые миллионы и данные к КХ хранятся по сессиям. Может поэтому.

JS

Да. У нас там событий адовые миллионы и данные к КХ хранятся по сессиям. Может поэтому.

очень даже запросто, возможно надо мельче делать партиции, зависит от...

АК

очень даже запросто, возможно надо мельче делать партиции, зависит от...

Какая логика разбиения должна быть?

JS

Какая логика разбиения должна быть?

а это по потребителям данных смотреть, какие части данных им нужны, и от этого плясать, ну например если за неделю данные берут - ну бьем по суткам, например, ну и далее вглубь идем

JS

т.е. представить, как оно будет выбираться с диска, что пойдет первым, что вторым с точки зрения увеличения детализации

JS

конечно, неприятно что могут быть сильно разные запросы и мега-оптимально для всех не сделать, но если что уж - можно и еще таблицу-копию сделать, с другим партиционированием, грубо, но сработает... но места много надо, да

ЭА

Себя он не любит 😁 Надо просто пересилить чуток, а потом уже не оттащишь.

Чтобы пересилить - есть полезный пост:

https://atrebas.github.io/post/2019-03-03-datatable-dplyr

По крайней мере, мне зашло недавно

https://atrebas.github.io/post/2019-03-03-datatable-dplyr

По крайней мере, мне зашло недавно

JS

Чтобы пересилить - есть полезный пост:

https://atrebas.github.io/post/2019-03-03-datatable-dplyr

По крайней мере, мне зашло недавно

https://atrebas.github.io/post/2019-03-03-datatable-dplyr

По крайней мере, мне зашло недавно

полезная ссылка какая, чую - будет еще попытка перейти на data.table )

ЭА

Тот факт, что я пока в DT "ковыляю", немного компенсировался мгновенностью операций над небольшим датасетом (300К строк, 140 переменных)

JS

а мне пока мешает высокая скорость быстрого-наспех-анализа через dplyr, тут он хорош (пока не силен в data.table), просто не думаешь - сразу получаешь нужное... правда, долго ждать - если данных много )

AS

Хреновые пользователишки попались Гадли. Человек старается, а в ответ...

AS

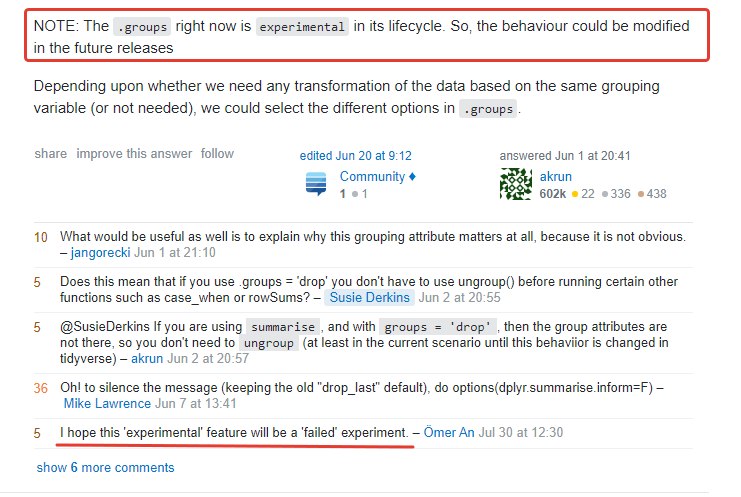

Это я решил поинтересоваться, что за херню мне теперь стал выдавать

dplyr: "summarise() ungrouping output (override with .groups argument)"AS

а мне пока мешает высокая скорость быстрого-наспех-анализа через dplyr, тут он хорош (пока не силен в data.table), просто не думаешь - сразу получаешь нужное... правда, долго ждать - если данных много )

+100 к "не думаешь". Не до этого как-то.