AM

Size: a a a

2020 December 16

А практическая польза от этого какая, если не секрет? Я думал Вы просто в эирфлоу к ней подключаетесь...

AM

Какого-то сакрального смыла нет. Просто разворачиваю базу GP и не хотелось бы еще что-то отдельное для airflow разворачивать

Понятно. К сожалению такого опыта нет🤷♂️

AA

Я понимаю что не совсем правильно, но хотелось бы разобраться с этим и иметь возможность подключить к любой базе

У меня были проблемы даже с mysql, который они сами рекомендуют, какая тут "любая база")

AA

Тут кто-то хотел попробовать оракл использовать

AA

С тех пор его никто не видел

VS

громко сказано, во первых там ппц какой древний постгресс, во вторых, там все таки есть куча своих отличий и особенностей

SG

Какого-то сакрального смыла нет. Просто разворачиваю базу GP и не хотелось бы еще что-то отдельное для airflow разворачивать

Забавно то, что вы здесь в чате уже больше времени провели, нежели бы по соседству развернули постгрю в контейнере

IK

есть какая то существенная разница в таких вариантах исполнения Расписание одинаковое:

1 Запихнуть несколько ветвей в 1 даг

2 Развести ветки по отдельным дагам и сделать их более простыми

1 Запихнуть несколько ветвей в 1 даг

2 Развести ветки по отдельным дагам и сделать их более простыми

IK

в плане нагрузки на сервак

GB

есть какая то существенная разница в таких вариантах исполнения Расписание одинаковое:

1 Запихнуть несколько ветвей в 1 даг

2 Развести ветки по отдельным дагам и сделать их более простыми

1 Запихнуть несколько ветвей в 1 даг

2 Развести ветки по отдельным дагам и сделать их более простыми

На моем опыте лучше разделять на отдельные даги (но у меня были десятки тысяч тасков)

IK

интересно что это за процессы такие с десятками тысяч тасков =)

VS

есть какая то существенная разница в таких вариантах исполнения Расписание одинаковое:

1 Запихнуть несколько ветвей в 1 даг

2 Развести ветки по отдельным дагам и сделать их более простыми

1 Запихнуть несколько ветвей в 1 даг

2 Развести ветки по отдельным дагам и сделать их более простыми

как минимум есть две отдельные опции для шедулера по построению очереди: для тасков в рамках дага и для дагов

GB

интересно что это за процессы такие с десятками тысяч тасков =)

Нужно было ETL-ить данные от внешнего API для множества сущностей, делать это надо было быстро, чтобы всё вертелось на воркерах.

Самый первый даг – десятки тысяч тасков, был монструозный, в рамках каждого рана проверялись данные за все дни, если за день не было – грузили. Это очень хреновый подход))))

Сейчас отдельные даги на эти сущности и немного шаманства с запуском scheduled__* ранов за недостающие даты

Самый первый даг – десятки тысяч тасков, был монструозный, в рамках каждого рана проверялись данные за все дни, если за день не было – грузили. Это очень хреновый подход))))

Сейчас отдельные даги на эти сущности и немного шаманства с запуском scheduled__* ранов за недостающие даты

VS

И если собирать таски в одном даге, то вероятность нарываться на большие очереди на шедулере

VS

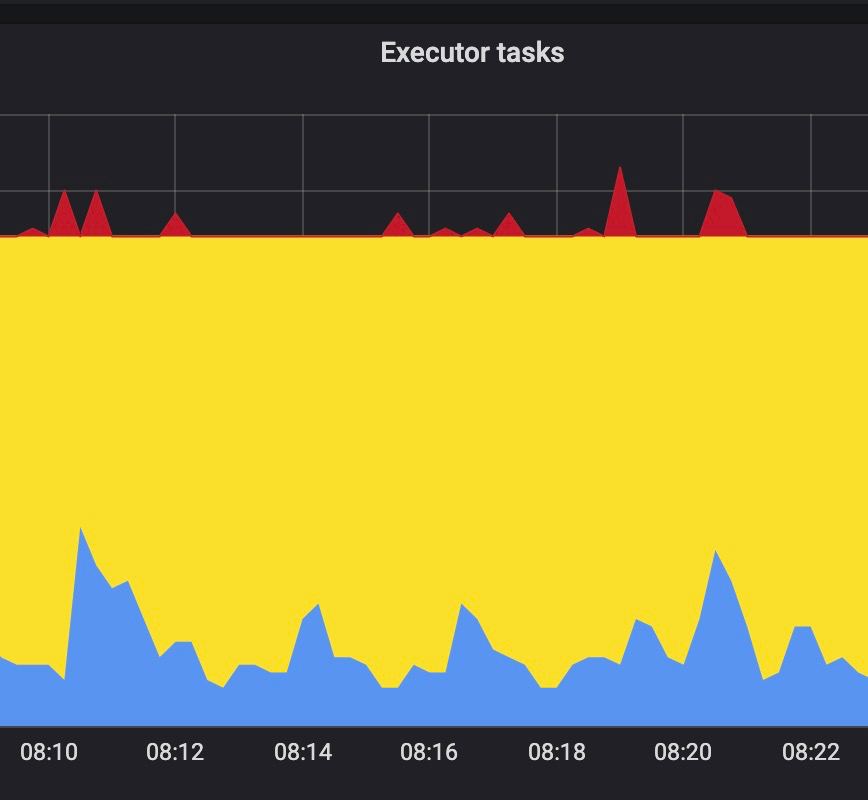

вот пример, как это может выглядить +-

IK

Спасибо. Буду разделять

SZ

Всем привет. Подскажите ответы на три вопроса, хотя бы ссылками на доки или Ютуб:

1. Можно ли как то интерактивно взаимодействовать с запущенным вручную дагом кроме как переменными из админки? К примеру указать имя БД и таблицы для текущего выполнения?

2. Я где то читал, что есть готовый оператор или хук для запуска задачи в Talent ETL из airflow, но теперь не могу найти, есть ли тут кто то, кто в курсе?

3. Возможно вопрос не сюда, но каким образом лучше переливать данные из mongo в реляционную БД, при условии, что один файл в mongo около 10 Гб может быть, а перелить надо несколько таких файлов? Придется где то приземлять около airflow в промежуточную базу? На практике пробовал через pandas, но на 10-м файле может упасть так как очистка памяти в питоне как то не полностью все вычищает после закрытия файла и уничтожения датафрейма. gc.collect тоже не помогает.

Спасибо

1. Можно ли как то интерактивно взаимодействовать с запущенным вручную дагом кроме как переменными из админки? К примеру указать имя БД и таблицы для текущего выполнения?

2. Я где то читал, что есть готовый оператор или хук для запуска задачи в Talent ETL из airflow, но теперь не могу найти, есть ли тут кто то, кто в курсе?

3. Возможно вопрос не сюда, но каким образом лучше переливать данные из mongo в реляционную БД, при условии, что один файл в mongo около 10 Гб может быть, а перелить надо несколько таких файлов? Придется где то приземлять около airflow в промежуточную базу? На практике пробовал через pandas, но на 10-м файле может упасть так как очистка памяти в питоне как то не полностью все вычищает после закрытия файла и уничтожения датафрейма. gc.collect тоже не помогает.

Спасибо