AB

Size: a a a

2020 May 25

привет) кто юзает spidermon? есть какой нибудь изи способ подавить его лог? FAILED ACTIONS вот это вот все?

2020 May 26

МС

оба правильные) какой лучше использовать

это вопрос или утверждение? :)

как по мне, так от второго смысла нет. У тебя же, получается, в настройках уже установлен DEPTH_LIMIT

как по мне, так от второго смысла нет. У тебя же, получается, в настройках уже установлен DEPTH_LIMIT

МС

и и второй более громоздкий

A

это вопрос)

когда что то не знаешь и делаешь первый раз, всегда хочеться спросить)

спасибо за ответ!

когда что то не знаешь и делаешь первый раз, всегда хочеться спросить)

class QuotesSpider(scrapy.Spider):

name = "quotes"

start_urls = ['http://quotes.toscrape.com/page/1/', ]

custom_settings = {

'DEPTH_LIMIT': 1

}

в общем вот так вот просто и лимит будет работать!спасибо за ответ!

AR

будет, но только для этого паука

A

будет, но только для этого паука

спасибо)

МС

лимит будет работать только для этой функции, так же?

на другие функции лимит этот действовать не будет?

def parse(self, response):дальше я передаю ссылки для скрапинга контента

yield from response.follow_all(links, self.parse_data)

self.parse_dataдругой функции

на другие функции лимит этот действовать не будет?

лимит будет работать ДЛЯ ПАУКА, прям для всего, прям совсем, прям для всех функций, прям для всего файла

😂

😂

МС

хм...

я с главной страницы беру ссылки, 40 ссылок если точно

потом по этим ссылкам захожу и беру контент

страниц больше 100 и на каждой по 40 ссылок

вот я хочу зайти только на 5 страниц и спарсить данные

я с главной страницы беру ссылки, 40 ссылок если точно

потом по этим ссылкам захожу и беру контент

страниц больше 100 и на каждой по 40 ссылок

вот я хочу зайти только на 5 страниц и спарсить данные

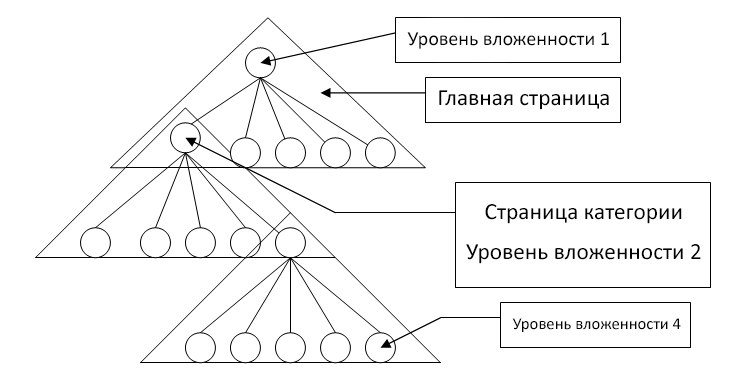

так, стоп, ты вообще понимаешь, что такое "глубина парсинга"?

это "на сколько уровней ты пройдешь структруру"

это "на сколько уровней ты пройдешь структруру"

МС

речь о том, насколько "в глубь" ты опустишся по структуре, но это никак не ограничивает работу "по горизонтали"

МС

схема не правильная

МС

смотри, как я понимаю (ну не уверен, откуда считается DEPTH_LIMIT)

1. нулевой уровень - это ты перешел по ссылкам из start_urls

2. собрал со страниц ссылки (пофиг сколько их там, это никак, в данном случае, не лимитируется)

3. перешел по этим ссылкам, получил +1 к уровню.

повторяешь пункты 2 и 3 пока не надоест :)

1. нулевой уровень - это ты перешел по ссылкам из start_urls

2. собрал со страниц ссылки (пофиг сколько их там, это никак, в данном случае, не лимитируется)

3. перешел по этим ссылкам, получил +1 к уровню.

повторяешь пункты 2 и 3 пока не надоест :)

A

смотри, как я понимаю (ну не уверен, откуда считается DEPTH_LIMIT)

1. нулевой уровень - это ты перешел по ссылкам из start_urls

2. собрал со страниц ссылки (пофиг сколько их там, это никак, в данном случае, не лимитируется)

3. перешел по этим ссылкам, получил +1 к уровню.

повторяешь пункты 2 и 3 пока не надоест :)

1. нулевой уровень - это ты перешел по ссылкам из start_urls

2. собрал со страниц ссылки (пофиг сколько их там, это никак, в данном случае, не лимитируется)

3. перешел по этим ссылкам, получил +1 к уровню.

повторяешь пункты 2 и 3 пока не надоест :)

спасибо за разъяснение

если

но если у меня всего одна ссылка но из этой ссылки я получаю следующие страницы для парсинга.

получается внутри 1 ссылки из

если

start_urls - считается корнем то как быть в такой ситуацииstart_urls - 1 ссылка, 1 обращение +1 к лимитуно если у меня всего одна ссылка но из этой ссылки я получаю следующие страницы для парсинга.

получается внутри 1 ссылки из

start_urls у меня получается куча страниц и как тогда лимиты устанавливать?