СВ

Size: a a a

2018 February 02

2018 February 05

P

S

https://openreview.net/forum?id=SyZipzbCb Метод D4PG (адаптация Distributional Perspective on Reinforcement Learning к continuous action domain), судя по статье бешено рвет все SotA.

Моя простенькая реализация на pytorch: https://github.com/PacktPublishing/Practical-Deep-Reinforcement-Learning/blob/master/ch14/06_train_d4pg.py

Моя простенькая реализация на pytorch: https://github.com/PacktPublishing/Practical-Deep-Reinforcement-Learning/blob/master/ch14/06_train_d4pg.py

AP

Какие среды удалось ей побороть?

AP

Я имею в виду твою реализацию

S

Пока еще отлаживаю :)

S

Какие среды удалось ей побороть?

На среде MinitaurBulletEnv-v0, D4PG без prioritized exp replay в 2 раза уделал DDPG и в 3 раза A2C (по макс награде). По скорости сходимости вообще огонь: D4PG работает всего 2 часа, DDPG 8 часов, A2C почти двое суток. Так что вроде не врут в статье :)

S

По идее, с приоритизацией еще бодрее должно быть

c

Ребят, кто может посоветовать годноты почитать по model-based RL? Можно даже не deep, если прям годнота)

2018 February 06

S

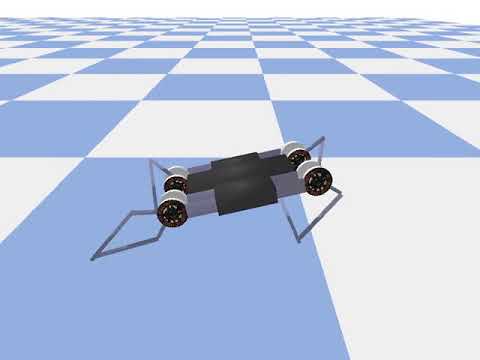

Вот так D4PG научился бегать за ночь, на мой взгляд улучшаться ему уже некуда: https://youtu.be/BMt40odLfyk

AP

а на двуногом ты пробовал?

AP

выглядит прикольно

GZ

Воувоу, прикольно)))

S

Нет, не пробовал, пока только на этой четвероножке с 8 моторчиками. Надо бы взять learning how to run, что уж там мелочиться

AP

Предупреждаю: это будет больно

SK

кто-то сказал “learning to run”?!

говорите D4PG - годно? окей, сделаем 🙂

говорите D4PG - годно? окей, сделаем 🙂

P

Cooperative Inverse Reinforcement Learning

https://arxiv.org/abs/1606.03137

https://arxiv.org/abs/1606.03137

P

Ребят, кто может посоветовать годноты почитать по model-based RL? Можно даже не deep, если прям годнота)

На RL nips workshop была любопытная статья, когда модель учили исключительно по рандомным подергиваниям какое то время.

А потом сразу в бой агента посылали. Результаты были впечатляющие

А потом сразу в бой агента посылали. Результаты были впечатляющие

P

@Shmuma Вот изложи свое видение, почему Distributional PG работает лучше? Что к этому приводит? Какого-то тумана налили в distributional perspective в целом.

S

@Shmuma Вот изложи свое видение, почему Distributional PG работает лучше? Что к этому приводит? Какого-то тумана налили в distributional perspective в целом.

Есть статья где Distr RL хорошо объясняется: https://flyyufelix.github.io/2017/10/24/distributional-bellman.html Там есть пример с commute, где распределение вероятностей дает вполне реальное преимущество в прогнозировании чем просто среднее. На мой взгляд именно в этом дело и есть -- мы пытаемся упихать все сложное стохастическое будущее в одну цифру, в результате получается не очень.