S

Size: a a a

2018 February 06

Ну и quantille regression должна еще лучше результат давать (так как нет огрубления связанного с проецированием на атомы), но я так и не заставил ее работать у себя.

P

Но ведь этой одной цифры вполне достаточно, чтобы решить задачу оптимально.

И мое имхо в том, что distributional RL улучшает только качество аппроксимации Q / V.

Наподобие того, как иногда задачу регрессии в deep learning решают с помощью приведения к задаче классификации на бакеты и софтмаксом на выходе сети.

Quantile на мой взгляд делает еще доп улучшение в том, что работает с более рабастным лоссом, избавляясь от нестабильностей MSE и добавляя сглаживание с помощью функции Huber. (Правда тут отдельно стоит заметить утверждение про композицию операторов проектции и оператора Беллмана)

Бимодальное распределение наград для Q(s, a1) и Q(s,a2) не имеет никакого смысла, если решение принимается в любом случае по среднему.

Аргументы про risk-averse я тоже не считаю состоятельными. Если у нас стоит такая задача, проблема решается ввдеением дополнительной ф.п. за дисперсию (отдельным ее моделированием) и по сути не требует моделирования всего распределения.

Поправьте меня, пожалуйста, те, кто знаком с distributional RL.

И мое имхо в том, что distributional RL улучшает только качество аппроксимации Q / V.

Наподобие того, как иногда задачу регрессии в deep learning решают с помощью приведения к задаче классификации на бакеты и софтмаксом на выходе сети.

Quantile на мой взгляд делает еще доп улучшение в том, что работает с более рабастным лоссом, избавляясь от нестабильностей MSE и добавляя сглаживание с помощью функции Huber. (Правда тут отдельно стоит заметить утверждение про композицию операторов проектции и оператора Беллмана)

Бимодальное распределение наград для Q(s, a1) и Q(s,a2) не имеет никакого смысла, если решение принимается в любом случае по среднему.

Аргументы про risk-averse я тоже не считаю состоятельными. Если у нас стоит такая задача, проблема решается ввдеением дополнительной ф.п. за дисперсию (отдельным ее моделированием) и по сути не требует моделирования всего распределения.

Поправьте меня, пожалуйста, те, кто знаком с distributional RL.

AP

Я не особо знаком, но как насчёт задачи объезда препятствия? Когда это можно сделать справа или слева, среднее - это прямо в препятствие

AP

А а случае распределения - это два холма

c

Но одной цифрой решить можно — едь слева и все

AP

Но как произвести выбор?

AG

Huber Loss вместо MSE используется во многих реимплементациях DQN и его аналогов. Видел даже как в статьях пишут обычный MSE в формулах, но в экспериментальной части пишут “ну, мы взяли хубер вместо мсе”. Хубер обычно лучше результаты даёт.

А вот сам квантильный лосс — штука очень интересная. Правда, понадобилось некоторое время и усилия чтобы понять что это такое (:

А вот сам квантильный лосс — штука очень интересная. Правда, понадобилось некоторое время и усилия чтобы понять что это такое (:

S

@ipaulo с точки зрения теории, да, одной цифры достаточно, но вот "разница между теорией и практикой отсутствует только в теории". Если один метод сходится за день, а другой за год, они оба сходятся, но для практики, второй все равно что не сходится, так как терпения не хватит. Так что, скорее всего ты и прав, но даже простое улучшение аппроксимации это большой шаг вперед, просто потому что можно получать лучший результат за конечное время. В RL и ML вообще же куча шаманства, сам знаешь. Тут подкрутили, там подвертели, вроде круто, опубликовались.

P

@ipaulo с точки зрения теории, да, одной цифры достаточно, но вот "разница между теорией и практикой отсутствует только в теории". Если один метод сходится за день, а другой за год, они оба сходятся, но для практики, второй все равно что не сходится, так как терпения не хватит. Так что, скорее всего ты и прав, но даже простое улучшение аппроксимации это большой шаг вперед, просто потому что можно получать лучший результат за конечное время. В RL и ML вообще же куча шаманства, сам знаешь. Тут подкрутили, там подвертели, вроде круто, опубликовались.

Да я за любые работы ))

Я просто пытаюсь понять, чем конкретно эти методы хороши. Они то не пишут в статьях, что вот де мы просто улучшили точность аппроксимации в задаче регрессии и больше ничего не сделали.

Но сдается мне что есть ещё что-то и на теоретическом уровне.

Например, если глянуть на график точности аппроксимации среднего в статье про quantile distributional, то там хорошо видно, что качество аппроксимации средего НЕ лучше, чем обычная unovariate регрессия на остатки Беллмана.

Однако разброс (вроде бы) меньше. Так отчего всё-таки успех? Из-за уменьшения дисперсии оценки среднего?

Я просто пытаюсь понять, чем конкретно эти методы хороши. Они то не пишут в статьях, что вот де мы просто улучшили точность аппроксимации в задаче регрессии и больше ничего не сделали.

Но сдается мне что есть ещё что-то и на теоретическом уровне.

Например, если глянуть на график точности аппроксимации среднего в статье про quantile distributional, то там хорошо видно, что качество аппроксимации средего НЕ лучше, чем обычная unovariate регрессия на остатки Беллмана.

Однако разброс (вроде бы) меньше. Так отчего всё-таки успех? Из-за уменьшения дисперсии оценки среднего?

S

Я думаю, это могло бы стать отличной темой для отдельного исследования :). А то все в статьях одни и те же рожи, да чехарда: deepmind-openai-deepmind-berkeley-openai. Какие-нибудь TU Delft вклинятся со статьей про то как cartpole улучшить слегка и все опять: deepmind-openai...

AG

Кроме DeepMind, OpeanAI и BAIR есть очень годные статьи ребят из университета Мичигана. Быть может, они не такие мейнстримные, но мне они нравятся. Там, правда, математики нет, в основном всякие архитектурные трюки, но эксперименты красивые.

https://sites.google.com/a/umich.edu/junhyuk-oh/

https://sites.google.com/a/umich.edu/junhyuk-oh/

АС

Просто как только в этой чехарде появляется новое лицо, оно вскоре поглощается одной из крупных групп

AG

Seems so ):

P

Oh очень давно занимется RL. И занимается им хорошо.

S

Сравнение A3C, DDPG и D4PG на разном наборе сред. https://arxiv.org/abs/1801.00690 TL;DR: D4PG всех победил

P

Ребят, кто может посоветовать годноты почитать по model-based RL? Можно даже не deep, если прям годнота)

Model-Ensemble Trust-Region Policy Optimization

https://openreview.net/forum?id=SJJinbWRZ

https://openreview.net/forum?id=SJJinbWRZ

c

Model-Ensemble Trust-Region Policy Optimization

https://openreview.net/forum?id=SJJinbWRZ

https://openreview.net/forum?id=SJJinbWRZ

Спасибо!

SS

IMPALA: Scalable Distributed Deep-RL with Importance Weighted Actor-Learner Architectures

https://arxiv.org/abs/1802.01561

https://arxiv.org/abs/1802.01561

2018 February 07

c

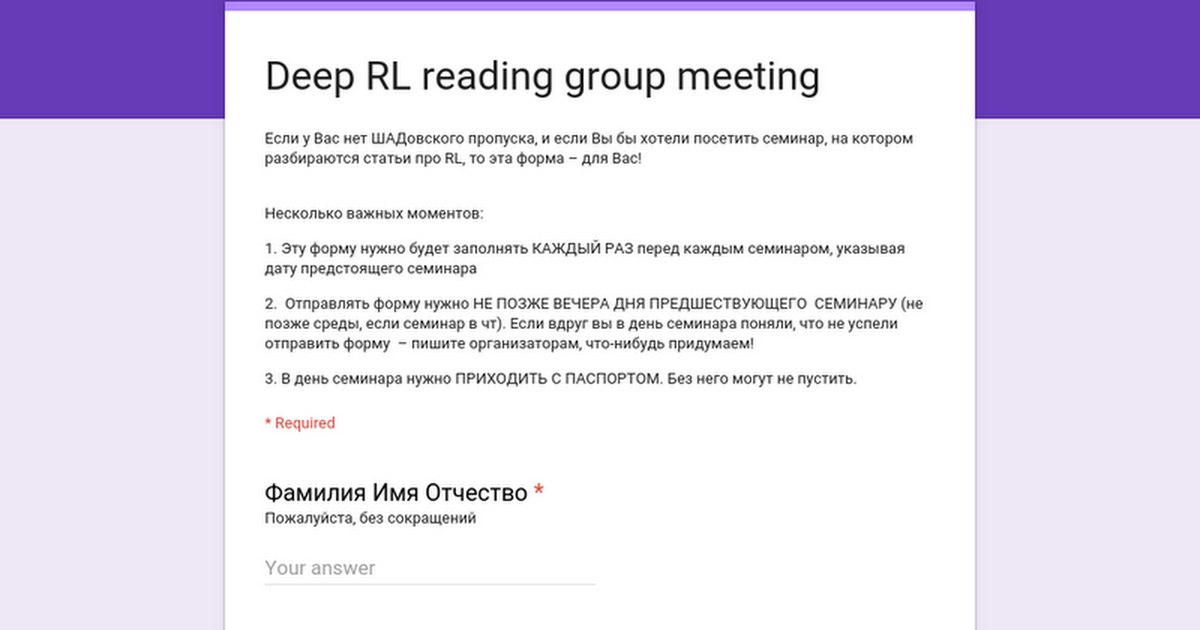

Товарищи, в этот четверг, в ШАДе, Оксфорд

В 19:00

Мы послушаем доклад Михаила Конобеева про статью Equivalence Between Policy-Gradients and Soft Q-learning.

https://arxiv.org/abs/1704.06440

Это продолжение выступления, которым мы закончили прошлый год

Успех value-based методов в современном обучении с подкреплением оказывается не до конца обоснованным. Возможное объяснение их работы

заключается в том, что данные методы скрыто проводят обновления параметров схожие с обновлениями согласно policy-gradient методам. В статье доказывается эквивалентность value-based и policy-gradient

методов в энтропийно-регуляризованном обучении с подкреплением. В этом же контексте показывается схожесть между q-learning и natural policy gradient. Экспериментально рассматриваются несколько форм

обучения политик, использующие регуляризацию, и эквивалентность подтверждается. С помощью одной из форм представления q-функции оказывается возможным обучение без использования target network и epsilon-greedy выбора действий.

Регистрация на семинар по ссылке:

https://goo.gl/forms/n8ueMHhbv4nsIUm52

Не забудьте зарегистрироваться до вечера сегодняшнего дня, если хотите прийти!

В 19:00

Мы послушаем доклад Михаила Конобеева про статью Equivalence Between Policy-Gradients and Soft Q-learning.

https://arxiv.org/abs/1704.06440

Это продолжение выступления, которым мы закончили прошлый год

Успех value-based методов в современном обучении с подкреплением оказывается не до конца обоснованным. Возможное объяснение их работы

заключается в том, что данные методы скрыто проводят обновления параметров схожие с обновлениями согласно policy-gradient методам. В статье доказывается эквивалентность value-based и policy-gradient

методов в энтропийно-регуляризованном обучении с подкреплением. В этом же контексте показывается схожесть между q-learning и natural policy gradient. Экспериментально рассматриваются несколько форм

обучения политик, использующие регуляризацию, и эквивалентность подтверждается. С помощью одной из форм представления q-функции оказывается возможным обучение без использования target network и epsilon-greedy выбора действий.

Регистрация на семинар по ссылке:

https://goo.gl/forms/n8ueMHhbv4nsIUm52

Не забудьте зарегистрироваться до вечера сегодняшнего дня, если хотите прийти!

2018 February 08

DP

Решил прочитать еще раз статью Deterministic Policy Gradients и удивился, что в доказательстве DPG теоремы требуется непрерывность функции награды r(s, a) и ее градиента dr/da (http://proceedings.mlr.press/v32/silver14-supp.pdf -- тут док-во теоремы в пункте B, условия A1).

На практике ведь встречаются задачи с непрерывным пространством действий, где функция наград не непрерывна? Типа, например, нужно руку робота в какую-то область загнать и награда бинарная (в области или нет).

Может ли кто-то из людей, у которых есть опыт в continuous action spaces поделиться, норм (D)DPG работает в таких случаях или действительно начинает лажать? Или на практике наоборот пытаются сделать непрерывный и дифференцируемый реворд (типа расстояния до области в вышеприведенном примере)?

На практике ведь встречаются задачи с непрерывным пространством действий, где функция наград не непрерывна? Типа, например, нужно руку робота в какую-то область загнать и награда бинарная (в области или нет).

Может ли кто-то из людей, у которых есть опыт в continuous action spaces поделиться, норм (D)DPG работает в таких случаях или действительно начинает лажать? Или на практике наоборот пытаются сделать непрерывный и дифференцируемый реворд (типа расстояния до области в вышеприведенном примере)?