TG

Size: a a a

2018 May 03

надеюсь, было нормально

YY

надеюсь, было нормально

Было интересно! (правда я пока не очень хорошо разбираюсь)

TG

оно первые 15 минут?

АК

Привет, может кто знает ответ на небольшой вопрос: если используется n-step TD, то вообще говоря нельзя засовывать в loss ещё и другие k-step TD k<n. По идее, это сделать можно, раз есть n-step rollout

Это ведь будет даже не TD(lambda). Такой подход ведь даст намного хуже результат?

Это ведь будет даже не TD(lambda). Такой подход ведь даст намного хуже результат?

2018 May 04

KB

То есть веса у каждого k-step loss - единица, если k <= n, которое зафиксировано, и ноль, если k > n? Вроде похоже на TD(\lambda) с модифицированными весами, разве нет?

KB

Только там сглаженно всё, а тут резкий переход.

АК

Не совсем то. Оценка для value function, о которой ты говоришь, есть просуммированные TD k-step оценки с весами, зависящими от lambda. И один лосс рассматривается: MSE над оценкой и V(s_t, theta).

А я имею ввиду n лоссов где каждая оценка это k-step TD, и в каждом лоссе один и тот же V(s_t, theta). Ведь в базовом n-step TD мы берём только 1 лосс из этих n? А добавляя остальные мы по идее ухудшаем обучение из-за дисперсий оценок меньшего порядка чем n-step. Это ведь так?

А я имею ввиду n лоссов где каждая оценка это k-step TD, и в каждом лоссе один и тот же V(s_t, theta). Ведь в базовом n-step TD мы берём только 1 лосс из этих n? А добавляя остальные мы по идее ухудшаем обучение из-за дисперсий оценок меньшего порядка чем n-step. Это ведь так?

MY

Андрей, мне кажется, что bias/variace trade-off тут другой:

- у td-target, R_{t + 1} + \gamma V(S_{t+1}) дисперсия намного меньше, чем у всего «mc-target», G_t= \sum \gamma^i R_{i + t + 1} [≈ т.к. G зависит от большего числа/массы сл. величин, чем td-target].

- но mc-target — несмещённая оценка V, а td — смещённая.

Поэтому обычно будет верно, что

Var 0.5 * td_target(n) + 0.5 * td_target(k) < Var td_target(n), если k < n.

- у td-target, R_{t + 1} + \gamma V(S_{t+1}) дисперсия намного меньше, чем у всего «mc-target», G_t= \sum \gamma^i R_{i + t + 1} [≈ т.к. G зависит от большего числа/массы сл. величин, чем td-target].

- но mc-target — несмещённая оценка V, а td — смещённая.

Поэтому обычно будет верно, что

Var 0.5 * td_target(n) + 0.5 * td_target(k) < Var td_target(n), если k < n.

АК

Я понимаю, вопрос в том, что мы берём несколько оценок одного и того же V(s_t) как td_target(k), и не агрегируя их в одну td(lambda), создаем вместо одного лосса, сразу n, по количеству td_target(k), k=1:n

MY

То что ты теперь предложил [если агрегировать ошибки с помощью экспонециального среднего] эквивалентно n-step TD с другим \gamma. Если агрегировать ошибки по-другому, например, усреднять td_target, то дисперсия обычно будет меньше (аргумент аналогичен ↑).

АК

2018 May 05

KB

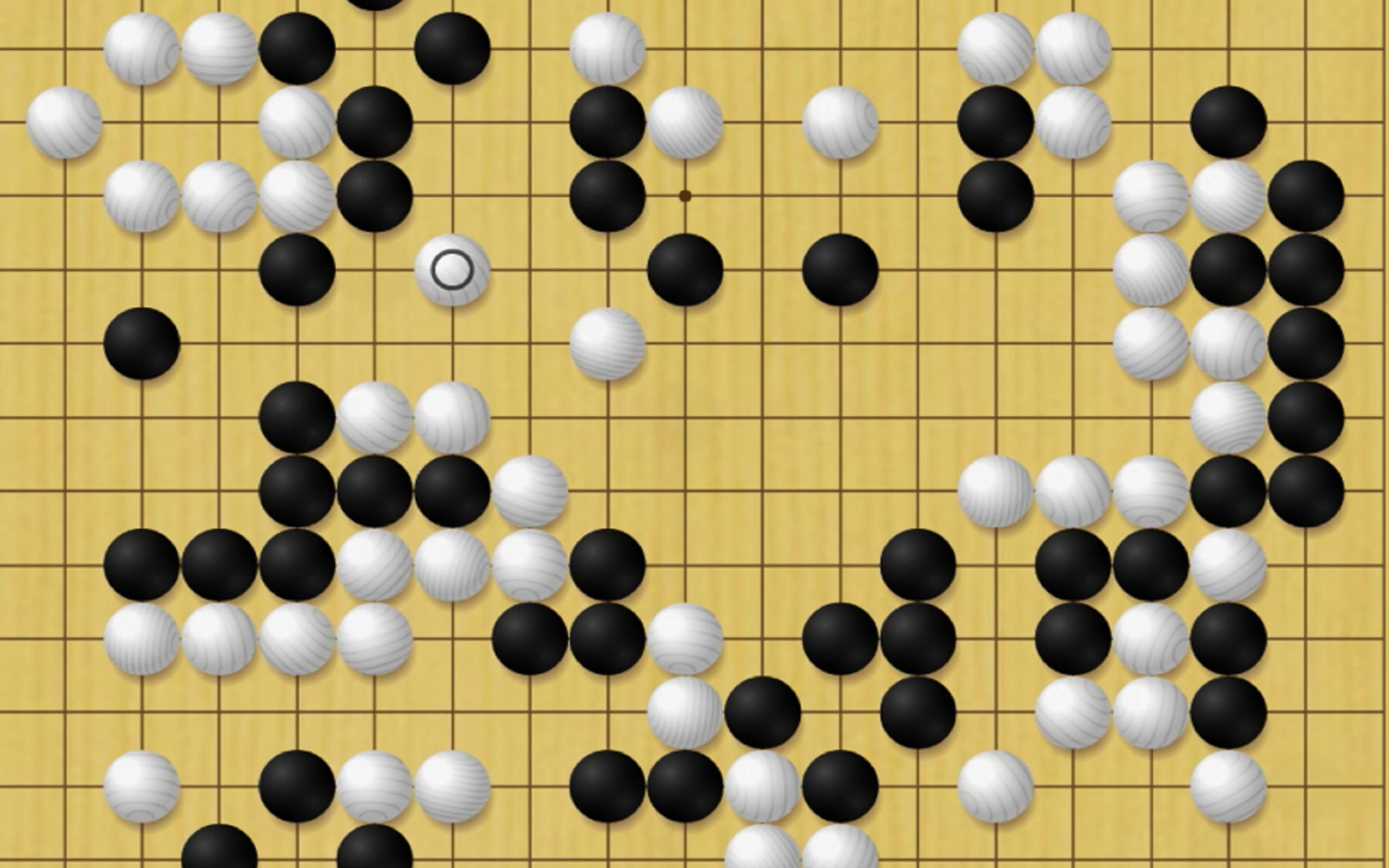

Кстати, кажется, тут почему-то не было: Facebook буквально несколько дней назад выкатил ELF OpenGo (https://research.fb.com/facebook-open-sources-elf-opengo/)

Пишут, что бот сыграл 198-2 с LeelaZero (наиболее сильная открытая реализация AlphaGo Zero на тот момент), 14-0 с топовыми мировыми игроками в Go, причём в процессе игры на prediction боту давалось 50 секунд на одной GPU, а людям — неограниченное количество времени для обдумывания хода.

Обновлённый ELF переехал в PyTorch (https://github.com/pytorch/elf).

Пишут, что бот сыграл 198-2 с LeelaZero (наиболее сильная открытая реализация AlphaGo Zero на тот момент), 14-0 с топовыми мировыми игроками в Go, причём в процессе игры на prediction боту давалось 50 секунд на одной GPU, а людям — неограниченное количество времени для обдумывания хода.

Обновлённый ELF переехал в PyTorch (https://github.com/pytorch/elf).

EZ

Привет!

Как, возможно, кто-то знает (а кто не знает, сейчас узнает), в середине мая выходит моя книжка со скромным названием Practical Deep RL (https://www.packtpub.com/big-data-and-business-intelligence/practical-deep-reinforcement-learning). В ней сделан более-менее полный обзор основных методов RL, начиная с основ (Tabular value iteration, CrossEntropy), далее в базовые DQN+A2C и заканчивая более-менее последними примочками к базовым методам (например, полностью разобран Rainbow). В последней части представлен винегрет из continuos методов (DDPG, D4PG), TrustRegion (TRPO, PPO, AKTR), black-box (ES, GA), model-based (I2A) и AlphaGo Zero.

Есть три отдельные главы с более реальными задачами чем Atari: чатбот (SCST), web navigation (MiniWoB) и торговый агент пытающийся спекулировать акциями яндекса (спойлер: если торговать без коммиссии, то даже есть профит).

Уклон книжки в практику, поэтому к каждому методу по развернутому примеру. Все примеры на PyTorch 0.4.0, все проверено, сходится и специально адаптированно для лучшего понимания как все работает. Благодаря pytorch, код вышел действительно простой: https://github.com/PacktPublishing/Practical-Deep-Reinforcement-Learning/

Собственно, к чему это я все. Издательство сейчас набирает список для early review. Работает это так: вы бесплатно получаете электронную версию книжки до выхода, ваша задача прочитать и написать отзыв на amazon (или еще где). Если хотите поучаствовать, заполните пожалуйста форму вот тут: https://goo.gl/forms/WfZUeavLqWcXOll33 (это моя табличка, я из нее данные отправлю издателю, они с вами потом свяжутся). Список ограничен 30, но если желающих будет больше, я сюда кину pdf-ку.

Как, возможно, кто-то знает (а кто не знает, сейчас узнает), в середине мая выходит моя книжка со скромным названием Practical Deep RL (https://www.packtpub.com/big-data-and-business-intelligence/practical-deep-reinforcement-learning). В ней сделан более-менее полный обзор основных методов RL, начиная с основ (Tabular value iteration, CrossEntropy), далее в базовые DQN+A2C и заканчивая более-менее последними примочками к базовым методам (например, полностью разобран Rainbow). В последней части представлен винегрет из continuos методов (DDPG, D4PG), TrustRegion (TRPO, PPO, AKTR), black-box (ES, GA), model-based (I2A) и AlphaGo Zero.

Есть три отдельные главы с более реальными задачами чем Atari: чатбот (SCST), web navigation (MiniWoB) и торговый агент пытающийся спекулировать акциями яндекса (спойлер: если торговать без коммиссии, то даже есть профит).

Уклон книжки в практику, поэтому к каждому методу по развернутому примеру. Все примеры на PyTorch 0.4.0, все проверено, сходится и специально адаптированно для лучшего понимания как все работает. Благодаря pytorch, код вышел действительно простой: https://github.com/PacktPublishing/Practical-Deep-Reinforcement-Learning/

Собственно, к чему это я все. Издательство сейчас набирает список для early review. Работает это так: вы бесплатно получаете электронную версию книжки до выхода, ваша задача прочитать и написать отзыв на amazon (или еще где). Если хотите поучаствовать, заполните пожалуйста форму вот тут: https://goo.gl/forms/WfZUeavLqWcXOll33 (это моя табличка, я из нее данные отправлю издателю, они с вами потом свяжутся). Список ограничен 30, но если желающих будет больше, я сюда кину pdf-ку.

а сколько там страниц?

EZ

а то они хотят 7 глав за неделю

S

а то они хотят 7 глав за неделю

Это они читать или ревьюить? Седьмая глава большая, там страниц 40, что ли. Остальные по 20-25

EZ

Это они читать или ревьюить? Седьмая глава большая, там страниц 40, что ли. Остальные по 20-25

в личку

LG

книгу уже можно читать? я заполнил заявление, но ничего не пришло.