D

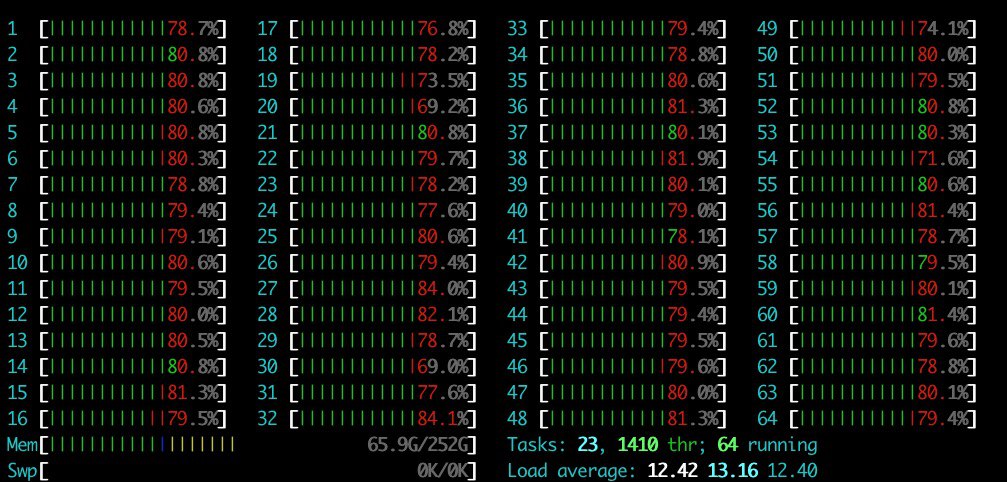

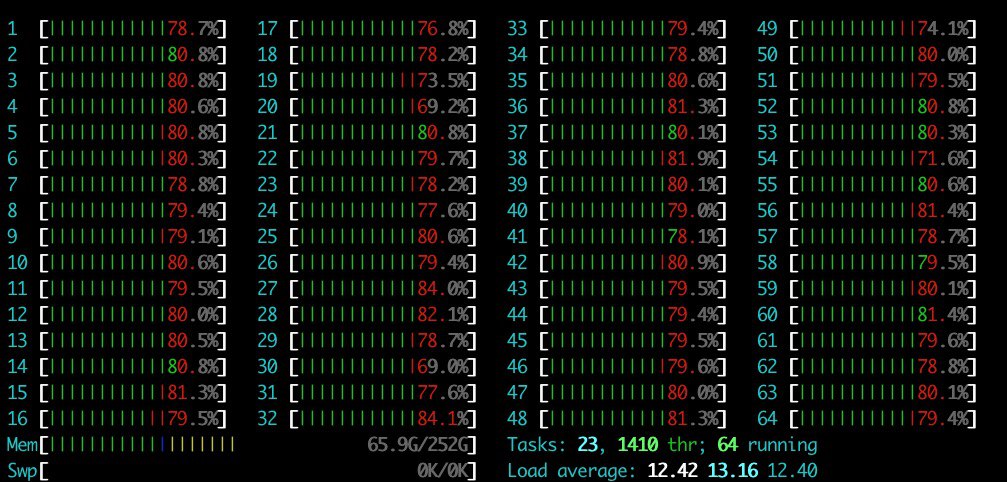

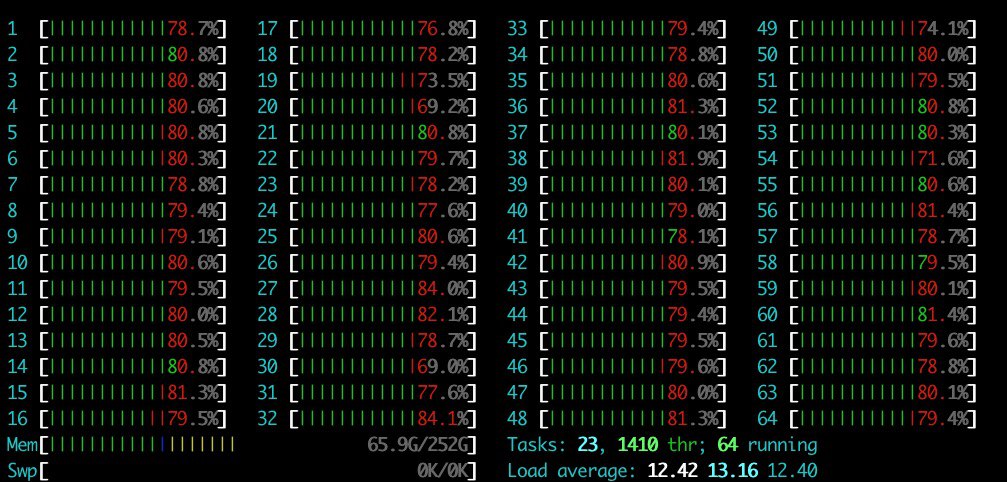

это не учитывая что должны протекать фоновые процессы

Size: a a a

D

DT

D

DT

DT

D

SELECT

field1,

field2,

field3,

sum(p1) as m,

sum(p2) as m2,

if(m + m2 > 0, 1, -1) as isVisible

FROM table

group by field1, field2, field3

LIMIT 18000000, 30000

DT

S

CREATE TABLE default.test(event_time DateTime, test UInt64) ON CLUSTER "all-replicated" ENGINE MergreTree() ORDER BY tuple() + CREATE TABLE default.test_distr(event_time DateTime, test UInt64) ON CLUSTER "all-replicated" ENGINE Distributed("all-replicated", default, test, test) - четвертый параметр подразумевает, что данные через distributed таблицу должны вставляться поровну в каждый хост кластераINSERT INTO default.test_distr ... на втором хостеDistributedFilesToInsert в system.metrics на втором хостеD

SELECT

field1,

field2,

field3,

sum(p1) as m,

sum(p2) as m2,

if(m + m2 > 0, 1, -1) as isVisible

FROM table

group by field1, field2, field3

LIMIT 18000000, 30000

S

SELECT

field1,

field2,

field3,

sum(p1) as m,

sum(p2) as m2,

if(m + m2 > 0, 1, -1) as isVisible

FROM table

group by field1, field2, field3

LIMIT 18000000, 30000

YA

DT

CREATE TABLE default.test(event_time DateTime, test UInt64) ON CLUSTER "all-replicated" ENGINE MergreTree() ORDER BY tuple() + CREATE TABLE default.test_distr(event_time DateTime, test UInt64) ON CLUSTER "all-replicated" ENGINE Distributed("all-replicated", default, test, test) - четвертый параметр подразумевает, что данные через distributed таблицу должны вставляться поровну в каждый хост кластераINSERT INTO default.test_distr ... на втором хостеDistributedFilesToInsert в system.metrics на втором хостеDT

SELECT

field1,

field2,

field3,

sum(p1) as m,

sum(p2) as m2,

if(m + m2 > 0, 1, -1) as isVisible

FROM table

group by field1, field2, field3

LIMIT 18000000, 30000

LIMIT 18000000, 30000вот же виновник

DT

D

LIMIT 18000000, 30000вот же виновник

DT

DT

DT

D

DT