В последние недели в вебмастерких чатах активно обсуждается тема нагона ботов на сайты.

Новость на Серче:

https://searchengines.guru/ru/articles/2049534Проблема была поднята мной еще весной (

https://www.facebook.com/amirhanov/posts/10223270839186378), но только в октябре-ноябре она стала действительно массовой, затронув почти всех.

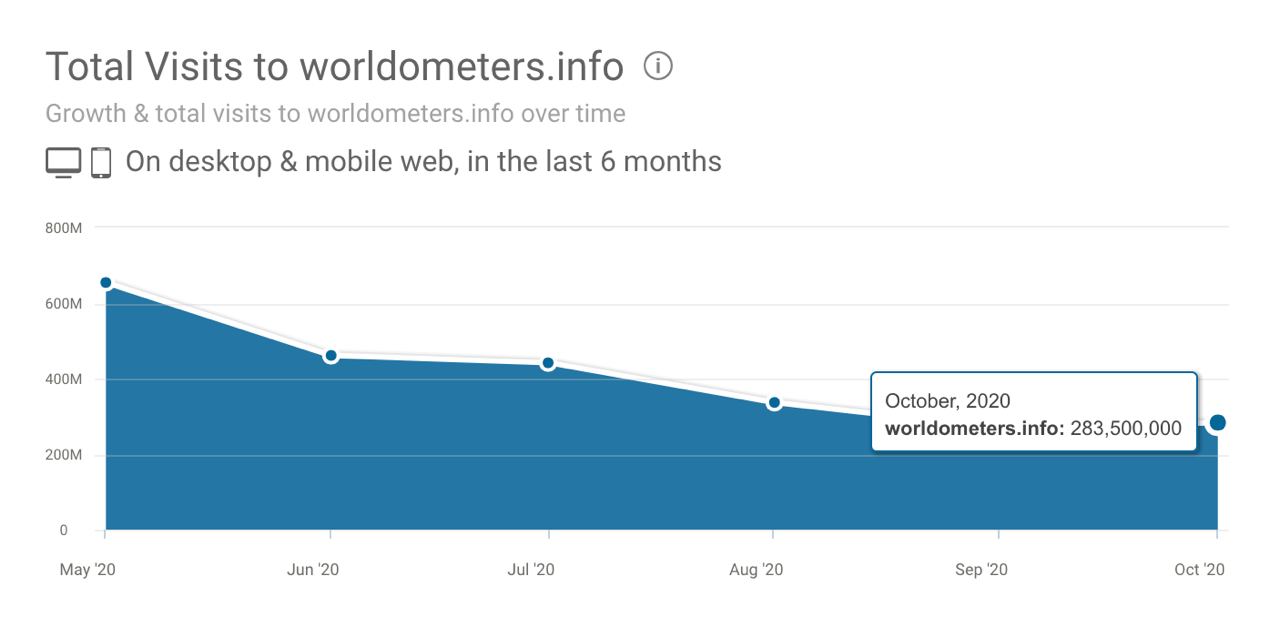

Если вы давно не заглядывали в Метрику своего сайта, то сейчас самое время. Скорее всего, этой осенью у вас тоже произошел резкий всплеск якобы переходов из социальных сетей и прямых переходов. Лично у наших проектов проблема наблюдается везде, где была более-менее нормальная посещаемость.

Яндекс.Метрика с трудом распознает ботов, если судить по отчету "Роботы" (

https://yandex.ru/support/metrica/reports/robots.html).

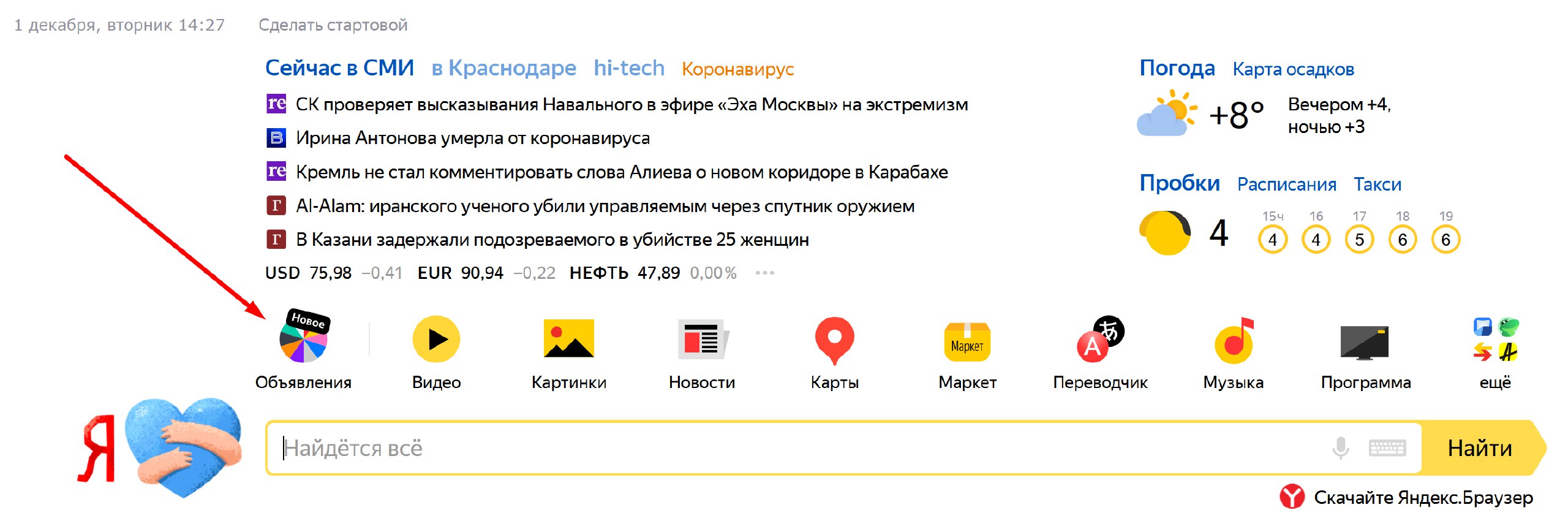

Есть сообщения от вебмастеров о снижении посещаемости. Но лично я пока к таким новостям отношусь скептически, т.к. те источники, что мне встречались, вызывали вопросы. Явных примеров я пока не видел. А снижение сейчас происходит у большинства вебмастерских сайтов и проблема вовсе не в ботах, а, например, в агрессивном продвижении Яндексом собственных продуктов (Дзен, Кью и т.д.).

Но в то же время есть вполне подтвержденные данные о бане сайтов вебмастеров за некачественный трафик на РСЯ (

https://vc.ru/claim/183117-yandeks-zablokiroval-akkaunt-rsya-i-prisvoil-sebe-dengi-za-11-2020-951tys-rubley). Проблема в том, что эмулируя поведение обычных пользователей, боты периодически кликают на рекламу, не совершая на сайте-рекламодателе конверсий. И судя по всему, пока Яндекс в данной ситуации принимает позицию "я ничего не хочу знать", утверждая, что решение по бану аккаунтов вебмастеров в РСЯ пересмотру не подлежит.

Фактически это означает следующее: если вы зарабатываете в РСЯ, то присутствует повышенная вероятность бана аккаунта в ближайшие недели/месяцы. Судя по первым сообщениям от коллег: чем больше показов привлекаете в РСЯ - тем выше вероятность бана.

Что делать с рекламой из РСЯ? Пока самое эффективное решение - отображать рекламные блоки только пользователям из поисковых систем. Некоторые известные плагины для вывода рекламы на сайтах имеют соответствующие настройки.

А что с рекламой Adsense?

Пока все спокойно. Кажется, Google эффективнее фильтрует ботовый трафик в Адсенсе. Доход за недействительные клики просто списывает с баланса. Но подозреваю, что все равно изрядная доля ботовых кликов засчитывается.

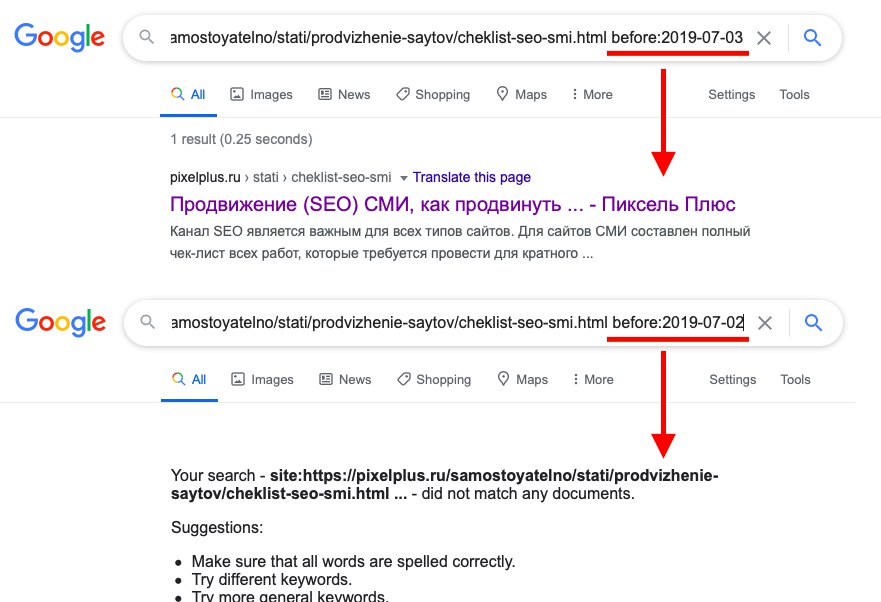

Что это за боты такие?

Сейчас почти все, кто мониторит ситуацию, уверены, что речь идет о так называемом "нагуле профилей". Боты создают себе легенду настоящего пользователя, периодически эмулируя, что посещают различные сайты, кликают по внутренним ссылкам, вводят случайные поисковые запросы. Таким образом идет "прогрев" ботовых аккаунтов с целью дальнейшего их использования для накрутки определенных сайтов через поведенческие факторы. И именно по причине такой маскировки (а также использованию мобильных прокси и, вероятно, других ухищрений) поисковые системы испытывают трудности в выявлении ботового трафика.