VF

Size: a a a

2021 February 16

А в орфографиях есть разница, кроме тонов?

DD

Всем привет!

Делаю научный проект для одного африканского малоресурсного языка (басаа, Камерун).

Задача – создать систему, которая переводит старую орфографию, в которой почти не указываются тоны, в новую, в которой тоны указываются (их в языке 5).

Есть бейзлайн на правилах. Метрики - Word Error Rate и Character Error Rate.

Какие подходы стоит попробовать для этой задачи, на ваш взгляд?

Делаю научный проект для одного африканского малоресурсного языка (басаа, Камерун).

Задача – создать систему, которая переводит старую орфографию, в которой почти не указываются тоны, в новую, в которой тоны указываются (их в языке 5).

A mbéhha me kwade. -> À m̂ɓehha mɛ kwādɛ.

Me ñwabal koo i e. -> Mɛ̀ ŋ́wàbal kɔɔ i ɛ̄.Есть бейзлайн на правилах. Метрики - Word Error Rate и Character Error Rate.

Какие подходы стоит попробовать для этой задачи, на ваш взгляд?

Мне кажется, эта задача похожа на задачу восстановления пунктуации.

Если я правильно понял, новый текст - это старый текст, где к каким-то символам применили операцию замены на более правильный символ. И количество этих замен довольно ограниченное.

Кажется, для такой задачи может подойти BERT-подобная модель for token classification, типа LaserTagger. Только, наверное, размеры токенов должны быть поменьше, чем обычно в BERT'е - так, чтобы на каждый токен приходилось не больше одной замены.

Обучал бы я её так:

1) Предобучаем обычный небольшой BERT (или RoBERTA) с маленьким словарём на задачу MLM на всех доступных текстах - и в старой орфографии, и в новой.

2) Файн-тюним эту же модель на параллельном корпусе, где на вход подаётся текст в старой орфографии, а на выходе нужно предсказать, к каким символам применить какие замены.

Построить такой параллельный корпус можно, взяв кучу текстов в новой орфографии, и какими-нибудь правилами "попортив" их, выкинув какие-то тоны. Ну или честно собрать его, если есть такая возможность.

Кажется, такая модель будет сильно более робастной, чем seq2seq, который иногда забывает часть исходного текста или, наоборот, начинает фантазировать.

Если я правильно понял, новый текст - это старый текст, где к каким-то символам применили операцию замены на более правильный символ. И количество этих замен довольно ограниченное.

Кажется, для такой задачи может подойти BERT-подобная модель for token classification, типа LaserTagger. Только, наверное, размеры токенов должны быть поменьше, чем обычно в BERT'е - так, чтобы на каждый токен приходилось не больше одной замены.

Обучал бы я её так:

1) Предобучаем обычный небольшой BERT (или RoBERTA) с маленьким словарём на задачу MLM на всех доступных текстах - и в старой орфографии, и в новой.

2) Файн-тюним эту же модель на параллельном корпусе, где на вход подаётся текст в старой орфографии, а на выходе нужно предсказать, к каким символам применить какие замены.

Построить такой параллельный корпус можно, взяв кучу текстов в новой орфографии, и какими-нибудь правилами "попортив" их, выкинув какие-то тоны. Ну или честно собрать его, если есть такая возможность.

Кажется, такая модель будет сильно более робастной, чем seq2seq, который иногда забывает часть исходного текста или, наоборот, начинает фантазировать.

DD

Natalia

не, это норм задача для машинного перевода

Для машинного перевода задача действительно норм, но есть подозрение, что sequence tagging будет проще завести.

N

ну возможно, я просто слишком много видела статей по нормализации орфографии и всякому разному (включая OCR-postcorrection), где подходили к этому как к задаче MT :)

T

Мне кажется, эта задача похожа на задачу восстановления пунктуации.

Если я правильно понял, новый текст - это старый текст, где к каким-то символам применили операцию замены на более правильный символ. И количество этих замен довольно ограниченное.

Кажется, для такой задачи может подойти BERT-подобная модель for token classification, типа LaserTagger. Только, наверное, размеры токенов должны быть поменьше, чем обычно в BERT'е - так, чтобы на каждый токен приходилось не больше одной замены.

Обучал бы я её так:

1) Предобучаем обычный небольшой BERT (или RoBERTA) с маленьким словарём на задачу MLM на всех доступных текстах - и в старой орфографии, и в новой.

2) Файн-тюним эту же модель на параллельном корпусе, где на вход подаётся текст в старой орфографии, а на выходе нужно предсказать, к каким символам применить какие замены.

Построить такой параллельный корпус можно, взяв кучу текстов в новой орфографии, и какими-нибудь правилами "попортив" их, выкинув какие-то тоны. Ну или честно собрать его, если есть такая возможность.

Кажется, такая модель будет сильно более робастной, чем seq2seq, который иногда забывает часть исходного текста или, наоборот, начинает фантазировать.

Если я правильно понял, новый текст - это старый текст, где к каким-то символам применили операцию замены на более правильный символ. И количество этих замен довольно ограниченное.

Кажется, для такой задачи может подойти BERT-подобная модель for token classification, типа LaserTagger. Только, наверное, размеры токенов должны быть поменьше, чем обычно в BERT'е - так, чтобы на каждый токен приходилось не больше одной замены.

Обучал бы я её так:

1) Предобучаем обычный небольшой BERT (или RoBERTA) с маленьким словарём на задачу MLM на всех доступных текстах - и в старой орфографии, и в новой.

2) Файн-тюним эту же модель на параллельном корпусе, где на вход подаётся текст в старой орфографии, а на выходе нужно предсказать, к каким символам применить какие замены.

Построить такой параллельный корпус можно, взяв кучу текстов в новой орфографии, и какими-нибудь правилами "попортив" их, выкинув какие-то тоны. Ну или честно собрать его, если есть такая возможность.

Кажется, такая модель будет сильно более робастной, чем seq2seq, который иногда забывает часть исходного текста или, наоборот, начинает фантазировать.

пока не очень понимаю, почему seq2seq в качестве бейзлайна будет не очень робастной, учитывая то, что каждому токену (в нашем случае символу) соответствует другой

N

пока не очень понимаю, почему seq2seq в качестве бейзлайна будет не очень робастной, учитывая то, что каждому токену (в нашем случае символу) соответствует другой

тут очень важен контекст

T

хотя да, лучше seq2seq на символах, наверное, не строить

N

(хотя, конечно, и это зависит от тональной системы языка во многом)

N

А в орфографиях есть разница, кроме тонов?

ну вот e > ɛ как минимум

VF

Natalia

ну вот e > ɛ как минимум

Тогда вопрос в том, можно ли эту разницу свести к правилам (и считать, что это постпроцессинг после sequence labeling'а), или она настолько значительна, что лучше предоставить сектусеку её выучивать

IN

А в орфографиях есть разница, кроме тонов?

Да, есть замены для части согласных тоже. Но их меньше, чем для гласных

VF

Да, есть замены для части согласных тоже. Но их меньше, чем для гласных

А замены тривиальные?

VF

то есть жесть как с гласными?

VF

тогда наверное seq2seq имеет смысл

VF

в принципе стоит попробовать оба и посмотреть, что взлетит

N

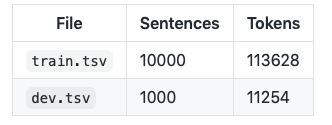

а размер корпуса вообще большой?

N

а то ж от этого ещё как зависит качество нейронного машпера

N

маловато