T

вообще никогда не понимал прикола torchtext, хотя каждый второй пайплайн из интернетов его использует

как-то легче самому написать кастомный датасет в 20 строчек и не париться

change my mind

Size: a a a

T

KK

build_vocabulary

Field

d

d

d

KK

BS

d

KK

d

KK

Д

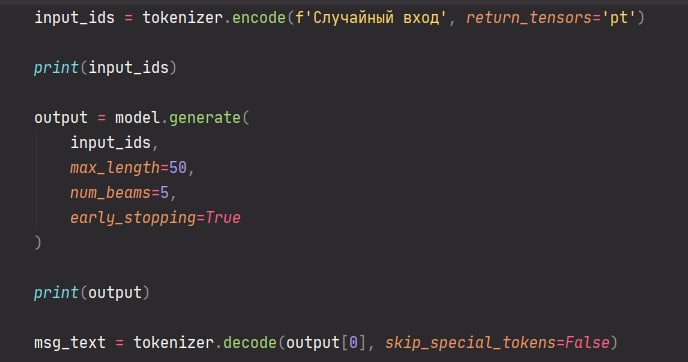

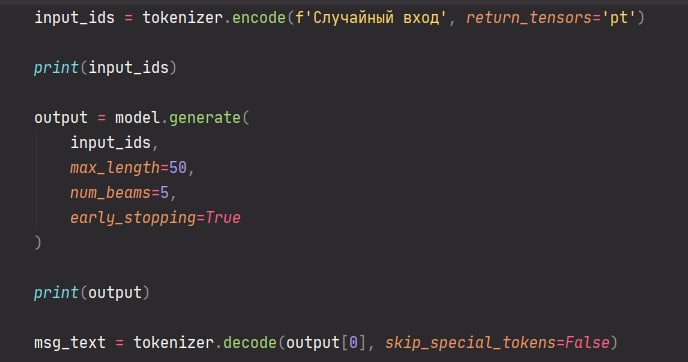

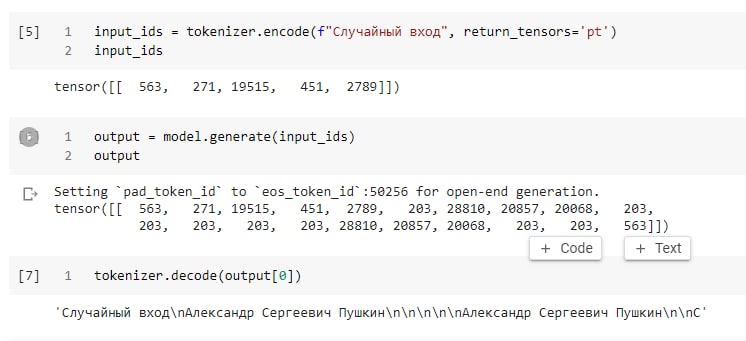

tensor([[ 563, 271, 19515, 451, 2789]])Выход:

tensor([[ 563, 271, 19515, 451, 2789, 203, 203, 203, 203, 203, 203, 203, 203, 203, 203, 203, 203, 203, 203, 203, 203])Скриншот как использую - вверху.

from transformers import AutoTokenizer, AutoModelWithLMHead

tokenizer = AutoTokenizer.from_pretrained("sberbank-ai/rugpt3small_based_on_gpt2")

model = AutoModelWithLMHead.from_pretrained("sberbank-ai/rugpt3small_based_on_gpt2")

ni

tensor([[ 563, 271, 19515, 451, 2789]])Выход:

tensor([[ 563, 271, 19515, 451, 2789, 203, 203, 203, 203, 203, 203, 203, 203, 203, 203, 203, 203, 203, 203, 203, 203])Скриншот как использую - вверху.

from transformers import AutoTokenizer, AutoModelWithLMHead

tokenizer = AutoTokenizer.from_pretrained("sberbank-ai/rugpt3small_based_on_gpt2")

model = AutoModelWithLMHead.from_pretrained("sberbank-ai/rugpt3small_based_on_gpt2")

Д

Setting `pad_token_id` to 50256 (first `eos_token_id`) to generate sequence

BS

Д

BS

BS

BS

BS