YB

Size: a a a

2021 February 20

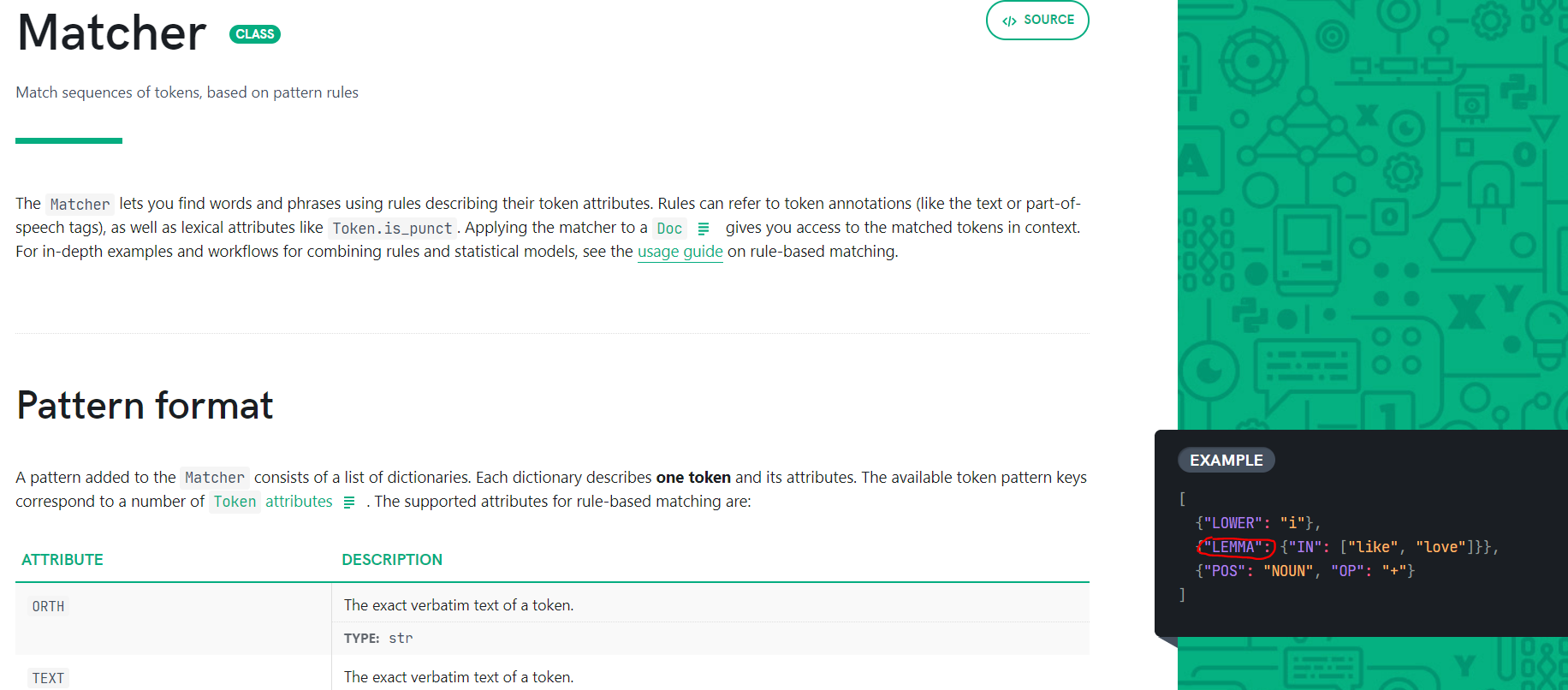

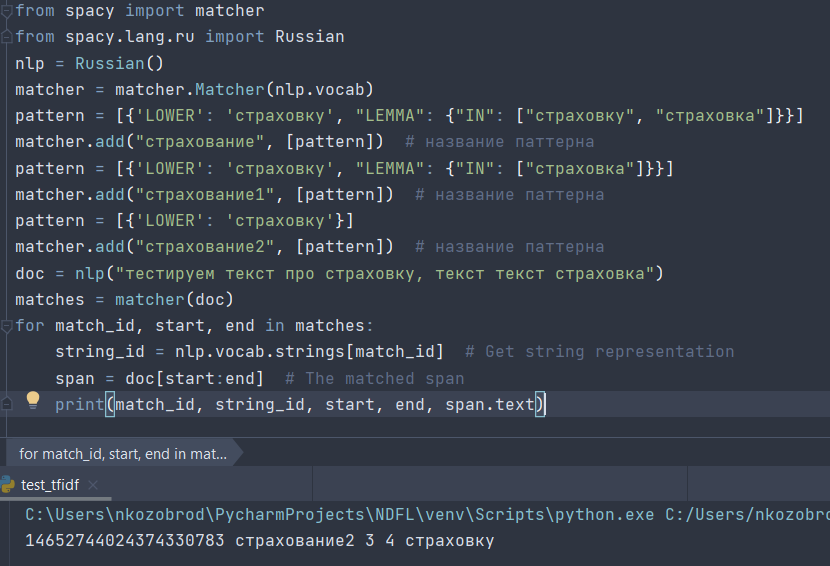

Всем привет! у меня возник вопрос по поводу spacy matcher. Я не понимаю, можно ли его как-то использовать, чтобы он искал начальную форму слова? Я нашел в документации параметр lemma, но опять же, судя по документации - это что-то другое. Конечно есть вариант сначала весь текст прогонять через Pymorphy, а уж потом искать, но может есть вариант без костылей? В целом задача такая: есть список фраз подвязанных к тематикам, есть транскрибция разговоров - хочу помечать то, что нашлось, а то что не нашлось кластеризировать и формировать новые тематики. P.s. На картинке кусок документации spacy, где like и love вроде как леммы слова i. Я видимо не так понимаю смысл слова Lemma и это не начальная форма, а что-то другое?

Lemma -- это то, что надо, но не забудь сначала прогнать текст через морфо-синтаксический анализ, чтобы лемма заполнилась данными.

NK

Ну то есть недостаточно просто в лемме указать начальную форму слова?

YB

Ну то есть недостаточно просто в лемме указать начальную форму слова?

Вручную? Достаточно, да. Надо проверить, вдруг поломалось, но вроде работало)

NK

FF

В этом году прямо годнота на диалоге

FF

Очень жаль

FF

https://competitions.codalab.org/competitions/29216?secret_key=d63b3dae-a033-402f-a867-fa6de980dd4d соревнование по нормализации спанов в рамках диалога

AK

Переслано от Ivan Smurov

Всем привет!

В рамках Dialogue Evaluation 2021 с 20 февраля по 15 марта проводится соревнование по нормализации (т. е. приведению к начальной форме) спанов.

Соревнование состоит из 2 дорожек. В первой дорожке необходимо привести к нормальной форме именованные сущности (персоны, локации, организации) на материале новостных текстов vz.ru. Во второй - более общие спаны (в том числе, не являющиеся именными группами) на материале корпуса RuREBus (программы Минэкономразвития).

По результатам участия можно будет подать статью на конференцию Диалог.

Более подробное описание по ссылке.

Гитхаб: https://github.com/dialogue-evaluation/RuNormAS

Соревнование: https://competitions.codalab.org/competitions/29216?secret_key=d63b3dae-a033-402f-a867-fa6de980dd4d

Чат в Telegram: @RuNormAS

В рамках Dialogue Evaluation 2021 с 20 февраля по 15 марта проводится соревнование по нормализации (т. е. приведению к начальной форме) спанов.

Соревнование состоит из 2 дорожек. В первой дорожке необходимо привести к нормальной форме именованные сущности (персоны, локации, организации) на материале новостных текстов vz.ru. Во второй - более общие спаны (в том числе, не являющиеся именными группами) на материале корпуса RuREBus (программы Минэкономразвития).

По результатам участия можно будет подать статью на конференцию Диалог.

Более подробное описание по ссылке.

Гитхаб: https://github.com/dialogue-evaluation/RuNormAS

Соревнование: https://competitions.codalab.org/competitions/29216?secret_key=d63b3dae-a033-402f-a867-fa6de980dd4d

Чат в Telegram: @RuNormAS

2021 February 21

OD

Всем привет!

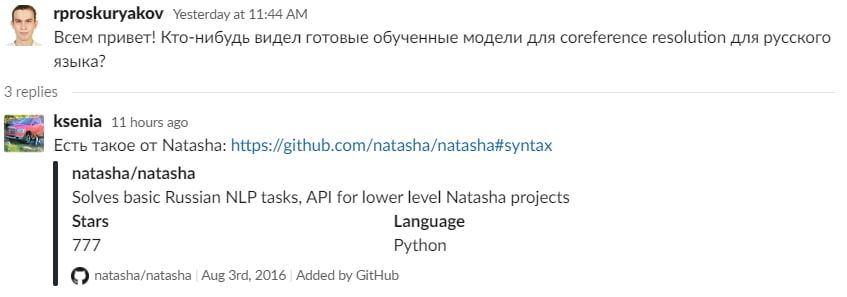

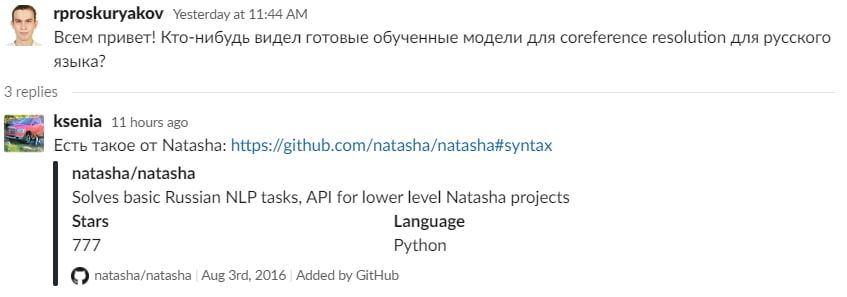

В ODS, в канале #nlp недавно был вопрос про разрешение кореференции для русского языка, и в одном из ответов упомянулось, что в Natasha есть такая функциональность.

Однако, не нашел ничего в документации. Может кто-то проконсультировать по данному вопросу?

Заранее спасибо!

В ODS, в канале #nlp недавно был вопрос про разрешение кореференции для русского языка, и в одном из ответов упомянулось, что в Natasha есть такая функциональность.

Однако, не нашел ничего в документации. Может кто-то проконсультировать по данному вопросу?

Заранее спасибо!

KS

Переслано от Ivan Smurov

Всем привет!

В рамках Dialogue Evaluation 2021 с 20 февраля по 15 марта проводится соревнование по нормализации (т. е. приведению к начальной форме) спанов.

Соревнование состоит из 2 дорожек. В первой дорожке необходимо привести к нормальной форме именованные сущности (персоны, локации, организации) на материале новостных текстов vz.ru. Во второй - более общие спаны (в том числе, не являющиеся именными группами) на материале корпуса RuREBus (программы Минэкономразвития).

По результатам участия можно будет подать статью на конференцию Диалог.

Более подробное описание по ссылке.

Гитхаб: https://github.com/dialogue-evaluation/RuNormAS

Соревнование: https://competitions.codalab.org/competitions/29216?secret_key=d63b3dae-a033-402f-a867-fa6de980dd4d

Чат в Telegram: @RuNormAS

В рамках Dialogue Evaluation 2021 с 20 февраля по 15 марта проводится соревнование по нормализации (т. е. приведению к начальной форме) спанов.

Соревнование состоит из 2 дорожек. В первой дорожке необходимо привести к нормальной форме именованные сущности (персоны, локации, организации) на материале новостных текстов vz.ru. Во второй - более общие спаны (в том числе, не являющиеся именными группами) на материале корпуса RuREBus (программы Минэкономразвития).

По результатам участия можно будет подать статью на конференцию Диалог.

Более подробное описание по ссылке.

Гитхаб: https://github.com/dialogue-evaluation/RuNormAS

Соревнование: https://competitions.codalab.org/competitions/29216?secret_key=d63b3dae-a033-402f-a867-fa6de980dd4d

Чат в Telegram: @RuNormAS

В описании есть фраза: "В соревновании представлен бейзлайн, полученный применением средств нормализации из библиотеки Natasha". Что это означает, что в качестве эталонной нормализации используется Natasha, а не человек?

DD

В описании есть фраза: "В соревновании представлен бейзлайн, полученный применением средств нормализации из библиотеки Natasha". Что это означает, что в качестве эталонной нормализации используется Natasha, а не человек?

Бейзлайн - это не ground truth, а простой пример решения задачи)

AK

Всем привет!

В ODS, в канале #nlp недавно был вопрос про разрешение кореференции для русского языка, и в одном из ответов упомянулось, что в Natasha есть такая функциональность.

Однако, не нашел ничего в документации. Может кто-то проконсультировать по данному вопросу?

Заранее спасибо!

В ODS, в канале #nlp недавно был вопрос про разрешение кореференции для русского языка, и в одном из ответов упомянулось, что в Natasha есть такая функциональность.

Однако, не нашел ничего в документации. Может кто-то проконсультировать по данному вопросу?

Заранее спасибо!

В Наташе нет такой функциональности

Был конкурс на Диалоге, можно покопать http://www.dialog-21.ru/evaluation/2019/disambiguation/anaphora/

Что-то есть в Диппавлове https://github.com/deepmipt/DeepPavlov/issues/1344, не трогал, вроде основано на https://github.com/kentonl/e2e-coref

Был конкурс на Диалоге, можно покопать http://www.dialog-21.ru/evaluation/2019/disambiguation/anaphora/

Что-то есть в Диппавлове https://github.com/deepmipt/DeepPavlov/issues/1344, не трогал, вроде основано на https://github.com/kentonl/e2e-coref

AK

В описании есть фраза: "В соревновании представлен бейзлайн, полученный применением средств нормализации из библиотеки Natasha". Что это означает, что в качестве эталонной нормализации используется Natasha, а не человек?

Да, бейзлайн это пример решения от организаторов, которое все должны легко обойти. Вообще достаточно обидно )), я думал в Наташе норм нормализация

N

надеюсь, правда перепуталось просто в голове GT и бейзлайн, удивление понятно тогда :)

YB

Да, бейзлайн это пример решения от организаторов, которое все должны легко обойти. Вообще достаточно обидно )), я думал в Наташе норм нормализация

Ну, у них 0.69 получилось, как я понял, неплохо вроде. Там поди ещё примеры были достаточно сложные, в обычных текстах получше будет.

DK

В Наташе нет такой функциональности

Был конкурс на Диалоге, можно покопать http://www.dialog-21.ru/evaluation/2019/disambiguation/anaphora/

Что-то есть в Диппавлове https://github.com/deepmipt/DeepPavlov/issues/1344, не трогал, вроде основано на https://github.com/kentonl/e2e-coref

Был конкурс на Диалоге, можно покопать http://www.dialog-21.ru/evaluation/2019/disambiguation/anaphora/

Что-то есть в Диппавлове https://github.com/deepmipt/DeepPavlov/issues/1344, не трогал, вроде основано на https://github.com/kentonl/e2e-coref

Павлова трогал я, до продакшна там далековато

В целом хороших открытых решений на ря нет или почти нет

В целом хороших открытых решений на ря нет или почти нет

GZ

Друзья,

Есть сотни новостей, нужно найти из них одинаковые и похожие новости.

Подскажите пожалуйста алгоритмы и технологии при помощи которых, это можно реализовать.

Есть сотни новостей, нужно найти из них одинаковые и похожие новости.

Подскажите пожалуйста алгоритмы и технологии при помощи которых, это можно реализовать.

DD

Друзья,

Есть сотни новостей, нужно найти из них одинаковые и похожие новости.

Подскажите пожалуйста алгоритмы и технологии при помощи которых, это можно реализовать.

Есть сотни новостей, нужно найти из них одинаковые и похожие новости.

Подскажите пожалуйста алгоритмы и технологии при помощи которых, это можно реализовать.

Про это прямо сейчас идёт дорожка, там есть лидерборд, где можно посмотреть решения, и телеграм-чат, где их можно обсудить)

GZ

Про это прямо сейчас идёт дорожка, там есть лидерборд, где можно посмотреть решения, и телеграм-чат, где их можно обсудить)

Ухты, спасибо большое

AK

Переслано от Maša Ponomareva

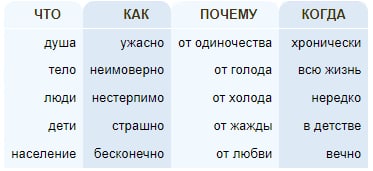

Привет!

Посмотрите на картинку, на ней семантический скетч глагола. Сможете догадаться, какого? Семантический скетч отражает сочетаемость слова в корпусе, для человека хорошо построенные скетчи являются вполне репрезентативными, а так ли это для машины? Мы приглашаем вас поучаствовать в дорожке Диалога (да, их в этом году очень много), которая называется SemSketches. В рамках дорожки участникам предстоит угадывать по слову в контексте, к какому семантическому скетчу оно относится. Задача экспериментальная и новая, большая свобода для идей и интересные данные. Очень ждем участников!

Чат в телеграме

Гитхаб соревнования (подробности, данные, таймлайн там)

Посмотрите на картинку, на ней семантический скетч глагола. Сможете догадаться, какого? Семантический скетч отражает сочетаемость слова в корпусе, для человека хорошо построенные скетчи являются вполне репрезентативными, а так ли это для машины? Мы приглашаем вас поучаствовать в дорожке Диалога (да, их в этом году очень много), которая называется SemSketches. В рамках дорожки участникам предстоит угадывать по слову в контексте, к какому семантическому скетчу оно относится. Задача экспериментальная и новая, большая свобода для идей и интересные данные. Очень ждем участников!

Чат в телеграме

Гитхаб соревнования (подробности, данные, таймлайн там)