p

Size: a a a

2020 November 12

SM

Господа, вопрос не в тему, но точно кто то может подсказать про corosync-pacemaker, две ноды без кворума, тушу одну из них и ожидаемого переезда VIP не наблюдаю, получаю какой то таймаут

G

Господа, вопрос не в тему, но точно кто то может подсказать про corosync-pacemaker, две ноды без кворума, тушу одну из них и ожидаемого переезда VIP не наблюдаю, получаю какой то таймаут

stonith как-то настраивали под двунодность то?

SM

Д, все вырублено

G

Д, все вырублено

ну таймаут 99% про отвал второй ноды

SM

Гм, есть чего почитать на нубском?

G

Гм, есть чего почитать на нубском?

6. If your cluster consists of just two nodes, switch the quorum feature off.

On a single server enter the following:

pcs property set no-quorum-policy=ignore

SM

Да, это делал само собой

G

Да, это делал само собой

а на чём таймаут то?

SM

На выполнении скрипта ocf. Не у компа, так бы показал.

SM

а на чём таймаут то?

сопсно вот, одну из нод тушу, в pcs status вижу

Failed Actions:

* floating_ip_start_0 on proxy-backup 'unknown error' (1): call=20, status=Timed Out, exitreason='',

last-rc-change='Thu Nov 12 19:59:45 2020', queued=0ms, exec=60007ms

k

Alexander

Какие диски в итоге то?)) по какому протоколу его подключили? Файлик хотябы размером 100G , а не 4

3par - 16 drives iSCSI (SSD_r6)

drbd9 - 2 replicas (diskless)

drbd9 - 2 replicas (local)

local lvm (SAMSUNG MZ1LB960HAJQ-00007):

-iodepth=1

write: IOPS=2448, BW=9796KiB/s

clat (usec): avg=366.08

-iodepth=32

write: IOPS=53.3k, BW=208MiB/s

clat (usec): avg=593.22

-iodepth=512

write: IOPS=74.0k, BW=293MiB/s

clat (msec): avg= 6.82

-iodepth=1024

write: IOPS=81.0k, BW=317MiB/s

clat (msec): avg=12.62

# ------------------------------

-iodepth=1

read: IOPS=1932, BW=7731KiB/s

clat (usec): avg=466.63

-iodepth=32

read: IOPS=39.0k, BW=156MiB/s

clat (usec): avg=789.10

-iodepth=512

read: IOPS=127k, BW=496MiB/s

clat (usec): avg=4027.47

-iodepth=1024

read: IOPS=122k, BW=478MiB/s

clat (msec): avg= 8.35

drbd9 - 2 replicas (diskless)

-iodepth=1

write: IOPS=3068, BW=11.0MiB/s

clat (usec): avg=304.12

-iodepth=32

write: IOPS=42.8k, BW=167MiB/s

clat (usec): avg=743.61

-iodepth=512

write: IOPS=63.2k, BW=247MiB/s

clat (usec): avg=8090.49

-iodepth=1024

write: IOPS=65.1k, BW=254MiB/s

clat (usec): avg=15722.37

# ------------------------------

-iodepth=1

read: IOPS=2862, BW=11.2MiB/s

clat (usec): avg=317.75

-iodepth=32

read: IOPS=120k, BW=469MiB/s

clat (usec): avg=262.24

-iodepth=512

read: IOPS=122k, BW=476MiB/s

clat (usec): avg=258.51

-iodepth=1024

read: IOPS=141k, BW=550MiB/s

clat (usec): avg=7263.16

drbd9 - 2 replicas (local)

-iodepth=1

write: IOPS=3907, BW=15.3MiB/s

clat (usec): avg=247.98

-iodepth=32

write: IOPS=43.8k, BW=171MiB/s

clat (usec): avg=726.06

-iodepth=512

write: IOPS=63.6k, BW=248MiB/s

clat (usec): avg=8046.25

-iodepth=1024

write: IOPS=65.6k, BW=256MiB/s

clat (usec): avg=15597.82

# ------------------------------

-iodepth=1

read: IOPS=9778, BW=38.2MiB/s

clat (nsec): avg=85923.27

-iodepth=32

read: IOPS=107k, BW=418MiB/s

clat (usec): avg=290.36

-iodepth=512

read: IOPS=106k, BW=414MiB/s

clat (usec): avg=4827.09

-iodepth=1024

read: IOPS=103k, BW=403MiB/s

clat (usec): avg=9905.72

local lvm (SAMSUNG MZ1LB960HAJQ-00007):

-iodepth=1

write: IOPS=32.1k, BW=126MiB/s

clat (nsec): avg=22502.97

-iodepth=32

write: IOPS=118k, BW=461MiB/s

clat (usec): avg=263.21

-iodepth=512

write: IOPS=115k, BW=449MiB/s

clat (usec): avg=4446.25

-iodepth=1024

write: IOPS=116k, BW=452MiB/s

clat (usec): avg=8831.70

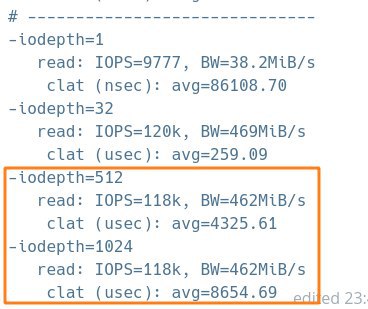

# ------------------------------

-iodepth=1

read: IOPS=9777, BW=38.2MiB/s

clat (nsec): avg=86108.70

-iodepth=32

read: IOPS=120k, BW=469MiB/s

clat (usec): avg=259.09

-iodepth=512

read: IOPS=118k, BW=462MiB/s

clat (usec): avg=4325.61

-iodepth=1024

read: IOPS=118k, BW=462MiB/s

clat (usec): avg=8654.69

k

сэмпл 100 гигов и там и там, drbd на тех же самсунгах запускался

I

похоже на проявление bus saturation

2020 November 13

k

А можешь пояснить?

I

если я правильно угадал, то бутылочным горлышком является сеть к схд или интерфейс к ссд. косвенным признаком bus saturation является рост latency при тех же иопсах.

I

т.е. если бы уперся в ссд, то скорее всего огромный iodepth показал бы меньше iops в итоге.

A

если я правильно угадал, то бутылочным горлышком является сеть к схд или интерфейс к ссд. косвенным признаком bus saturation является рост latency при тех же иопсах.

То же заметил, что бендвич выше 462 не поднимается

A

3par - 16 drives iSCSI (SSD_r6)

drbd9 - 2 replicas (diskless)

drbd9 - 2 replicas (local)

local lvm (SAMSUNG MZ1LB960HAJQ-00007):

-iodepth=1

write: IOPS=2448, BW=9796KiB/s

clat (usec): avg=366.08

-iodepth=32

write: IOPS=53.3k, BW=208MiB/s

clat (usec): avg=593.22

-iodepth=512

write: IOPS=74.0k, BW=293MiB/s

clat (msec): avg= 6.82

-iodepth=1024

write: IOPS=81.0k, BW=317MiB/s

clat (msec): avg=12.62

# ------------------------------

-iodepth=1

read: IOPS=1932, BW=7731KiB/s

clat (usec): avg=466.63

-iodepth=32

read: IOPS=39.0k, BW=156MiB/s

clat (usec): avg=789.10

-iodepth=512

read: IOPS=127k, BW=496MiB/s

clat (usec): avg=4027.47

-iodepth=1024

read: IOPS=122k, BW=478MiB/s

clat (msec): avg= 8.35

drbd9 - 2 replicas (diskless)

-iodepth=1

write: IOPS=3068, BW=11.0MiB/s

clat (usec): avg=304.12

-iodepth=32

write: IOPS=42.8k, BW=167MiB/s

clat (usec): avg=743.61

-iodepth=512

write: IOPS=63.2k, BW=247MiB/s

clat (usec): avg=8090.49

-iodepth=1024

write: IOPS=65.1k, BW=254MiB/s

clat (usec): avg=15722.37

# ------------------------------

-iodepth=1

read: IOPS=2862, BW=11.2MiB/s

clat (usec): avg=317.75

-iodepth=32

read: IOPS=120k, BW=469MiB/s

clat (usec): avg=262.24

-iodepth=512

read: IOPS=122k, BW=476MiB/s

clat (usec): avg=258.51

-iodepth=1024

read: IOPS=141k, BW=550MiB/s

clat (usec): avg=7263.16

drbd9 - 2 replicas (local)

-iodepth=1

write: IOPS=3907, BW=15.3MiB/s

clat (usec): avg=247.98

-iodepth=32

write: IOPS=43.8k, BW=171MiB/s

clat (usec): avg=726.06

-iodepth=512

write: IOPS=63.6k, BW=248MiB/s

clat (usec): avg=8046.25

-iodepth=1024

write: IOPS=65.6k, BW=256MiB/s

clat (usec): avg=15597.82

# ------------------------------

-iodepth=1

read: IOPS=9778, BW=38.2MiB/s

clat (nsec): avg=85923.27

-iodepth=32

read: IOPS=107k, BW=418MiB/s

clat (usec): avg=290.36

-iodepth=512

read: IOPS=106k, BW=414MiB/s

clat (usec): avg=4827.09

-iodepth=1024

read: IOPS=103k, BW=403MiB/s

clat (usec): avg=9905.72

local lvm (SAMSUNG MZ1LB960HAJQ-00007):

-iodepth=1

write: IOPS=32.1k, BW=126MiB/s

clat (nsec): avg=22502.97

-iodepth=32

write: IOPS=118k, BW=461MiB/s

clat (usec): avg=263.21

-iodepth=512

write: IOPS=115k, BW=449MiB/s

clat (usec): avg=4446.25

-iodepth=1024

write: IOPS=116k, BW=452MiB/s

clat (usec): avg=8831.70

# ------------------------------

-iodepth=1

read: IOPS=9777, BW=38.2MiB/s

clat (nsec): avg=86108.70

-iodepth=32

read: IOPS=120k, BW=469MiB/s

clat (usec): avg=259.09

-iodepth=512

read: IOPS=118k, BW=462MiB/s

clat (usec): avg=4325.61

-iodepth=1024

read: IOPS=118k, BW=462MiB/s

clat (usec): avg=8654.69

Попробуй дать поток 128к блоком

I

Alexander

То же заметил, что бендвич выше 462 не поднимается

да, но поидее и время не должно было бы вырасти.