IB

Size: a a a

2020 September 05

Большая часть документов на сайте Правительства публикуется с задержкой примерно в 1.5 месяца, получается что вот такие "сливы" в телеграм каналах - единственный способ получать свежую информацию

AB

Там всё довольно сильно устарело, если честно. Вообще открытое правительство с 2014 года было уже неживым. Как только стало понятно что Россия выпала из G8 и не вступит в ОЭСР в ближайшем будущем, то всё переориентировалось на внутреннюю повестку и ну далее там только хуже становилось.

Новое - это хорошо забытое старое.

А старое про открытость ФОИВов уже хорошо забыто. Так что, сейчас оно должно хорошо зайти на ноаенького )

А старое про открытость ФОИВов уже хорошо забыто. Так что, сейчас оно должно хорошо зайти на ноаенького )

DP

Большая часть документов на сайте Правительства публикуется с задержкой примерно в 1.5 месяца, получается что вот такие "сливы" в телеграм каналах - единственный способ получать свежую информацию

Ну то есть даже с задержкой такое поручение должно попасть на сайт правительства или такого рода документ туда не попадет никогда и не должен?

AB

Ну то есть даже с задержкой такое поручение должно попасть на сайт правительства или такого рода документ туда не попадет никогда и не должен?

Поручения вице-премьеров и ниже никогда не публикуются. Поручения премьера достаточно часто публикуются под заголовками "Поручения по итогам совещания..."

IB

Ну то есть даже с задержкой такое поручение должно попасть на сайт правительства или такого рода документ туда не попадет никогда и не должен?

Обязанности публиковать такие документы у аппарата Пр-ва нет. Открытость аппарата, работы вице-премьеров, ресурсы пр-ва - это отдельная большая тема для исследования. Просто вот проведем мы его и к кому с ним идти, к Владимиру Владимировичу Путину? ;) Это же вопрос политической прозрачности куда больше чем функциональной. Если про ФОИВы ещё можно говорить что они выполняют госфункции и поэтому те кто недостаточны открыты к народу должны срочно исправиться, то в этом случае так не получается.

DP

Спасибо, по всему выходит, что "правительство на другой планете, родной" ))

VK

к вопросу об открытых данных:

«неправомерно использовать математику в тех случаях, где она не может ничего объяснить»

https://m.lenta.ru/news/2020/09/03/matematika_i_vybory/?fbclid=IwAR2d6lcZw2e9aYm3n_8gsqgN5UtEhuL7l4_YRi8CmDrAQFicWYQDyOrp2-w

«неправомерно использовать математику в тех случаях, где она не может ничего объяснить»

https://m.lenta.ru/news/2020/09/03/matematika_i_vybory/?fbclid=IwAR2d6lcZw2e9aYm3n_8gsqgN5UtEhuL7l4_YRi8CmDrAQFicWYQDyOrp2-w

C

Приветствуем Вас!

В качестве подтверждения, что Вы не бот, просьба представиться и рассказать о себе. Если окажется что Вы не человек, то Вы можете быть удалены из чата. Также в чате предусмотрен вечный бан за рекламу

В качестве подтверждения, что Вы не бот, просьба представиться и рассказать о себе. Если окажется что Вы не человек, то Вы можете быть удалены из чата. Также в чате предусмотрен вечный бан за рекламу

NK

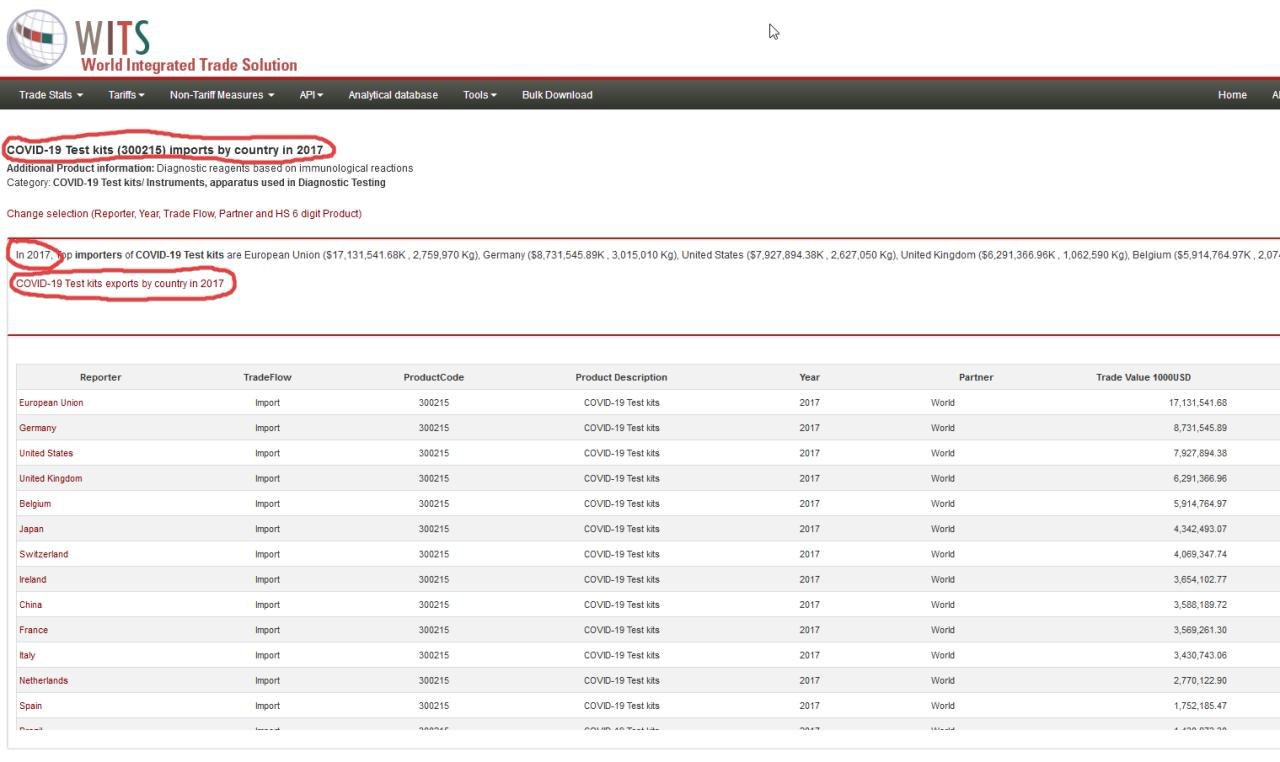

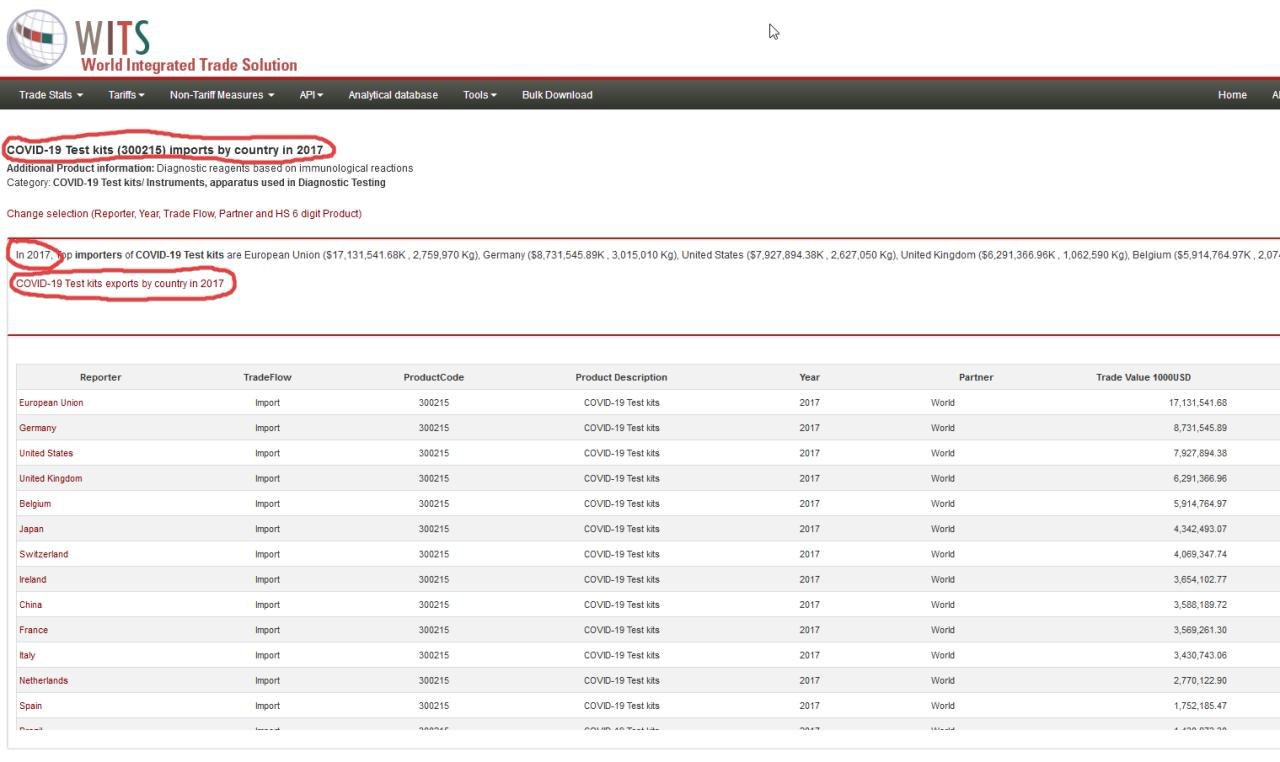

Любителям рептилоидов, чипирования граждан, всемирного заговора масонов и прочих интересных способов скоротать свою разумную жизнь подкидываю ещё одну тему "мирового заговора". На сайте World Integrated Trade Solution, где Всемирный банк публикует статистику торговли между странами есть раздел COVID-19 test kits (тестирование на COVID-19) и статистика за 2017, 2018 и 2019 годы. Ссылка https://wits.worldbank.org/trade/comtrade/en/country/ALL/year/2017/tradeflow/Imports/partner/WLD/nomen/h5/product/300215

Что тут скажешь, ошибаются все, включая Всемирный банк.

Или мы что-то не знаем... ?

P.S. Пора заводить рубрику #юмор на канале, хотя ошибка и самая что ни на есть настоящая

Что тут скажешь, ошибаются все, включая Всемирный банк.

Или мы что-то не знаем... ?

P.S. Пора заводить рубрику #юмор на канале, хотя ошибка и самая что ни на есть настоящая

VK

ID:0

Любителям рептилоидов, чипирования граждан, всемирного заговора масонов и прочих интересных способов скоротать свою разумную жизнь подкидываю ещё одну тему "мирового заговора". На сайте World Integrated Trade Solution, где Всемирный банк публикует статистику торговли между странами есть раздел COVID-19 test kits (тестирование на COVID-19) и статистика за 2017, 2018 и 2019 годы. Ссылка https://wits.worldbank.org/trade/comtrade/en/country/ALL/year/2017/tradeflow/Imports/partner/WLD/nomen/h5/product/300215

Что тут скажешь, ошибаются все, включая Всемирный банк.

Или мы что-то не знаем... ?

P.S. Пора заводить рубрику #юмор на канале, хотя ошибка и самая что ни на есть настоящая

Что тут скажешь, ошибаются все, включая Всемирный банк.

Или мы что-то не знаем... ?

P.S. Пора заводить рубрику #юмор на канале, хотя ошибка и самая что ни на есть настоящая

шутки шутками,

а частота подробных объяснений, что такое R0, в кино и сериалах

по субъективным ощущениям где-то с 2010 года росла экспоненциально

а частота подробных объяснений, что такое R0, в кино и сериалах

по субъективным ощущениям где-то с 2010 года росла экспоненциально

2020 September 06

DP

Все это уже было в симпсонах

C

Приветствуем Вас!

В качестве подтверждения, что Вы не бот, просьба представиться и рассказать о себе. Если окажется что Вы не человек, то Вы можете быть удалены из чата. Также в чате предусмотрен вечный бан за рекламу

В качестве подтверждения, что Вы не бот, просьба представиться и рассказать о себе. Если окажется что Вы не человек, то Вы можете быть удалены из чата. Также в чате предусмотрен вечный бан за рекламу

2020 September 07

NK

Для тех кто интересуется как устроено пространство работы с данными (data engineering) то весьма неплохая дорожная карта дата инженерии на Github [1]. Правда, я вот лично, могу сказать что я лично владею в основном другим стеком инструментов да и большинство devops и dataops инженеров тоже, поскольку в реальном мире ты, как правило, совмещаешь очень много ролей и профессий, и лишь немногие очень чётко и узко сфокусированы на развитии только в одном профессиональном направлении.

Что бы я отметил:

- есть очень большая разница в инструментах которые выходят из систем связанных с работой с онлайн пользователями и, например, с инструментами и средой работы с открытыми данными. Системы выходящие из цифровых стартапов почти все заточены на сбор данных систем аналитики, статистики, счетчиков и тд. Они как правило готовые или полуготовые, с кучей интеграций и работой в реальном времени.

- инструменты работающие с открытыми данными куда сложнее, даже если источников относительно немного, всегда есть проблема в том что публикующие данные меняют свои сайты, форматы, схемы предоставления данных. Сами данные публикуются изначально в различных формах. От данных в виде HTML таблиц, то Excel файлов упакованных в RAR или 7z архивы и тд. Есть несколько стартапов которые пытаются гармонизировать данные и решать эту проблему, но не то чтобы очень успешно. Также нет и универсального инструмента по сборке данных (data build tool).

- в принципе, с инструментами беда, особенно для государства. В России 2-3 решения имеющие коммерческую природу и чаще используется стек работы с данными Apache поскольку и Java специалистов много и инструменты вроде Hadoop'а уже входят в программы обучения во многих ВУЗах.

Интересно было бы поговорить о цельных стеках по data engineering в России. Кто какие инструменты использует и для каких задач.

Ссылки:

[1] https://github.com/datastacktv/data-engineer-roadmap

#data #dataengineering

Что бы я отметил:

- есть очень большая разница в инструментах которые выходят из систем связанных с работой с онлайн пользователями и, например, с инструментами и средой работы с открытыми данными. Системы выходящие из цифровых стартапов почти все заточены на сбор данных систем аналитики, статистики, счетчиков и тд. Они как правило готовые или полуготовые, с кучей интеграций и работой в реальном времени.

- инструменты работающие с открытыми данными куда сложнее, даже если источников относительно немного, всегда есть проблема в том что публикующие данные меняют свои сайты, форматы, схемы предоставления данных. Сами данные публикуются изначально в различных формах. От данных в виде HTML таблиц, то Excel файлов упакованных в RAR или 7z архивы и тд. Есть несколько стартапов которые пытаются гармонизировать данные и решать эту проблему, но не то чтобы очень успешно. Также нет и универсального инструмента по сборке данных (data build tool).

- в принципе, с инструментами беда, особенно для государства. В России 2-3 решения имеющие коммерческую природу и чаще используется стек работы с данными Apache поскольку и Java специалистов много и инструменты вроде Hadoop'а уже входят в программы обучения во многих ВУЗах.

Интересно было бы поговорить о цельных стеках по data engineering в России. Кто какие инструменты использует и для каких задач.

Ссылки:

[1] https://github.com/datastacktv/data-engineer-roadmap

#data #dataengineering

NK

С электронным паспортом и мобильным идентификатором тоже непонятная история. По мнению Чернышенко, "там все уже создано, вопрос в сертификации и криптозащите ключей электронных квалифицированных подписей"... Вопрос, надо сказать — главный. Так что еще пока ничего не создано.. https://tass.ru/ekonomika/9344573

ГМ

ID:0

С электронным паспортом и мобильным идентификатором тоже непонятная история. По мнению Чернышенко, "там все уже создано, вопрос в сертификации и криптозащите ключей электронных квалифицированных подписей"... Вопрос, надо сказать — главный. Так что еще пока ничего не создано.. https://tass.ru/ekonomika/9344573

нормативный акт, как я понял, до сих пор не утвержден

IB

нормативный акт, как я понял, до сих пор не утвержден

да, его пока невидать

G

Подскажите, кто в курсе -

В файле JSON контракта с госзакупок есть ссылка на документ. Но при переходе по ссылке она не доступна и сам файл не доступен.

Как скачать файл?

В файле JSON контракта с госзакупок есть ссылка на документ. Но при переходе по ссылке она не доступна и сам файл не доступен.

Как скачать файл?

IB

скорее всего невозможно скачать. Такое бывает с документами и закупками по 223--ФЗ. Попробуйте по заказчику поискать закупку в реестр, часто данные в JSON и данные на сайте кодированы по разному

VK

ID:0

Для тех кто интересуется как устроено пространство работы с данными (data engineering) то весьма неплохая дорожная карта дата инженерии на Github [1]. Правда, я вот лично, могу сказать что я лично владею в основном другим стеком инструментов да и большинство devops и dataops инженеров тоже, поскольку в реальном мире ты, как правило, совмещаешь очень много ролей и профессий, и лишь немногие очень чётко и узко сфокусированы на развитии только в одном профессиональном направлении.

Что бы я отметил:

- есть очень большая разница в инструментах которые выходят из систем связанных с работой с онлайн пользователями и, например, с инструментами и средой работы с открытыми данными. Системы выходящие из цифровых стартапов почти все заточены на сбор данных систем аналитики, статистики, счетчиков и тд. Они как правило готовые или полуготовые, с кучей интеграций и работой в реальном времени.

- инструменты работающие с открытыми данными куда сложнее, даже если источников относительно немного, всегда есть проблема в том что публикующие данные меняют свои сайты, форматы, схемы предоставления данных. Сами данные публикуются изначально в различных формах. От данных в виде HTML таблиц, то Excel файлов упакованных в RAR или 7z архивы и тд. Есть несколько стартапов которые пытаются гармонизировать данные и решать эту проблему, но не то чтобы очень успешно. Также нет и универсального инструмента по сборке данных (data build tool).

- в принципе, с инструментами беда, особенно для государства. В России 2-3 решения имеющие коммерческую природу и чаще используется стек работы с данными Apache поскольку и Java специалистов много и инструменты вроде Hadoop'а уже входят в программы обучения во многих ВУЗах.

Интересно было бы поговорить о цельных стеках по data engineering в России. Кто какие инструменты использует и для каких задач.

Ссылки:

[1] https://github.com/datastacktv/data-engineer-roadmap

#data #dataengineering

Что бы я отметил:

- есть очень большая разница в инструментах которые выходят из систем связанных с работой с онлайн пользователями и, например, с инструментами и средой работы с открытыми данными. Системы выходящие из цифровых стартапов почти все заточены на сбор данных систем аналитики, статистики, счетчиков и тд. Они как правило готовые или полуготовые, с кучей интеграций и работой в реальном времени.

- инструменты работающие с открытыми данными куда сложнее, даже если источников относительно немного, всегда есть проблема в том что публикующие данные меняют свои сайты, форматы, схемы предоставления данных. Сами данные публикуются изначально в различных формах. От данных в виде HTML таблиц, то Excel файлов упакованных в RAR или 7z архивы и тд. Есть несколько стартапов которые пытаются гармонизировать данные и решать эту проблему, но не то чтобы очень успешно. Также нет и универсального инструмента по сборке данных (data build tool).

- в принципе, с инструментами беда, особенно для государства. В России 2-3 решения имеющие коммерческую природу и чаще используется стек работы с данными Apache поскольку и Java специалистов много и инструменты вроде Hadoop'а уже входят в программы обучения во многих ВУЗах.

Интересно было бы поговорить о цельных стеках по data engineering в России. Кто какие инструменты использует и для каких задач.

Ссылки:

[1] https://github.com/datastacktv/data-engineer-roadmap

#data #dataengineering

я бы отметил, что авторы путают фундаментальные понятия и навыки с (исторически случайными) брендированными воплощениями в пропорции 10 на 90, примерно

при том, что если есть первое — навыки — освоить любую конкретную реализацию дело считанных часов-дней-ок, пары недель, максимум

при том, что если есть первое — навыки — освоить любую конкретную реализацию дело считанных часов-дней-ок, пары недель, максимум

G

скорее всего невозможно скачать. Такое бывает с документами и закупками по 223--ФЗ. Попробуйте по заказчику поискать закупку в реестр, часто данные в JSON и данные на сайте кодированы по разному

Закупка у единственного, по 223фз.

Извещение не размещалось.

На госзакупке данной закупки нет...

Извещение не размещалось.

На госзакупке данной закупки нет...