SK

Size: a a a

2021 February 11

Борис Добров

И будет ли обоснованием использовать bert при росте 5%

хочу попробовать, пока время и ресурсы есть.

SK

И еще такой вопрос, а кто делал тональность для новости в зависимости от слова, например в какой-то новости упоминается персона, новость позитивная, а упоминания про персону нейтральное

БД

А ха ха , там все еще сложнее, stance, bias, контекст...

Пока только скребут пр поверхеости.

Можно забить, обычнл для источника все стандартно, можно пытаться стабилизировать средним.

Если ошибки важны, нужен редактор.

Обрабатывется 100 тысяч новостей в день, а на морду или в справку идет 100.

Пока только скребут пр поверхеости.

Можно забить, обычнл для источника все стандартно, можно пытаться стабилизировать средним.

Если ошибки важны, нужен редактор.

Обрабатывется 100 тысяч новостей в день, а на морду или в справку идет 100.

БД

Ксати высокий accuracy по чему то типа rouge , гоаорит о том что примеры близки к leed.

В такой постановке задача почти вырожденная.

В такой постановке задача почти вырожденная.

AZ

Всем привет! Скажите, можно ли кому-то в личку задать вопросы по экспорту pytorch модели из azure ml? Пользуюсь платформой совсем недавно, запуталась)

2021 February 12

YB

Всем привет! Наш семинар возобновляет вещание. Приглашаем вас в четверг, 11 февраля, в 19-00.

Тема: "Spacy для NLP: прошлое, настоящее, будущее".

Докладчик:

Юрий Бабуров, CTO в компании ApRbot (обработка неструктурированных документов), создатель библиотек spaCy-Ru, python-readability и соавтор крупнейшего корпуса русской речи OpenSTT, преподаватель курса по нейросетям в магистратуре НГУ, соавтор курса https://dlcourse.ai

Аннотация: Spacy для NLP: прошлое, настоящее, будущее.

Расскажу про задачи, которые решает пакет Spacy,

и про то, как он это делает. Морфология и лемматизация, NER,

синтаксический анализ, классификация. SOTA или скорость.

Семинар пройдет в онлайн-формате.

Ссылка на регистрацию

(!) Алгоритм регистрации: надо заполнить форму, ближе к семинару вам придет письмо с ссылкой на zoom и паролем.

Тема: "Spacy для NLP: прошлое, настоящее, будущее".

Докладчик:

Юрий Бабуров, CTO в компании ApRbot (обработка неструктурированных документов), создатель библиотек spaCy-Ru, python-readability и соавтор крупнейшего корпуса русской речи OpenSTT, преподаватель курса по нейросетям в магистратуре НГУ, соавтор курса https://dlcourse.ai

Аннотация: Spacy для NLP: прошлое, настоящее, будущее.

Расскажу про задачи, которые решает пакет Spacy,

и про то, как он это делает. Морфология и лемматизация, NER,

синтаксический анализ, классификация. SOTA или скорость.

Семинар пройдет в онлайн-формате.

Ссылка на регистрацию

(!) Алгоритм регистрации: надо заполнить форму, ближе к семинару вам придет письмо с ссылкой на zoom и паролем.

Запись опубликована: https://youtu.be/8nTXED4R5T4 : Spacy и Spacy Ru : прошлое, настоящее, будущее.

YB

Запись опубликована: https://youtu.be/8nTXED4R5T4 : Spacy и Spacy Ru : прошлое, настоящее, будущее.

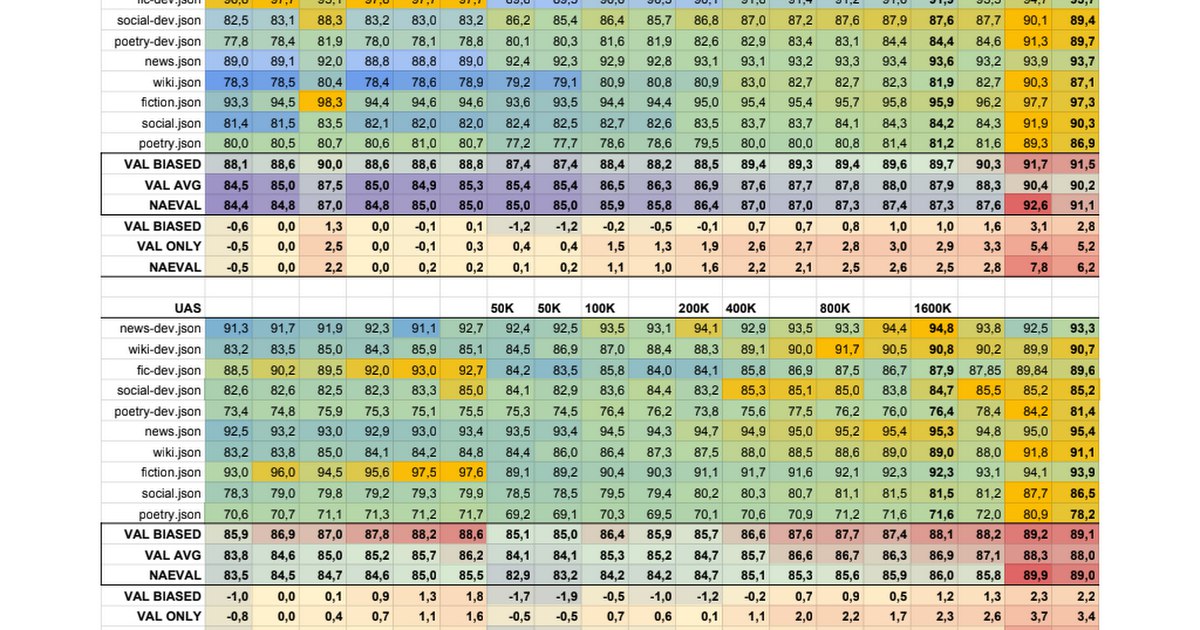

Если кому нужна табличка по моделям spacy ru, упоминаемая в конце доклада: https://docs.google.com/spreadsheets/u/0/d/1laE3m3KmNlNk6HN3dC63IOs6aB8qyGnqusc1wX2SGdQ/edit

➔m

Если кому нужна табличка по моделям spacy ru, упоминаемая в конце доклада: https://docs.google.com/spreadsheets/u/0/d/1laE3m3KmNlNk6HN3dC63IOs6aB8qyGnqusc1wX2SGdQ/edit

Спасибо вам большое.

VS

Добрый день! Есть фанаты Protege ? С кем можно пообщаться?

AC

Может кто-то знает, можно ли в protege конвертировать individuals to classes?

AC

AC

Vitalii Smirnov

Добрый день! Есть фанаты Protege ? С кем можно пообщаться?

Тот который для kg ? Тут у нас обсуждали @kg_course . Или это другое ?

VS

да да. это. сейчас буду смотреть. спасибо

2021 February 13

МП

Всем привет!

Подскажите, может у кого был опыт.

Тыкаю bigartm. Как там можно задать заранее какие-то темы?

Как Seeded lda (где мы проставляем ключевые слова темы), но желательно просто подать на модель размеченные тексты заранее определенных тем, и все остальные тексты.

Подскажите, может у кого был опыт.

Тыкаю bigartm. Как там можно задать заранее какие-то темы?

Как Seeded lda (где мы проставляем ключевые слова темы), но желательно просто подать на модель размеченные тексты заранее определенных тем, и все остальные тексты.

МП

То есть, если говорить более научно, как задать семантические ядра тем если есть разметка этих текстов.

KK

Доброй ночи! Подскажите нубу: вот у меня есть в txt некоторое количество книг, и я хочу создать из них датасет для задачи "моделирования языка". Правильно я понимаю, что нужно сперва нужно перевести тексты в таблицу вида "предложение1":"предложение2", притом, чтобы их длины были одинаковы? А потом уже в с помощью torchtext и spacy создать датасет для загрузки в какую-нибудь сетку типа трансформера?

2021 February 14

d

Krep Kospit

Доброй ночи! Подскажите нубу: вот у меня есть в txt некоторое количество книг, и я хочу создать из них датасет для задачи "моделирования языка". Правильно я понимаю, что нужно сперва нужно перевести тексты в таблицу вида "предложение1":"предложение2", притом, чтобы их длины были одинаковы? А потом уже в с помощью torchtext и spacy создать датасет для загрузки в какую-нибудь сетку типа трансформера?

Не знаю зачем там одинаковые длины (padding батча в loader можно организовать), но getitem от torch.utils.data.Dataset вполне можно научить выдавать два последовательных элемента из списка )

Torchtext это бесполезная боль, imho

Так, что

Torchtext это бесполезная боль, imho

Так, что

from torch.utils.data import Dataset, DataLoaderИ вперёд

KK

Не знаю зачем там одинаковые длины (padding батча в loader можно организовать), но getitem от torch.utils.data.Dataset вполне можно научить выдавать два последовательных элемента из списка )

Torchtext это бесполезная боль, imho

Так, что

Torchtext это бесполезная боль, imho

Так, что

from torch.utils.data import Dataset, DataLoaderИ вперёд

Спасибо за ответ! А что не так с torchtext? Видел примеры, где с его помощью из csv или json делали загрузчики данных.

d

Krep Kospit

Спасибо за ответ! А что не так с torchtext? Видел примеры, где с его помощью из csv или json делали загрузчики данных.

Я бы поставил вопрос как: а что с ним вообще так?

Это конечно классно вызывать

над

(мог ошибиться с названием метода), только потом узнаёшь, что этот метод тебе не нужен, возможностей Field тебе мало, а то что тебе нужно очень уродливо реализовывать посредством torchtext

Это конечно классно вызывать

build_vocabulary

над

Field

(мог ошибиться с названием метода), только потом узнаёшь, что этот метод тебе не нужен, возможностей Field тебе мало, а то что тебе нужно очень уродливо реализовывать посредством torchtext