Oℕ

Size: a a a

2019 March 20

По поводу ML ничего не могу сказать, но рисование стрелочек выглядит как обычная теория графов, при чём тут категории — непонятно

Ну теория графов обычно не описывает, как правильно вершины разукрашивать, и как такие графы композить

Oℕ

С учётом каких-то циклических построений a-la LSTM графы мало света проливают

Oℕ

Вон у Фонга же много было про (гипер)графы и как вывести свойства порождённой категории графов из свойств базовой моноидальной

AG

Тот чешский математик сейчас пишет статью про CycleGAN, т.е. развивает свою теорию и для других алгоритмов машинного обучения

если имеется в виду Гавранович, то он хорват :)

AG

В хаскеле есть рок-звезда мессия, затащившая похоже, почти весь теоркат, который вообще только можно натянуть на ЯП в его инкарнации 5 лет назад. Некоторые из вещей вполне прагматично юзабельны, типа оптик (lens) и абстракций над независимыми (ко)индуктивными типами (recursion schemes)

нуу схемы рекурсий ещё до кметта в фп появились, это как минимум конец 80х

A

если имеется в виду Гавранович, то он хорват :)

да, он, я ошиблась

PS

Возможно, но я сюда заглянула, чтобы обсуждать и спорить, обмениваться аргументами, а не молча соглашаться с мнениями кого-то более авторитетного. Пока что вы выразили мнение. Объясните, почему. Я подразумеваю под интерпретируемостью ML моделей возможность объяснить до коэффициента их вывод. В каком контексте вы используете термин symbol grounding?

потому что проблема интерпретируемости состоит в поиске общей семантики для задающего задачу и решающей её метамодели. задача сообщения семантики нейросети до сих пор является открытой - мы не научились учить сеть нашему языку и нашим формальным рассуждениям (и в этом смысле любая логика, в том числе и категориальная, оказывается бесполезной); в обратную сторону ситуация выглядит лучше - использование NTM с глубокой LSTM в качестве контроллера позволило ребятам из DeepMind реверс-инженирить решение mini-SHRDLU

PS

например

PS

категории к нейросетям применить можно, но я бы смотрел с сильно другой стороны. задача построения доказательства теоремы при наличии систем автоматической проверки корректности доказательства (Agda, Coq, Idris - они все в какой-то мере опираются на интуиционизм) хорошо ложится в q-learning (или в общем случае reinforcement learning). если у кого-то есть два-три года свободного для научной работы времени - это во всех смыслах богатая тема

Oℕ

нуу схемы рекурсий ещё до кметта в фп появились, это как минимум конец 80х

буду знать

A

категории к нейросетям применить можно, но я бы смотрел с сильно другой стороны. задача построения доказательства теоремы при наличии систем автоматической проверки корректности доказательства (Agda, Coq, Idris - они все в какой-то мере опираются на интуиционизм) хорошо ложится в q-learning (или в общем случае reinforcement learning). если у кого-то есть два-три года свободного для научной работы времени - это во всех смыслах богатая тема

Спасибо!

KV

буду знать

А в С++ их до сих пор нет

Извините

Извините

Oℕ

Ничего, Кирилл, ничего

λ

В хаскеле есть рок-звезда мессия, затащившая похоже, почти весь теоркат, который вообще только можно натянуть на ЯП в его инкарнации 5 лет назад. Некоторые из вещей вполне прагматично юзабельны, типа оптик (lens) и абстракций над независимыми (ко)индуктивными типами (recursion schemes)

Я думал, что это Киселёв всё фп вообще придумал

Oℕ

Я не припомню у Киселёва работ сильно вдохновлённых теоркатом

P

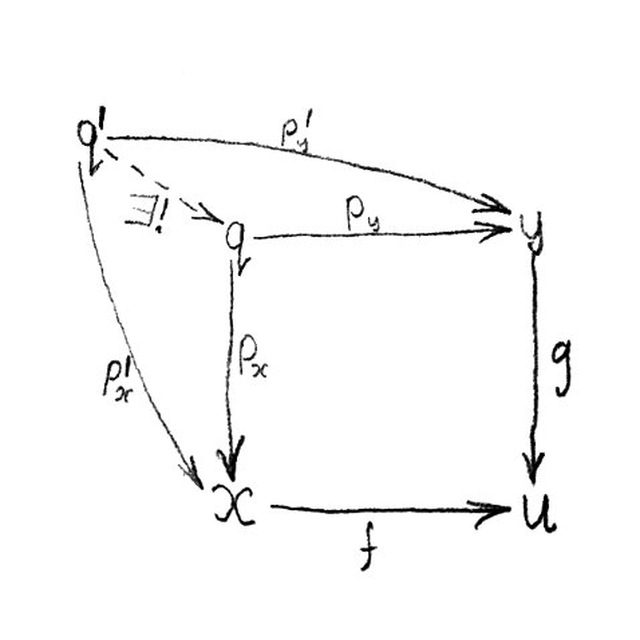

вот у меня есть f (линейное отображение) и двойственное к нему f*

как они категорно связаны (в категории линейных пространств)?

как они категорно связаны (в категории линейных пространств)?

Oℕ

Я так немножко почитал, есть ощущение, что двойственное пространство - это контравариантный хом-функтор

Oℕ

А соответственно связь двойственного отображения и основного - это частный случай контравариантной yoneda embeddding

Oℕ

Прошу прощения, если чушь сказал. В линалге ничё не смыслю