AP

Size: a a a

2018 February 21

так она обучается по градиенту критика, я что-то не пойму куда там L2 вставлять

DP

У тебя же в dpg градиент перформанса это dpi/dtheta * dQ/da вроде, нет? К нему нужно добавить градиент по theta L2-нормы предактиваций

AP

ага, понял, спасибо)

AP

L2 что-то совсем не помогла, агент тупо перестает учится с ней

LY

Ты настраивал коэффициент при ней?

AP

да, брал от 1 до 1e-4, при 1e-4 почти никакого влияния уже нет, значения улетают за диапазон

AP

но и обучения почему-то особого нет

c

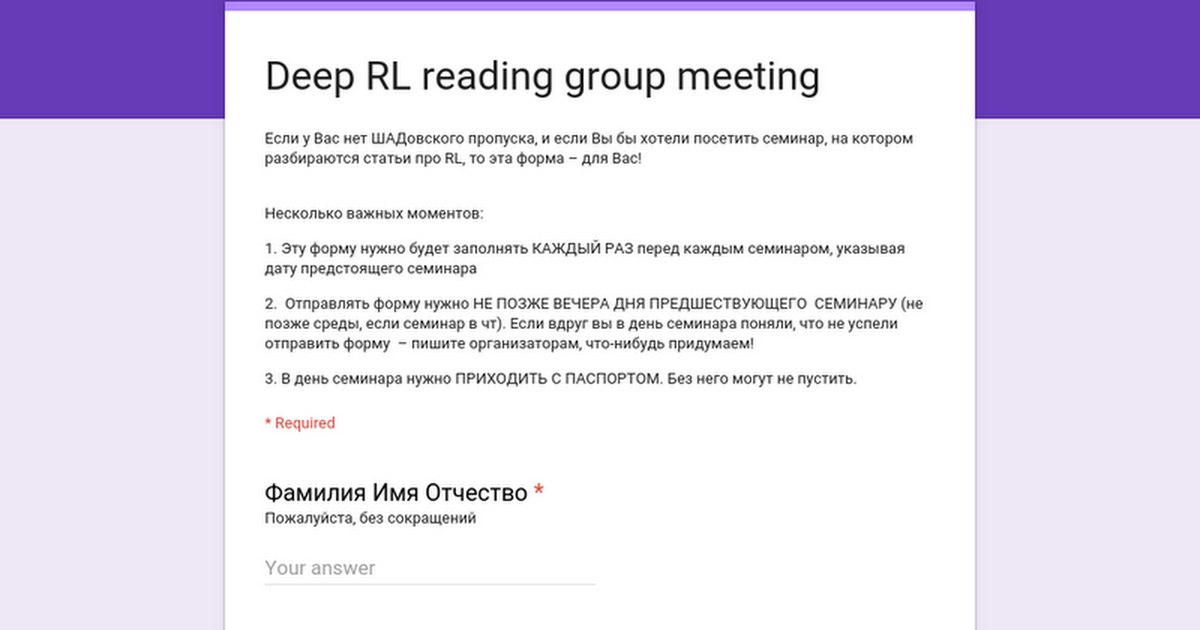

Коллеги, добрый вечер!

Завтра на семинаре выступит с докладом Александр Фрицлер

Rainbow: Combining Improvements in Deep Reinforcement Learning

Семинар, как обычно, в 19:00, в Стенфорде

Многие наверняка думали о том, чтобы скомбинировать всевозможные улучшения DQN в один алгоритм. А авторы Rainbow не ограничились мечтаниями, они взяли и сделали это! Подробности, результаты экспериментов и другое вы сможете узнать на самом докладе.

Регистрация на семинар по ссылке:

https://goo.gl/forms/n8ueMHhbv4nsIUm52

Не забудьте зарегистрироваться до вечера сегодняшнего дня, если хотите прийти!

Завтра на семинаре выступит с докладом Александр Фрицлер

Rainbow: Combining Improvements in Deep Reinforcement Learning

Семинар, как обычно, в 19:00, в Стенфорде

Многие наверняка думали о том, чтобы скомбинировать всевозможные улучшения DQN в один алгоритм. А авторы Rainbow не ограничились мечтаниями, они взяли и сделали это! Подробности, результаты экспериментов и другое вы сможете узнать на самом докладе.

Регистрация на семинар по ссылке:

https://goo.gl/forms/n8ueMHhbv4nsIUm52

Не забудьте зарегистрироваться до вечера сегодняшнего дня, если хотите прийти!

АС

да, брал от 1 до 1e-4, при 1e-4 почти никакого влияния уже нет, значения улетают за диапазон

Знак не перепутал? (-:

AP

Неа, проверил

A

L2 что-то совсем не помогла, агент тупо перестает учится с ней

Может ещё инициализация весов неудачная. Ну и банально learning rate можно покрутить.

AP

попробую, но он и так маленький, 1е-4, сначала значения как раз небольшие, но потом вырастают достаточно быстро

A

Хм. Ну "маленький"-понятие относительное. Ещё банальный совет-может быть стоит где-то среднее взять вместо суммы (если суммируете награды, например), помогает стабилизировать ситуацию иногда.

AP

Я не суммирую)

A

Тогда не актуально) Кстати, ещё... может быть стоит слишком агрессивное угасание наград?

A

Просто алгоритм ведёт себя "близоруко", судя по описанию.

AP

у меня награда на каждом шаге, за приближение к точке

AP

по сути скорость уменьшения расстояния до цели

A

Хм... Может просто негативное расстояние до точки взять?

AP

видел такое в статьях, не думал, что это может помочь