G

Size: a a a

2020 May 03

2020 May 05

I

Кто знает работающие способы парсить инфу с zakupki.gov.ru ?

Там, кажется, есть какое-то хитрое кэширование/защита:

если просто парсить (дергая страницы curl'ом, условно), то часто упираешься в 403 forbidden. При это если страницу запросить через браузер (кажется важно наличие JS), то страница "оживает", и после этого отдается и curl'у, вместо 403. Но упирается в какую-нибудь следующую) Обойти это так и не получилось.

Там, кажется, есть какое-то хитрое кэширование/защита:

если просто парсить (дергая страницы curl'ом, условно), то часто упираешься в 403 forbidden. При это если страницу запросить через браузер (кажется важно наличие JS), то страница "оживает", и после этого отдается и curl'у, вместо 403. Но упирается в какую-нибудь следующую) Обойти это так и не получилось.

f

Ivan

Кто знает работающие способы парсить инфу с zakupki.gov.ru ?

Там, кажется, есть какое-то хитрое кэширование/защита:

если просто парсить (дергая страницы curl'ом, условно), то часто упираешься в 403 forbidden. При это если страницу запросить через браузер (кажется важно наличие JS), то страница "оживает", и после этого отдается и curl'у, вместо 403. Но упирается в какую-нибудь следующую) Обойти это так и не получилось.

Там, кажется, есть какое-то хитрое кэширование/защита:

если просто парсить (дергая страницы curl'ом, условно), то часто упираешься в 403 forbidden. При это если страницу запросить через браузер (кажется важно наличие JS), то страница "оживает", и после этого отдается и curl'у, вместо 403. Но упирается в какую-нибудь следующую) Обойти это так и не получилось.

Неужели надо пользоваться phantomjs :(

I

с PhantomJS понятно, но потребует более мощного хостинга(

Хотелось бы убедиться что нет других способов.

Хотелось бы убедиться что нет других способов.

VS

PhantomJS уже лет пять никто не использует, есть headless Chrome.

Курлом в лоб дёргать тоже занятие бесполезное.

Ибо куки, ибо юзер агент

Курлом в лоб дёргать тоже занятие бесполезное.

Ибо куки, ибо юзер агент

I

юзерагент в curl можно подставить, куки, в принципе, тоже. но зависимости поведения сайта от них я не обнаружил

I

именно от JS оживает

VS

Ivan

юзерагент в curl можно подставить, куки, в принципе, тоже. но зависимости поведения сайта от них я не обнаружил

конечно, можно подставить.

Только вы либо тратите мыслительные ресурсы на изобретение велосипеда, на эмуляцию асинхронных запросов, ещё чего-нить, либо на решение задачи

Только вы либо тратите мыслительные ресурсы на изобретение велосипеда, на эмуляцию асинхронных запросов, ещё чего-нить, либо на решение задачи

I

задача - получать данные по закупкам. по контрактам можно удобно брать на clearspending, а с аукционами проблема

G

Следят все за всеми...

- Эксперты обнаружили весьма инвазивное поведение браузеров Mi и Mint, поставляемых с мобильными устройствами Xiaomi. Они собирают достаточно данных, чтобы идентифицировать личность пользователя, едва шифруют эти данные и отправляют их на серверы, располагающиеся в Сингапуре и России, говорят исследователи

https://safe.cnews.ru/news/top/2020-05-05_xiaomi_sledit_za_polzovatelyami

- Эксперты обнаружили весьма инвазивное поведение браузеров Mi и Mint, поставляемых с мобильными устройствами Xiaomi. Они собирают достаточно данных, чтобы идентифицировать личность пользователя, едва шифруют эти данные и отправляют их на серверы, располагающиеся в Сингапуре и России, говорят исследователи

https://safe.cnews.ru/news/top/2020-05-05_xiaomi_sledit_za_polzovatelyami

G

Британский музей открывает онлайн-доступ

- более чем половина объектов своей коллекции (4,5 миллиона единиц). Из них 1,9 миллиона изображений доступны по лицензии Creative Commons 4.0.

https://www.britishmuseum.org/collection

- более чем половина объектов своей коллекции (4,5 миллиона единиц). Из них 1,9 миллиона изображений доступны по лицензии Creative Commons 4.0.

https://www.britishmuseum.org/collection

NK

Тем временем Bloomberg запустил свой трекер восстановления экономики [1], в основном на альтернативных данных:

- новые случаи COVID-19

- индекс закрытия (Lockdown Index)

- запросы на пособие по безработице

- число поездок общественным транспортом

- ипотечные запросы

- удобство потребителей

- продажи в тех же магазинах (непонятный критерий)

- бронирования в ресторанах

- активные нефтяные скважины

- производство стали

- индекс S&P

- финансовое состояние рынка

Почти все индексы негосударственные, основанные на альтернативных данных.

Ссылки:

[1] https://www.bloomberg.com/graphics/recovery-tracker/

- новые случаи COVID-19

- индекс закрытия (Lockdown Index)

- запросы на пособие по безработице

- число поездок общественным транспортом

- ипотечные запросы

- удобство потребителей

- продажи в тех же магазинах (непонятный критерий)

- бронирования в ресторанах

- активные нефтяные скважины

- производство стали

- индекс S&P

- финансовое состояние рынка

Почти все индексы негосударственные, основанные на альтернативных данных.

Ссылки:

[1] https://www.bloomberg.com/graphics/recovery-tracker/

DS

2020 May 06

NK

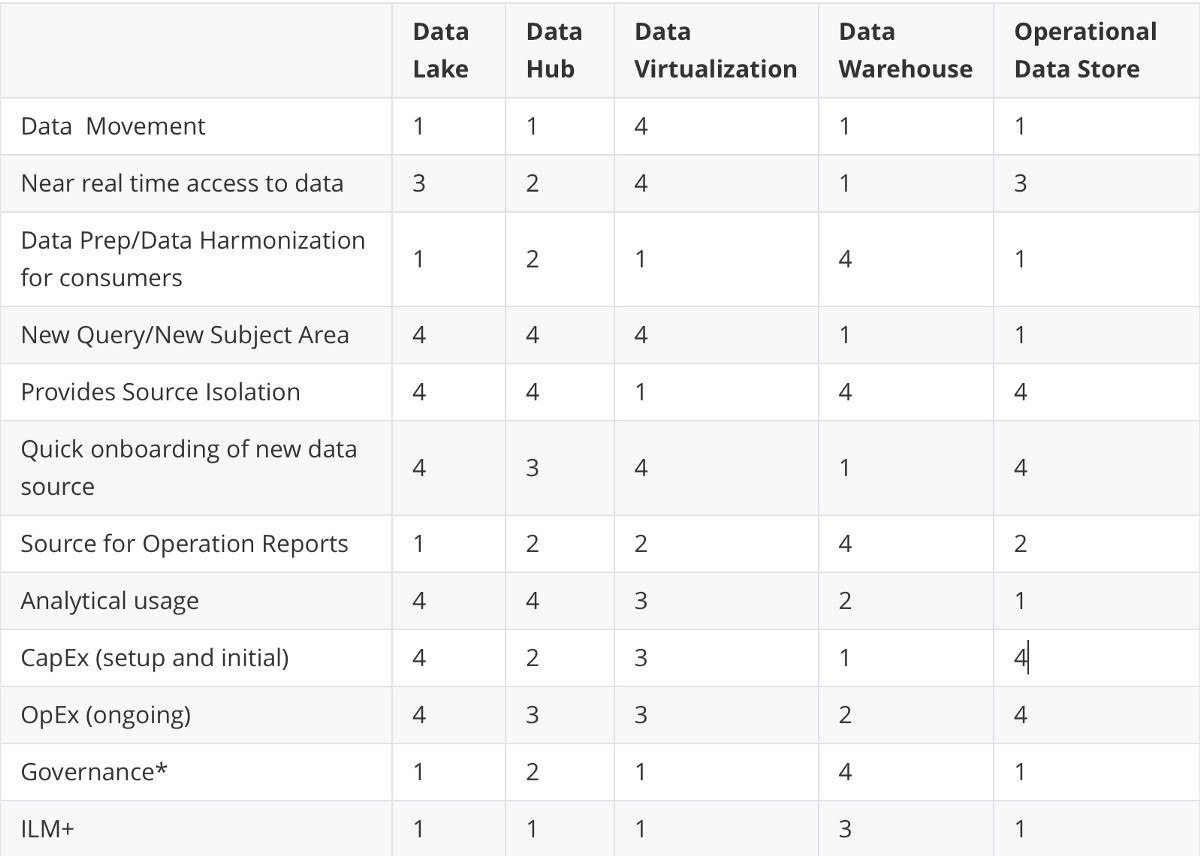

Очень часто приходится слышать термины Data Warehouse, Data Lake, Data Hub, при этом часто произносящие их не задумываются о реальных отличиях этих понятий. В блоге The Startup на Medium хороший обзор на английском [1] об отличии и сходствах таких понятий как:

- Data Lake

- Data Hub

- Data Virtualization / Data Federation

- Data Warehouse

- Operational Data Store

Все отличия объяснены на редкость доходчиво, я как-нибудь найду время перевести этот текст на русский язык.

Краткий ликбез такой:

- Data Lake (Озеро данных) - это несвязанные данные удобные для data science и аналитической работы. Работает в ситуации возникновения задач и адаптации данных под конкретные задачи.

- Data Hub - это данные собранные в одно хранилище с некоторой работой по преобразованию и обработке. Больше форматирования, контроля и управления по сравнениею с озером данных.

- Data Virtualization/Data Federation - это пробрасывание виртуальных связей между источниками, иногда уже начало ведение общих справочников. Больше ориентировано на данные реального времени и интеграцию

- Data Warehouse - наиболее подходит для подготовки управленческих отчетов, готовится на основе масштабной обработки данных, контроля справочников и так далее. Очень негибко, но наиболее пригодно к управлению циклом жизни данных

- Operational Data Store - это, как правила, зеркала для хранения транзакционных баз данных чтобы не затрагивать сами базы данных работающих в режиме реального времени.

Ссылки:

[1] https://medium.com/swlh/the-5-data-store-patterns-data-lakes-data-hubs-data-virtualization-data-federation-data-27fd75486e2c

#opendata #data #datalakes #datamanagement #datagovernance

- Data Lake

- Data Hub

- Data Virtualization / Data Federation

- Data Warehouse

- Operational Data Store

Все отличия объяснены на редкость доходчиво, я как-нибудь найду время перевести этот текст на русский язык.

Краткий ликбез такой:

- Data Lake (Озеро данных) - это несвязанные данные удобные для data science и аналитической работы. Работает в ситуации возникновения задач и адаптации данных под конкретные задачи.

- Data Hub - это данные собранные в одно хранилище с некоторой работой по преобразованию и обработке. Больше форматирования, контроля и управления по сравнениею с озером данных.

- Data Virtualization/Data Federation - это пробрасывание виртуальных связей между источниками, иногда уже начало ведение общих справочников. Больше ориентировано на данные реального времени и интеграцию

- Data Warehouse - наиболее подходит для подготовки управленческих отчетов, готовится на основе масштабной обработки данных, контроля справочников и так далее. Очень негибко, но наиболее пригодно к управлению циклом жизни данных

- Operational Data Store - это, как правила, зеркала для хранения транзакционных баз данных чтобы не затрагивать сами базы данных работающих в режиме реального времени.

Ссылки:

[1] https://medium.com/swlh/the-5-data-store-patterns-data-lakes-data-hubs-data-virtualization-data-federation-data-27fd75486e2c

#opendata #data #datalakes #datamanagement #datagovernance

G

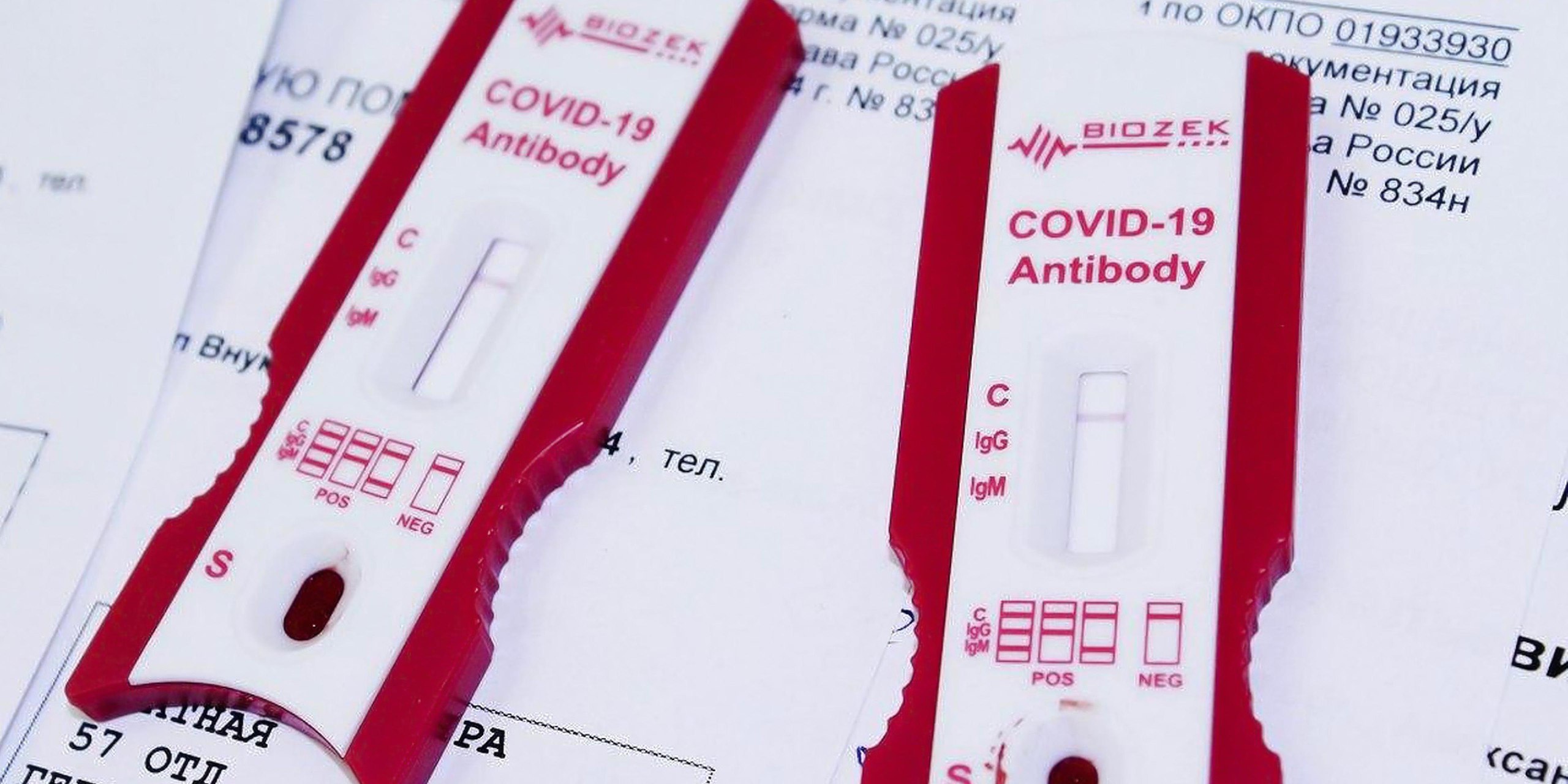

Закупили, да не то, оказалось.

https://www.istories.media/investigations/2020/05/06/testi-s-opasnoi-pogreshnostyu/

https://www.istories.media/investigations/2020/05/06/testi-s-opasnoi-pogreshnostyu/

ДK

https://www.internationalbudget.org/sites/default/files/country-surveys-pdfs/2019/open-budget-survey-russia-2019-en.pdf

РФ-то уже на 13м месте в мире по раскрытию публичных финансов, чтобы это не значило))

полный отчет по ссылке https://www.internationalbudget.org/open-budget-survey/open-budget-survey-2019-0

РФ-то уже на 13м месте в мире по раскрытию публичных финансов, чтобы это не значило))

полный отчет по ссылке https://www.internationalbudget.org/open-budget-survey/open-budget-survey-2019-0

IB

https://www.internationalbudget.org/sites/default/files/country-surveys-pdfs/2019/open-budget-survey-russia-2019-en.pdf

РФ-то уже на 13м месте в мире по раскрытию публичных финансов, чтобы это не значило))

полный отчет по ссылке https://www.internationalbudget.org/open-budget-survey/open-budget-survey-2019-0

РФ-то уже на 13м месте в мире по раскрытию публичных финансов, чтобы это не значило))

полный отчет по ссылке https://www.internationalbudget.org/open-budget-survey/open-budget-survey-2019-0

Да, там несущественные изменения. Скорее сохранение текущего уровня открытости

NK

Для тех кто хочет сделать полезное в открытых данных, имеет свободное время и свободный английский - проект OpenRefine ищет специалиста/команду/компанию тех кто создаст им документацию по продукту [1]

В общей сложности они хотят сделать эту работу за 6 месяцев и 25 000 USD (примерно 1,86 миллиона рублей). Финансируется проект полностью из грантовых источников нескольких фондов Кремниевой долины. В частности из фонда Чан-Цукерберг по поддержке науки.

OpenRefine хороший проект, важная часть многих академических проектов по созданию инфраструктуры данных. Например, они активно используются в австралийском Data61 CSIRO. Однако у команды которая им занималась с самого начала не задалась коммерциализация и попытки создать онлайн сервис для Data wrangling (Манипулирования данными) не увенчались успехом. Сейчас они все ещё предлагают услуги в виде компании RefinePro [2], но не то чтобы заметны на рынке.

Сам проект происходит из когда-то выложенного в виде открытого кода проекта Google Refine [3]. Ранее он был разработан в Metaweb , компании занимавшейся проектом Freebase, пожалуй, одним из наиболее успешных стартапов занимавшихся связанными данными и выкупленной Google в 2010 году.

Ссылки:

[1] http://openrefine.org/blog/2020/04/23/documentation-hire.html

[2] https://refinepro.com

[3] https://en.wikipedia.org/wiki/OpenRefine

#opendata #openrefine #datajobs

В общей сложности они хотят сделать эту работу за 6 месяцев и 25 000 USD (примерно 1,86 миллиона рублей). Финансируется проект полностью из грантовых источников нескольких фондов Кремниевой долины. В частности из фонда Чан-Цукерберг по поддержке науки.

OpenRefine хороший проект, важная часть многих академических проектов по созданию инфраструктуры данных. Например, они активно используются в австралийском Data61 CSIRO. Однако у команды которая им занималась с самого начала не задалась коммерциализация и попытки создать онлайн сервис для Data wrangling (Манипулирования данными) не увенчались успехом. Сейчас они все ещё предлагают услуги в виде компании RefinePro [2], но не то чтобы заметны на рынке.

Сам проект происходит из когда-то выложенного в виде открытого кода проекта Google Refine [3]. Ранее он был разработан в Metaweb , компании занимавшейся проектом Freebase, пожалуй, одним из наиболее успешных стартапов занимавшихся связанными данными и выкупленной Google в 2010 году.

Ссылки:

[1] http://openrefine.org/blog/2020/04/23/documentation-hire.html

[2] https://refinepro.com

[3] https://en.wikipedia.org/wiki/OpenRefine

#opendata #openrefine #datajobs

IB

Закупили, да не то, оказалось.

https://www.istories.media/investigations/2020/05/06/testi-s-opasnoi-pogreshnostyu/

https://www.istories.media/investigations/2020/05/06/testi-s-opasnoi-pogreshnostyu/

Это к данным почти никакого отношения не имеет

IB

Да и к государству тоже небольшое, только в части госзаказа на эти тесты