Google всегда уверял, что не вмешивается работу своего поискового алгоритма. Оказалось, что это не так

Каждую минуту пользователи вводят около 3,8 млн. запросов в поисковую строку Google. Полагаясь на его алгоритмы, они надеются получить релевантные результаты о ценах на отели или лечении от рака, или о последних новостях политики.

Влияние этих строк кода на глобальную экономику поистине огромно: миллионы людей обращаются к информации, найденной в Интернете, и именно она является отправной точкой для денежных потоков в миллиарды долларов.

Руководители Google неоднократно заявляли, – в том числе в свидетельских показаниях в Конгрессе - что алгоритмы являются объективными и, по сути, автономными, не подверженными человеческим предрассудкам или коммерческим соображениям.

Компания заявляет, что люди не влияют на поисковую выдачу и ранжирование результатов. Журналисты WSJ

выяснили, что в последнее время Google все больше вмешивается в результаты поиска — и в гораздо большей степени, чем компания признает публично.

Часто это происходит под давлением со стороны крупного бизнеса и правительств различных стран. Google стал чаще прибегать к подобным действиям после выборов 2016 года в США и скандалов о дезинформации в Интернете.

По словам одного из руководителей Google, который занимается поиском, внутреннее расследование 2016 года в Google показало, что до четверти поисковых запросов возвращают какую-то дезинформацию. В процентном отношении это не так уж и много, но, учитывая огромный объем поисковых запросов в Google, это составило бы почти два миллиарда поисковых запросов в год. Для сравнения: роль Facebook оказалась предметом слушаний Конгресса после скандала с российской дезинформацией, которую просмотрели 126 миллионов пользователей.

Кратко о том, что выяснили журналисты издания:

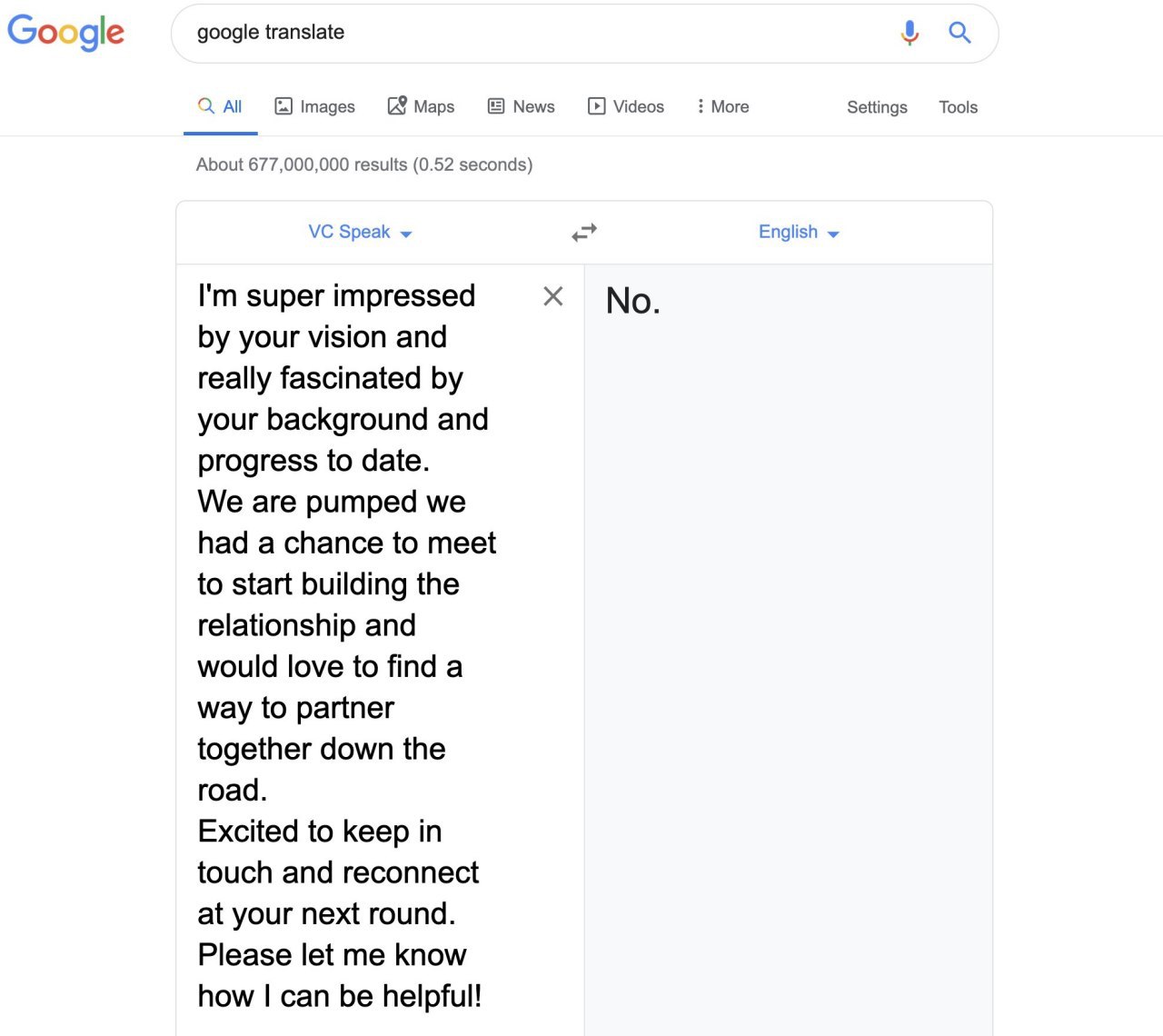

• Алгоритмы поиска отдают предпочтение крупным компаниям по сравнению с более мелкими, поддерживая некоторые крупные веб-сайты, такие как

Amazon.com Inc. и Facebook Inc

• Инженеры Google регулярно вносят скрытые коррективы в информацию, которую компания все чаще размещает параллельно основным результатам поиска: в предложения по автозаполнению, в так называемые «панели знаний» и «избранные фрагменты», в результаты новостей.

• Существуют чёрные списки для удаления из результатов поиска некоторых сайтов. И это не касается случаев, когда сайты блокируются из-за нарушения законодательства США или других стран.

• В режиме автозаполнения - функции, которая предсказывает слова по мере того, как пользователь вводит запрос, – инженеры Google создали алгоритмы и чёрные списки, чтобы отсеять сомнительные с точки зрения компании предложения по спорным вопросам.

• Сотрудники и руководители Google, включая соучредителей Ларри Пейджа и Сергея Брина, не пришли к единому мнению о том, в какой степени стоит вмешиваться в результаты поиска.

• Для оценки результатов поиска в Google работают тысячи низкооплачиваемых подрядчиков, цель которых, по словам компании, заключается в оценке качества алгоритмов ранжирования. Подрядчики утверждаю: компания даёт им понять, что именно она считает правильным ранжированием результатов.