Size: a a a

2017 July 24

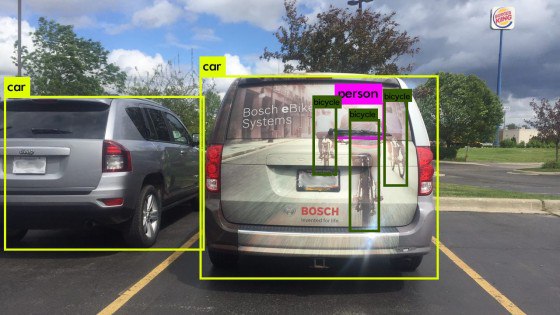

Кратко: хорошая иллюстрация на тему некоторых проблем машинного зрения в области автономного транспорта на дорогах общего пользования https://www.technologyreview.com/s/608321/this-image-is-why-self-driving-cars-come-loaded-with-many-types-of-sensor/ #ai #selfdriving #cars

2017 July 25

Видео-интервью с полей Faculty Summit: Krysta Svore и Nathan Wiebe рассказывают о перспективах квантовых вычислений в задачах машинного обучения https://channel9.msdn.com/Shows/Microsoft-Research/Research-in-Focus-Transforming-Machine-Learning-and-Optimization-through-Quantum-Computing #quantum #computing #ai #cloud

Я почти ничего не понимаю в вычислительной биологии, но прогресс технологий впечатляет — группа ученых из Университета Вашингтона и Microsoft Research "собрала" вычислительную плату из синтетических фрагментов ДНК. https://www.microsoft.com/en-us/research/blog/researchers-build-nanoscale-computational-circuit-boards-dna/ #computational #biology #dna #circuit

А вот в эту же тему. Обсуждали с одним из российских ритейлоеров электроники, что в некотором ближайшем будущем будут выигрывать те компании, которые смогут "проникнуть" в дом пользователя и получить инсайт, какая же у него электроника уже есть, как используется и т.п. И не сильно принципиально, как эта информация будет собрана: через умный дом от застройщика, умные розетки, мобильные приложения, ботов или смешанную реальность. Цифровая трансформация - она такая. Данные - новая нефть. :)

Помните такую компанию Roomba, которая делает пылесос iRobot? Так вот, судя по всему, roomba собираются продавать данные своих пользователей! И это не банальный адрес или телефон, это план квартир и домов, расстановка мебели и тп. Говорят в качестве покупателя могут выступить Amazon, Apple или Alphabet

(Да, все на А).

Совершенно не удивлюсь, если через какое-то время будут продаваться так же наборы данных о расположении моих носков под кроватью :(

http://www.reuters.com/article/us-irobot-strategy-idUSKBN1A91A5

(Да, все на А).

Совершенно не удивлюсь, если через какое-то время будут продаваться так же наборы данных о расположении моих носков под кроватью :(

http://www.reuters.com/article/us-irobot-strategy-idUSKBN1A91A5

2017 July 26

The Verge пишет о том, что все больше и больше производителей втягивается в гонку AI с собственными чипсетами. Стратегия может отличаться, например, Qualcomm выпускает новый SDK - Neural Processing Engine, позволяющий ускорить решение некоторых задач (в частности, обработку изображений) и поддерживает популятные фреймворки (Caffe, Caffe2, TensorFlow) — все на уже существующих чипсетах. Один из первых клиентов - Facebook, ускоряющая с помощью NPE работу AR-фильтров в своих мобильных приложениях. https://www.theverge.com/2017/7/25/16024540/ai-mobile-chips-qualcomm-neural-processing-engine-sdk #ai #chipset #hardware

Исследовательский проект от Disney по отслеживанию реакции зрителей в зале на показ медиа-контента. Все как полагается - нейронные сети и анализ данных в привязке с видео/аудио дорожками. https://www.fastcodesign.com/90134144/disneys-next-movie-it-could-be-watching-you (P.s. Приятно понимать, что как раз в эти дни одна из российских команд Imagine Cup, от ВШЭ и при поддержки Яндекса, показывает на финале в США аналогичный проект, только нацеленный на анализ скучности лекций.) #ai #tracking #audience

2017 July 27

Важная тема для веб-резработчиков — коллеги опубликовали курс по Web Accessibility на EdX https://www.edx.org/course/introduction-web-accessibility-microsoft-dev240x #inclusive #design #web #accessibility

2017 July 28

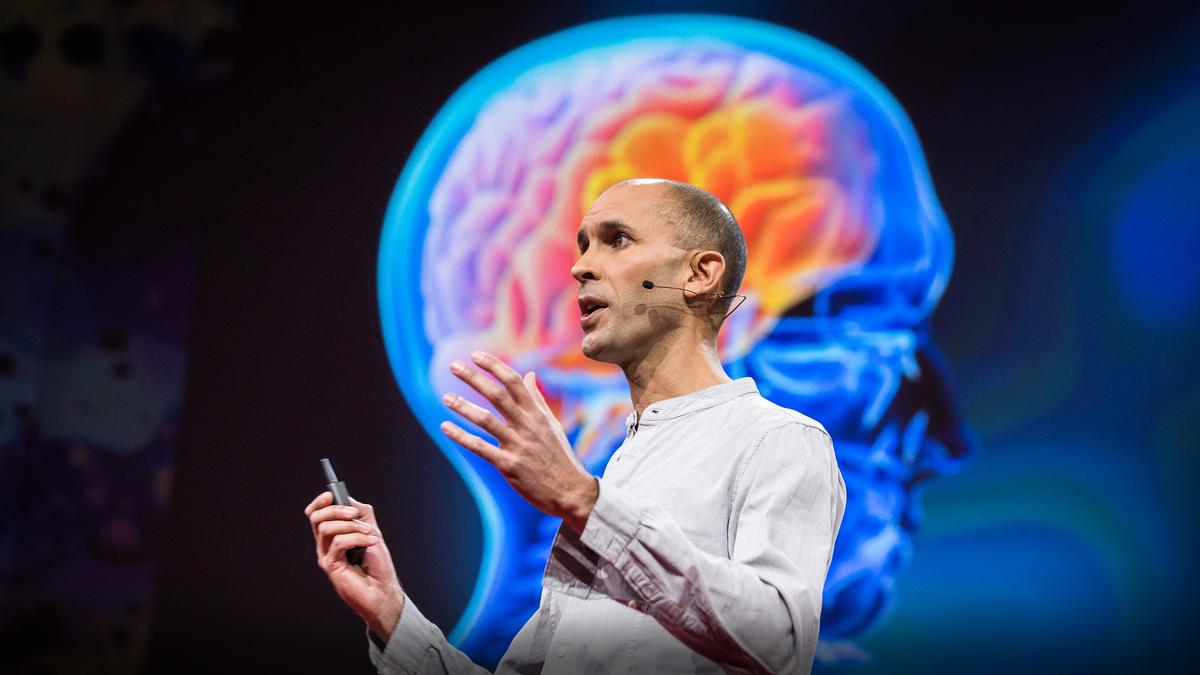

Anil Seth, когнитивный нейроученый (это дословный перевод, если что) из Университета Сассекса, рассказывает на TED, как наш мозг галлюционирует окружающую реальность. Два ключевых взгляда на сознательность.

Первый: мозг, интерпретирующий электрические сигналы от различных сенсоров и пытающийся предсказать развитие событий на основании врожденных схем и приобретенного опыта. Причем это встреченое предсказательное движение "генерирует" реальность в той же степени (если не больше), что и входящие сигналы. В этом смысле, если галлюцинация - это неконтролируемое восприятие, то (нормальное) восприятие — это контролируемая галлюцинация, которую мы называем реальностью.

Второе - что такое быть собой. Есть разные способы ощущать себя: через тело, вербально, социально и т.п. Но оказывается, что способность собирать эти ощущения в единое ощущение очень хрупка, и во многих исследованиях легко нарушается. При этом наше сознательное ощущение внутренного состояния — это также ощуение предсказания, насколько хорошо или плохо идут дела в нашем организме. Поэтому аналогично "внешним" галлюционациям, у нас могут быть и внутренние и это дает новый взгляд на различные психологические заболевания.

https://www.ted.com/talks/anil_seth_how_your_brain_hallucinates_your_conscious_reality #reality #brain #consciousness

Первый: мозг, интерпретирующий электрические сигналы от различных сенсоров и пытающийся предсказать развитие событий на основании врожденных схем и приобретенного опыта. Причем это встреченое предсказательное движение "генерирует" реальность в той же степени (если не больше), что и входящие сигналы. В этом смысле, если галлюцинация - это неконтролируемое восприятие, то (нормальное) восприятие — это контролируемая галлюцинация, которую мы называем реальностью.

Второе - что такое быть собой. Есть разные способы ощущать себя: через тело, вербально, социально и т.п. Но оказывается, что способность собирать эти ощущения в единое ощущение очень хрупка, и во многих исследованиях легко нарушается. При этом наше сознательное ощущение внутренного состояния — это также ощуение предсказания, насколько хорошо или плохо идут дела в нашем организме. Поэтому аналогично "внешним" галлюционациям, у нас могут быть и внутренние и это дает новый взгляд на различные психологические заболевания.

https://www.ted.com/talks/anil_seth_how_your_brain_hallucinates_your_conscious_reality #reality #brain #consciousness

В продолжение темы галлюцинирования, только теперь про машинный интеллект. Как вы помните или знаете, AI, алгоритмы машинного обучения и вот это всё, в грубом приближении, пытаются описать реальность, используя некоторые предсказательные модели.

Мы уже видели эксперименты с веселыми очками, которые обманывают алгоритмы компьютерного зрения. На днях я кидал ссылку на заметку с рекламой на автомобиле, которая может ввести в заблуждение алгоритмы распознавания объектов. И, в целом, сегодня таких экспериментов уже большое число, и на тему состязательных примеров (adversarial example), которые за счет небольших модификаций способны обманывать сеточки, пишется множество научных работ.

New Scientist пишет о новой работе исследователей из Facebook, которые описывают схожую технику (они ее называют Гудини, Houdine), которая добавляет незначательные (незаметные человеку) цифровые шумы в изображения и звуки, подаваемые в системы разпознавания голоса и машинного зрения. Все это в контексте, автономного транспорта, хотя пока и без практического подтвеждения в "боевых условиях".

Вывода отсюда два: 1) практическое применение — это вопрос времени и 2) нужны новые подходы к генерации устойчивых к таким фокусам сеточек.

https://www.newscientist.com/article/2142059-sneaky-attacks-trick-ais-into-seeing-or-hearing-whats-not-there (Ссылка на исследование: https://arxiv.org/pdf/1707.05373.pdf) #ai #hallucinations #machine #vision #houdine

Мы уже видели эксперименты с веселыми очками, которые обманывают алгоритмы компьютерного зрения. На днях я кидал ссылку на заметку с рекламой на автомобиле, которая может ввести в заблуждение алгоритмы распознавания объектов. И, в целом, сегодня таких экспериментов уже большое число, и на тему состязательных примеров (adversarial example), которые за счет небольших модификаций способны обманывать сеточки, пишется множество научных работ.

New Scientist пишет о новой работе исследователей из Facebook, которые описывают схожую технику (они ее называют Гудини, Houdine), которая добавляет незначательные (незаметные человеку) цифровые шумы в изображения и звуки, подаваемые в системы разпознавания голоса и машинного зрения. Все это в контексте, автономного транспорта, хотя пока и без практического подтвеждения в "боевых условиях".

Вывода отсюда два: 1) практическое применение — это вопрос времени и 2) нужны новые подходы к генерации устойчивых к таким фокусам сеточек.

https://www.newscientist.com/article/2142059-sneaky-attacks-trick-ais-into-seeing-or-hearing-whats-not-there (Ссылка на исследование: https://arxiv.org/pdf/1707.05373.pdf) #ai #hallucinations #machine #vision #houdine

Eсли у вас есть подписка на The Noun Project (это сайт с огромным количеством векторных иконок), то теперь вы можете поставить плагин к PowerPoint или Word, чтобы добавлять их напрямую в документы.

Тонкость момента, конечно, в подписке, которая стоит $40/год, о чем плагин напоминает очень быстро (потому что базовый набор иконок сильно ограничен). Об этом, в свою очередь, возмущенные пользователи спешат сообщить в комментариях в магазине.

В защиту проекта, отмечу, что на самом сайте все иконки можно скачать бесплатно, как в PNG, так и в SVG (кстати, напомню, что свежие версии наших офисных продуктов также поддерживают SVG), но... в лицензии Creative Commons, которая накладывает определенные требования к использованию (например, надо указывать авторов). Подписка же нужна исключительно для Royalty Free использования.

https://thenounproject.com/for-office/ #office #addins #icons

Тонкость момента, конечно, в подписке, которая стоит $40/год, о чем плагин напоминает очень быстро (потому что базовый набор иконок сильно ограничен). Об этом, в свою очередь, возмущенные пользователи спешат сообщить в комментариях в магазине.

В защиту проекта, отмечу, что на самом сайте все иконки можно скачать бесплатно, как в PNG, так и в SVG (кстати, напомню, что свежие версии наших офисных продуктов также поддерживают SVG), но... в лицензии Creative Commons, которая накладывает определенные требования к использованию (например, надо указывать авторов). Подписка же нужна исключительно для Royalty Free использования.

https://thenounproject.com/for-office/ #office #addins #icons

2017 July 31

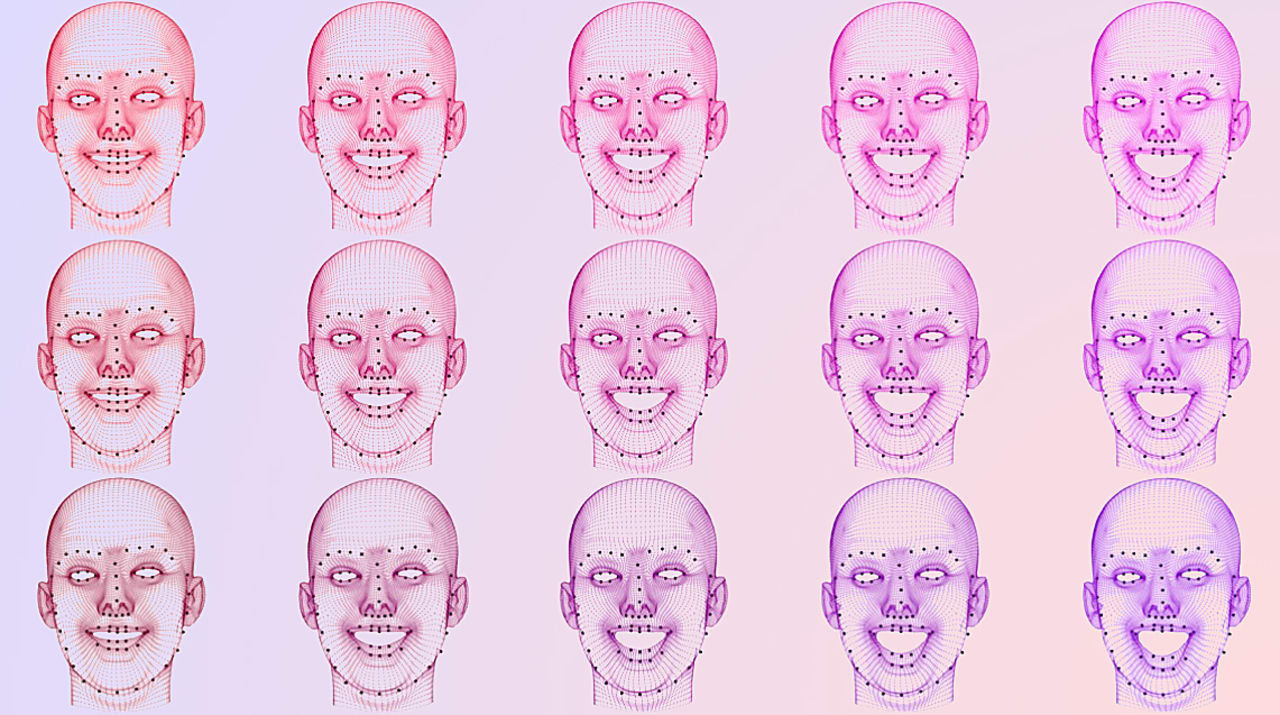

Пожалуй, самая большая проблема всего бума машинного обучения, искусственного интеллекта, когнитивных сервисов и т.д. лежит не в области составления конкретного алгоритма или накопления необходимого массива данных, а в том, как мы, как социум, к этому относимся.

Причем вопрос не только в уже растиражированном экономико-социальном аспекте вроде вытеснения отдельных профессий с рынка труда или, наоборот, усиления некоторых за счет новых возможностей, — но и в том, что именно мы как разработчики, ученые, интепретаторы, внедренцы и т.п. зашиваем в такие алгоритмы.

Время от времени я вижу на разных хакатонах, стартаперских тусовках и в лентах новостей проявления, например, такой идеи: а что, если по анализу фотографии (или видео-ряда) предсказывать хакактер человека? Его тип личности (интраверт, экстраверт и еще с десяток других систем), насколько он будет хорошим сотрудником, врет/не врет, кредитоспособность и много чего еще.

Все это называется физиогномикой и в широких кругах называется псевдонаукой, просторы которой простираются от банального шарлатанства всяких экстрасенсов до онаучненного оправдания расизма, с которым человечество то и дело сталкивается с самых разных формах.

Интересный вопрос — а какое отношение к этому имеет машинное обучение?

В прошлом году пара ученых из Китая Xiaolin Wu and Xi Zhang, — хотя страна тут не важна, потому что (и в этом главная проблема!) подобные работы плодятся по всему миру, — выкатили исследование о том, как с помощью натренерованной сеточки предсказать по фотографии человека, является ли он криминальным элементом или нет. При детальном рассмотрении оказывается, что в работу неявно (?) и, возможно, бессознательно, зашито очень много допущений и, в целом, неверных, предположений.

И хотя, даже здравый смысл, подсказывает, что невозможно по фотографии человека назвать его с 90% преступником, "научный" подход, объективность нейронных сетей, компьютеров, машинного обучения и вот этого всего — позволяют подвести достаточный фундамент для того, чтобы СМИ, социум и, что еще хуже, лица, принимающие соответствующие решения, приняли это все на веру.

===

Так вот, на этот счет и по поводу этого "исследования", в частности - большая детальная статья за авторством Blaise Agüera y Arcas, Margaret Mitchell и Alexander Todorov (на английском).

Потратьте 30-40 минут своего времени. Это важно. Я бы даже сказал, что это одна из самых важных статей на тему машинного обучения за последнее время — "Новые одеяния физиогномики"

https://medium.com/@blaisea/physiognomys-new-clothes-f2d4b59fdd6a #machine #learning #ai #bias

===

P.s. Очевидно все это касается не только распознавания лиц, но и вообще любых других ситуаций, когда мы переносим принятие решения на компьютер и как бы снимаем с себя ответственность (потому что "машина не может ошибаться"). Вот тут всегда должен стоять вопрос — а на заложили ли мы в данные и алгоритмы существующие в обществе стереотипы? Не закрепили ли мы в сеточке существующее неравенство, придав ему научного шарма и оправдания?

Причем вопрос не только в уже растиражированном экономико-социальном аспекте вроде вытеснения отдельных профессий с рынка труда или, наоборот, усиления некоторых за счет новых возможностей, — но и в том, что именно мы как разработчики, ученые, интепретаторы, внедренцы и т.п. зашиваем в такие алгоритмы.

Время от времени я вижу на разных хакатонах, стартаперских тусовках и в лентах новостей проявления, например, такой идеи: а что, если по анализу фотографии (или видео-ряда) предсказывать хакактер человека? Его тип личности (интраверт, экстраверт и еще с десяток других систем), насколько он будет хорошим сотрудником, врет/не врет, кредитоспособность и много чего еще.

Все это называется физиогномикой и в широких кругах называется псевдонаукой, просторы которой простираются от банального шарлатанства всяких экстрасенсов до онаучненного оправдания расизма, с которым человечество то и дело сталкивается с самых разных формах.

Интересный вопрос — а какое отношение к этому имеет машинное обучение?

В прошлом году пара ученых из Китая Xiaolin Wu and Xi Zhang, — хотя страна тут не важна, потому что (и в этом главная проблема!) подобные работы плодятся по всему миру, — выкатили исследование о том, как с помощью натренерованной сеточки предсказать по фотографии человека, является ли он криминальным элементом или нет. При детальном рассмотрении оказывается, что в работу неявно (?) и, возможно, бессознательно, зашито очень много допущений и, в целом, неверных, предположений.

И хотя, даже здравый смысл, подсказывает, что невозможно по фотографии человека назвать его с 90% преступником, "научный" подход, объективность нейронных сетей, компьютеров, машинного обучения и вот этого всего — позволяют подвести достаточный фундамент для того, чтобы СМИ, социум и, что еще хуже, лица, принимающие соответствующие решения, приняли это все на веру.

===

Так вот, на этот счет и по поводу этого "исследования", в частности - большая детальная статья за авторством Blaise Agüera y Arcas, Margaret Mitchell и Alexander Todorov (на английском).

Потратьте 30-40 минут своего времени. Это важно. Я бы даже сказал, что это одна из самых важных статей на тему машинного обучения за последнее время — "Новые одеяния физиогномики"

https://medium.com/@blaisea/physiognomys-new-clothes-f2d4b59fdd6a #machine #learning #ai #bias

===

P.s. Очевидно все это касается не только распознавания лиц, но и вообще любых других ситуаций, когда мы переносим принятие решения на компьютер и как бы снимаем с себя ответственность (потому что "машина не может ошибаться"). Вот тут всегда должен стоять вопрос — а на заложили ли мы в данные и алгоритмы существующие в обществе стереотипы? Не закрепили ли мы в сеточке существующее неравенство, придав ему научного шарма и оправдания?

2017 August 01

Интересный кейс про использование VR в медицине: доктор Dawn Jewell - психолог из штата Колорадо, она использует наработки небольшого стартапа Limbix для лечения пациентов после психологических травм (иногда сопряженных с физическими). Например, некоторые люди после автоаварии боятся места происшествия, а через VR-шлем и Google Street View можно вернуться в нужную точку, сидя в уютном кресле и в сопровождении привычного голоса личного психолога. Второй пациент Jewell боится выходить из дома после нападения на улице, здесь снова можно постепенно прийти в себя, начиная с виртуальных прогулок. Там же: эксперты отмечают, что эксперименты вроде нахождения в виртуальной реальности на крыше небоскреба лучше тоже проводить в присутствии психолога. https://www.nytimes.com/2017/07/30/technology/virtual-reality-limbix-mental-health.html #vr #medicine #psy

В продолжение темы AI и этичности, в Futurism сделали классную инфографику по отчету Белого Дома (США) про искусственный интеллект (выпущенный в конце прошлого года). Ключевые моменты:

1) AI должен использоваться для пользы обществу, в том числе нужные открытые тренировочные наборы данных,

2) правительство должно поддерживать развитие и внедрение AI, включая исследовательские программы,

3) необходимо регулирование автономного транспорта, включая обновление законодательства),

4) нужно готовить новые поколения - от тренировки "вычислительного" мышления с детского сада до преподавания этичности, приватности и безопасности в технологичном мире,

5) использование AI должно помогать занятым людям, а не заменять их,

6) необходимо убедиться, что тренировочные данные не несут в себе предрассудков или других дискриминирующих мотивов,

7) при развитии технологий нужно помнить о глобальной безопасности - от охраны секретов и интеллектуальной собственности до учета этичности внедряемых технологий

https://futurism.com/images/white-house-ai-report-everything-you-need-to-know-infographic #ai #policy #white #house

1) AI должен использоваться для пользы обществу, в том числе нужные открытые тренировочные наборы данных,

2) правительство должно поддерживать развитие и внедрение AI, включая исследовательские программы,

3) необходимо регулирование автономного транспорта, включая обновление законодательства),

4) нужно готовить новые поколения - от тренировки "вычислительного" мышления с детского сада до преподавания этичности, приватности и безопасности в технологичном мире,

5) использование AI должно помогать занятым людям, а не заменять их,

6) необходимо убедиться, что тренировочные данные не несут в себе предрассудков или других дискриминирующих мотивов,

7) при развитии технологий нужно помнить о глобальной безопасности - от охраны секретов и интеллектуальной собственности до учета этичности внедряемых технологий

https://futurism.com/images/white-house-ai-report-everything-you-need-to-know-infographic #ai #policy #white #house

2017 August 02

Большая и очень важная тема - в Windows 10 появятся встроенные средства для управления интерфейсом глазами (Eye Control), включая специальный инструмент для симуляции нажатий (мыши) и поддержку ввода текста глазами с виртуальной клавиатуры. https://blogs.msdn.microsoft.com/accessibility/2017/08/01/from-hack-to-product-microsoft-empowers-people-with-eye-control-for-windows-10/ #windows #accessibility #inclusive #design

2017 August 04

Кратко: Case Western Reserve University (Clevelend, USA) и Boulevard Arts (музей в New York) думают на тему музеев будущего и, в частности, как притащить музейные экспонаты в каждый дом. Конечно, с помощью Hololens. http://thedaily.case.edu/new-microsoft-hololens-app-lets-users-examine-renowned-british-art-collections-anywhere-world/ #ar #mr #hololens #museum #art

Пятничный пост. Но обратите внимание, там внутри есть ссылка про то, как Deschutes Brewery, одна из крупнейших пивоваренных компаний США, использует решение на базе Hololens для улучшений контроля процесса производства пива. :) #mr #iot #ml #analytics #hololens

Друзья, с днём пива вас! :) Небольшая статья в нашем блоге на эту тему: https://aka.ms/clb_habr_334902_tlgm

2017 August 05

It is funny that I am able to open telegram and write this post with my eyes only. I just bought a Tobii Eye Tracker on Ozon and connected it to my laptop with latest builfd of Windows 10